1

METODE

STEEPEST DESCENT

DENGAN UKURAN

LANGKAH BARU UNTUK PENGOPTIMUMAN

NIRKENDALA

DJIHAD WUNGGULI

SEKOLAH PASCASARJANA INSTITUT PERTANIAN BOGOR

3

PERNYATAAN MENGENAI TESIS DAN

SUMBER INFORMASI SERTA PELIMPAHAN HAK CIPTA*

Dengan ini saya menyatakan bahwa tesis berjudul Metode Steepest Descent dengan Ukuran Langkah Baru utuk Pengoptimuman Nirkendala adalah benar karya saya dengan arahan dari komisi pembimbing dan belum diajukan dalam bentuk apa pun kepada perguruan tinggi mana pun. Sumber informasi yang berasal atau dikutip dari karya yang diterbitkan maupun tidak diterbitkan dari penulis lain telah disebutkan dalam teks dan dicantumkan dalam Daftar Pustaka di bagian akhir tesis ini.

Dengan ini saya melimpahkan hak cipta dari karya tulis saya kepada Institut Pertanian Bogor.

RINGKASAN

DJIHAD WUNGGULI. Metode Steepest Descent dengan Ukuran Langkah Baru untuk Pengoptimuman Nirkendala. Dibimbing oleh BIB PARUHUM SILALAHI dan SUGI GURITMAN.

Masalah pengoptimuman dapat dikategorikan dalam dua bagian yaitu pengoptimuman berkendala dan pengoptimuman nirkendala. Untuk menyelesaikan permasalahan pengoptimuman nirkendala, khususnya untuk fungsi nonlinear dapat digunakan metode steepest descent. Metode steepest descent merupakan prosedur paling mendasar yang diperkenalkan oleh Cauchy pada tahun 1847. Metode ini adalah metode gradien sederhana yang menggunakan vektor gradien untuk menentukan arah pencarian pada setiap iterasi. Kemudian, dari arah tersebut akan ditentukan besar ukuran langkahnya. Pada beberapa kasus, metode steepest descent ini memiliki kekonvergenan yang lambat menuju solusi optimum karena langkahnya berbentuk zig-zag. Hal ini menunjukkan bahwa masalah pemilihan ukuran langkah menjadi masalah penting. Penelitian tentang pencarian ukuran langkah diantaranya adalah metode Barzilai-Borwein, Alternatif Minimisasi dan metode Yuan.

Penelitian ini memiliki tiga tujuan utama yaitu: (1) merekonstruksi algoritme steepest descent, Barzilai-Borwein, Alternatif Minimisasi, dan algoritme Yuan; (2) memodifikasi metode steepest descent dengan ukuran langkah baru; dan (3) membandingkan secara eksperimental output dari modifikasi algoritme dengan metode steepest descent, Barzilai-Borwein, Alternatif Minimisasi, dan Yuan untuk kasus fungsi kuadratik ditinjau dari proses iterasi dan running time. Metode dalam penelitian ini disusun melalui tiga tahap, (1) melakukan telaah pustaka metode steepest descent klasik, metode Barzilai-Borwein, metode Alternatif Minimisasi dan metode Yuan, (2) memodifikasi ukuran langkah pada metode steepest descent dengan ukuran langkah yang baru, (3) mengimplementasikan algoritme tersebut menggunakan perangkat lunak. Kemudian dilakukan pengujian dan perbandingan untuk kasus fungsi kuadratik yang dibangkitkan secara acak.

Dalam penelitian ini dihasilkan dua modifikasi ukuran langkah baru disebut Algoritme (4.5) dan Algoritme (4.6). Kedua modifikasi ini merupakan gabungan dari metode steepest descent dan metode Yuan. Dari rata-rata hasil perbandingan masalah fungsi kuadratik untuk semua dimensi metode steepest descent memberikan kinerja yang buruk dibandingkan dengan metode lainnya. Selanjutnya pada masalah dengan dimensi yang kecil, metode Yuan mampu menemukan solusi nilai minimum dengan iterasi dan running time yang terkecil. Meskipun demikian Algoritme (4.5) dan (4.6) mampu menyeimbangi kecepatan metode Yuan dan mampu mengungguli hasil dari metode Barzilai-Borwein, serta metode Alternatif Minimisasi. Untuk kasus fungsi kuadratik dengan dimensi yang besar, metode Yuan memberikan hasil yang buruk. Sedangkan, Algoritme (4.5) dan (4.6) menghasilkan iterasi dan running time yang terkecil, hal ini disebabkan oleh tingkat konvergensi yang lebih cepat pada kedua metode ini.

5

SUMMARY

DJIHAD WUNGGULI. Steepest Descent Method with New Step Size for Unconstrained Optimization. Supervised by BIB PARUHUM SILALAHI and SUGI GURITMAN.

The problem of optimization could be categorized into constrained and unconstrained optimization. The unconstrained optimization problem especially nonlinear function can be solved by steepest descent method. This is a basic procedure as introduced by Cauchy in 1847. It is a simple gradient method that uses gradient vector to determine the search direction in its iteration. Furthermore, from the direction will be determined the size of the step. In many cases, the steepest descent method has a slow convergence towards the optimum solution because of a zigzag steps. It involved indicates that the selection of step size problem is an important issue. There are many studies conducted on searching the step size in the steepest descent method, such as in Barzilai-Borwein, Alternative Minimization and Yuan method.

This research has three main objectives: (1) reconstructing the method of steepest descent, Barzilai-Borwein, Alternative Minimization, and the Yuan algorithms; (2) modifying the method of steepest descent by using new step sizes; and (3) comparing experimentally results of modification algorithms steepest descent, Barzilai-Borwein, Alternative Minimization, and Yuan method for quadratic function in terms of the iteration and running time process. This research composed in three stages method, (1) reviewing literatures on the classic steepest descent, Barzilai-Borwein, Alternative Minimization, and Yuan method, (2) modifying the step size in the steepest descent method by new step sizes, (3) computer implementation using software. Furthermore, testing and compared results was carried out using the quadratic function cases that generated randomly.

This research has two new step size modifications known as Algorithm (4.5) and (4.6). Both of them are combination of steepest descent and Yuan method. The average results of comparison quadratic function for all steepest descent method dimensions give poor performance compared to the other methods. While for the problem of small dimensions, the Yuan method reached the minimum value solutions with the iteration number and the running time minimum. Nevertheless, the Algorithm (4.5) and (4.6) able to compete the speed of Yuan method and perform better than the Barzilai-Borwein and Alternative Minimization method. For the quadratic functions case with large dimensions, Yuan method gives bad results. While Algorithm (4.5) and (4.6) produce the smallest of iteration and running time than the other methods, it is happen because this is related with the convergence speed within the Algorithm (4.5) and Algorithm (4.6).

©

Hak Cipta Milik IPB, Tahun 2015

Hak Cipta Dilindungi Undang-Undang

Dilarang mengutip sebagian atau seluruh karya tulis ini tanpa mencantumkan atau menyebutkan sumbernya. Pengutipan hanya untuk kepentingan pendidikan, penelitian, penulisan karya ilmiah, penyusunan laporan, penulisan kritik, atau tinjauan suatu masalah; dan pengutipan tersebut tidak merugikan kepentingan IPB

7

Tesis

sebagai salah satu syarat untuk memperoleh gelar Magister Sains

pada

Program Studi Matematika Terapan

SEKOLAH PASCASARJANA INSTITUT PERTANIAN BOGOR

BOGOR 2015

METODE

STEEPEST DESCENT

DENGAN UKURAN

LANGKAH BARU UNTUK PENGOPTIMUMAN

NIRKENDALA

9

Judul Tesis : Metode Steepest Descent dengan Ukuran Langkah Baru untuk Pengoptimuman Nirkendala

Nama : Djihad Wungguli

NIM : G551120031

Disetujui oleh Komisi Pembimbing

Dr Ir Bib Paruhum Silalahi, MKom Ketua

Dr Sugi Guritman Anggota

Diketahui oleh

Ketua Program Studi Matematika Terapan

Dr Jaharuddin, MS

Dekan Sekolah Pascasarjana

Dr Ir Dahrul Syah, MScAgr

PRAKATA

Puji dan syukur penulis panjatkan kepada Allah Subhanahu wa ta’ala atas segala nikmat dan karunia-Nya sehingga karya ilmiah ini berhasil diselesaikan. Tema yang dipilih dalam penelitian yang dilaksanakan sejak bulan Februari 2014 ini ialah teori optimasi, dengan judul Metode Steepest Descent dengan Ukuran Langkah Baru untuk Pengoptimuman Nirkendala. Penulisan tesis ini merupakan salah satu syarat memperoleh gelar Magister Sains pada program studi Matematika Terapan Sekolah Pascasarjana Institut Pertanian Bogor.

Dalam proses penulisan tesis ini, penulis menyadari bahwa telah memperoleh dorongan dan bantuan baik moril maupun materil dari berbagai pihak untuk melengkapi keterbatasan-keterbatasan yang dimiliki penulis. Untuk itu, melalui kesempatan ini penulis ingin mengucapkan terima kasih dan rasa hormat yang sebesar-besarnya kepada:

1. Bapak Dr Ir Bib Paruhum Silalahi, MKom selaku pembimbing I dan Bapak Dr Sugi Guritman selaku pembimbing II.

2. Dr Jaharuddin, MS selaku Ketua Program Studi Matematika Terapan. 3. Seluruh dosen dan staf pegawai tata usaha Departemen Matematika.

4. Direktorat Jenderal Pendidikan Tinggi (DIKTI) sebagai sponsor Beasiswa Unggulan.

5. Ayahanda dan Ibunda tercinta, Bapak Usman Wungguli dan Ibu Hadidjah Luther, Adik Rahmad Wungguli dan Rini Wahyuni Mohamad serta seluruh keluarga yang selalu memberikan dorongan dan mendoakan untuk keberhasilan studi bagi penulis.

6. Seluruh mahasiswa Departemen Matematika khususnya teman-teman angkatan tahun 2012 di program studi S2 Matematika Terapan.

7. Seluruh rekan–rekan mahasiswa Asrama Gorontalo di Bogor.

8. Sahabat-sahabat yang tak dapat disebutkan satu persatu yang telah banyak membantu penulis dalam penyelesaian tesis ini.

Semoga segala bantuan, bimbingan, dan motivasi yang telah diberikan kepada penulis senantiasa mendapat balasan dari Allah Subhanahu wa ta’ala.

Akhirnya, semoga penulisan tesis ini dapat memperkaya pengalaman belajar serta wawasan kita semua.

11

DAFTAR ISI

DAFTAR GAMBAR vi

DAFTAR LAMPIRAN vi

1 PENDAHULUAN 1

Latar Belakang 1

Tujuan Penelitian 2

2 TINJAUAN PUSTAKA 3

Ruang Vektor 3

Matriks 4

Ortogonalitas 5

Pengoptimuman Matematik 6

Turunan Parsial 6

Turunan Berarah 6

Vektor Gradien dan Matriks Hesse 7

Minimum Global dan Minimum Lokal 8

Fungsi Kuadratik di 8

Kedefinitan Matriks 8

Kekonveksan Fungsi 9

Tingkat Konvergensi 9

Deret Taylor 10

Ketaksamaan Kantorovich 10

Iterasi dan Running Time 10

3 METODE PENELITIAN 11

4 HASIL DAN PEMBAHASAN 11

Metode Steepest Descent 11

Exact Line Search 14

Kekonvergenan Metode Steepest Descent 17

Metode Barzilai dan Borwein 19

Metode Alternatif Minimisasi 20

Metode Yuan 22

Modifikasi Metode Steepest Descent dengan Ukuran Langkah Baru 25

Hasil Numerik 26

5 SIMPULAN 31

DAFTAR PUSTAKA 31

LAMPIRAN 32

DAFTAR TABEL

1 Rata-rata jumlah iterasi dari metode steepest descent 27 2 Rata-rata running time dari metode steepest descent 28

DAFTAR GAMBAR

1 Pencarian arah d gradien terhadap vektor gradien 12

2 Ilustrasi steepest descent dalam plot kontur 13

3 Ilustrasi perbandingan metode Alternatif Minimisasi dan metode

steepest descent 21

4 Perbandingan rata-rata iterasi dan running time dari metode steepest

descent untuk λn = 10 29

5 Perbandingan rata-rata iterasi dan running time dari metode steepest

descent untuk λn= 100 29

6 Perbandingan rata-rata iterasi dan running time dari metode steepest

descent untuk λn = 1000 29

7 Kekonvergenan dari metode steepest descent 30

DAFTAR LAMPIRAN

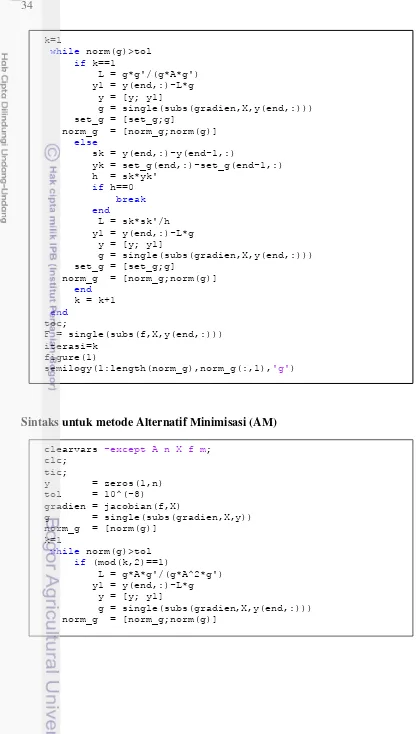

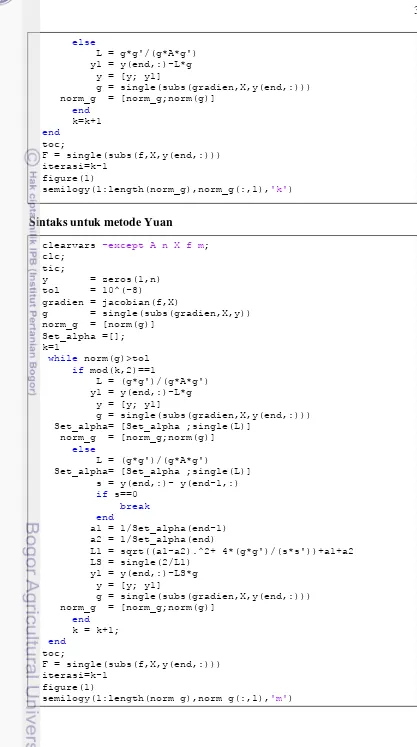

1 Sintaks dari setiap metode steepest descent 32

1 PENDAHULUAN

Latar Belakang

Dalam aktivitas sehari-hari sering dijumpai kegiatan yang menyangkut pengoptimuman. Kegiatan pengoptimuman ini bertujuan untuk memaksimumkan atau meminimumkan. Hal ini biasanya dijumpai dalam bidang industri, teknik, ekonomi, pertanian dan banyak sektor bidang lainnya. Pengoptimuman dapat didefinisikan sebagai proses untuk mendapatkan keputusan terbaik yang memberikan nilai maksimum atau minimum dari suatu fungsi dengan cara penentuan solusi yang tepat. Dari segi fungsinya pengoptimuman dapat dibedakan menjadi pengoptimuman linear dan pengoptimuman nonlinear. Sedangkan dari bentuknya pengoptimuman dikelompokkan menjadi pengoptimuman berkendala dan pengoptimuman nirkendala. Pengoptimuman berkendala adalah pengoptimuman suatu fungsi dengan syarat-syarat tertentu yang membatasinya. Sebaliknya pengoptimuman nirkendala adalah pengoptimuman tanpa adanya syarat-syarat tertentu yang membatasinya (Griva et al. 2009).

Kegiatan Pengoptimuman selalu identik dengan nilai maksimum atau nilai minimum yang terbaik. Padahal, pengoptimuman yang baik seharusnya mempertimbangkan juga metode yang akan digunakan serta pemrograman yang tepat dalam aspek komputasi. Komputasi dapat diartikan sebagai cara untuk menemukan pemecahan masalah dari data input dengan menggunakan suatu algoritme dalam menyelesaikan suatu masalah. Dalam aspek komputasi hal yang diperhatikan adalah kompleksitas ruang dan kompleksitas waktu. Hal ini dapat dilihat dari tingkat kerumitan serta waktu yang dibutuhkan dari suatu algoritme dalam menyelesaikan suatu fungsi. Suatu algoritme dikatakan baik jika tingkat kerumitannya semakin kecil dan prosesnya membutuhkan waktu yang kecil. Namun pada kenyataannya banyak metode pengoptimuman yang bentuknya sederhana akan tetapi membutuhkan waktu yang lama dalam proses komputasinya. Oleh karenanya sangat diperlukan suatu perbaikan dari motode pengoptimuman baik dari segi kompleksitas ruang maupun dari segi kompleksitas waktunya.

Metode pengoptimuman umumnya dapat dilakukan secara analitik maupun secara numerik. Namun untuk kasus pengoptimuman nirkendala dengan fungsi nonlinear multivariabel, terdapat persoalan yang tidak bisa diselesaikan dengan metode analitik. Sehingga diperlukan metode numerik untuk menyelesaikan permasalahan tersebut. Metode numerik yang digunakan dalam masalah pengoptimuman biasanya bersifat iteratif. Salah satu metode iteratif yang digunakan adalah metode line search steepest descent.

intuitif arah yang digunakan dalam metode SD adalah arah dengan penurunan yang tercepat, akan tetapi secara umum tidak berarti menuju titik minimum lokal yang tercepat. Sehingga dalam beberapa tahun terakhir ini menjadi lebih jelas bahwa pimilihan ukuran langkah menjadi masalah penting dalam metode steepest descent. Penentuan ukuran langkah ini dapat mempengaruhi cepat atau lambatnya kekonvergenan ke solusi optimum. Sebuah hasil yang mengejutkan diberikan oleh Barzilai dan Borwein (1988) yang berusaha menyempurnakan metode ini dengan memodifikasi algoritme dan hasilnya berjalan cukup baik untuk masalah dengan dimensi yang besar. Metode ini kemudian dikenal dengan metode Barzilai-Borwein (BB)

Hasil metode BB (1988) telah memicu banyak penelitian pada metode steepest descent. Penelitian-penelitian yang dilakukan untuk mendapatkan algoritme pencarian ukuran langkah yang memungkinkan konvergensi cepat dan monoton. Diantaranya penelitian yang dilakukan oleh Dai dan Yuan (2003) yang dinamakan Alternatif Minimisasi (AM) dengan ide penggabungan ukuran langkah yang bergantian antara meminimumkan nilai fungsi dan norm gradien disepanjang garis steepest descent. Penelitian lainnya dilakukan oleh Yuan (2006), dengan algoritme ukuran langkah baru pada iterasi genap dan exact line search pada iterasi ganjil. Metode Yuan ini sangat efisien untuk masalah dengan dimensi kecil. Berdasarkan penelitian-penelitian yang telah dilakukan, maka dalam penelitian ini akan dimodifikasi ukuran langkah pada metode SD dengan ukuran langkah baru untuk memperoleh kekonvergenan yang lebih cepat dari metode-metode yang telah dilakukan sebelumnya. Modifikasi ukuran langkah yang dilakukan diharapkan dapat memperkecil kompleksitas ruang maupun kompleksitas waktu yang dibutuhkan dari algoritme.

Tujuan Penelitian

a. Merekonstruksi algoritme steepest descent, Barzilai-Borwein, Alternatif Minimisasi, dan metode Yuan.

b. Memodifikasi algoritme steepest descent dengan ukuran langkah baru.

3

2 TINJAUAN PUSTAKA

Ruang Vektor

Definisi 2.1 (Ruang Vektor)

Misalkan V adalah himpunan dengan pendefinisian operasi penjumlahan dan operasi perkalian dengan skalar. Setiap pasangan elemen dan di dalam V terdapat suatu elemen yang tunggal juga berada di dalam V serta setiap elemen di dalam V dan setiap skalar terdapat yang tunggal juga berada di dalam V. Himpunan V dengan operasi penjumlahan dan operasi perkalian dengan skalar ini dinamakan ruang vektor jika memenuhi aksioma berikut.

1. .

Elemen dalam V adalah vektor sedangkan symbol 0 menyatakan vektor nol. (Leon 1998) vektor pada V selalu dapat dinyatakan sebagai kombinasi linear dari vektor

Definisi 2.6 (Bergantung Linear)

Vektor-vektor dalam ruang vektor V disebut bergantung linear jika terdapat skalar-skalar yang tidak semuanya nol sehingga .

(Leon 1998) Definisi 2.7 (Basis)

Vektor-vektor membentuk basis untuk ruang vektor V jika dan hanya jika bebas linear dan merentang V .

(Leon 1998) Definisi 2.8 (Dimensi)

Misalkan V adalah ruang vektor. Jika V memiliki basis yang terdiri atas n vektor, maka V dikatakan memiliki dimensi n .

(Leon 1998)

Matriks

Definisi 2.9 (Matriks Identitas)

Matriks identitas adalah matriks yang berukuran , dengan {

(Leon 1998) Definisi 2.10 (Invers dari Suatu Matriks)

Suatu matriks yang berukuran dikatakan taksingular jika terdapat matriks B sehingga . Matriks B dikatakan invers multiplikatif dari matriks . Invers multiplikatif dari matriks taksingular secara sederhana disebut juga sebagai invers dari matriks dan dinotasikan dengan .

(Leon 1998) Definisi 2.11 (Traspose dari Suatu Matriks)

Transpos dari suatu matriks ( ) yang berukuran adalah matriks ( ) yang berukuran yang didefinisikan oleh untuk setiap dan . Transpos dari dinotasikan oleh .

(Leon 1998) Definisi 2.12 (Matriks Simetris)

Suatu matriks berukuran disebut matriks simetris jika (Leon 1998) Definisi 2.13 (Matriks Diagonal)

Matriks diagonal adalah matriks berukuran yang semua unsur selain diagonal utama ialah nol. Matriks diagonal berukuran dapat ditulis sebagai

[ ]

Pengoptimuman Matematik

Definisi 2.17

Pengoptimuman matematik adalah suatu proses formulasi masalah dan penentuan solusi dari suatu masalah pengoptimuman berkendala dengan bentuk umum:

dengan kendala (2.16)

dimana adalah fungsi dari x.

Komponen-komponen dari dinamakan variabel keputusan, adalah fungsi objektif, menyatakan fungsi kendala pertaksamaan, adalah fungsi-fungsi kendala persamaan. Vektor optimum yang menjadi solusi dari masalah dinyatakan dengan dan nilai optimumnya adalah . Jika tidak ada kendala maka masalah dinamakan masalah pengoptimuman nirkendala.

(Snyman 2005) Turunan Parsial

Definisi 2.18

Andaikan bahwa f adalah suatu fungsi dua variabel x dan y. Jika y di jaga agar tetap konstan, katakanlah , maka adalah fungsi satu variabel x. Turunannya di x = x0 disebut turunan parsial f terhadap x di dan dinyatakan oleh . Jadi

Dengan cara serupa, turunan parsial f terhadap y di dinyatakan oleh

dan diberikan oleh

Misalkan f suatu fungsi tiga variabel x, y, dan z. Turunan parsial f terhadap x di (x,y,z) dinyatakan oleh dan didefenisikan oleh

Turunan parsial terhadap y dan z didefenisikan secara serupa.

(Varberg et al. 2007)

Turunan Berarah

Definisi 2.19

Untuk tiap vektor u, misalkan

7 Untuk menghitung turunan berarah dari suatu fungsi, biasanya digunakan teorema berikut:

Teorema 2.1

Misalkan f terdiferensialkan di p, maka f mempunyai turunan berarah di p dalam arah vektor satuan u = (a, b) dan vektor dari turunan parsial orde pertama disebut vektor gradien yaitu:

terdapat matriks turunan parsial kedua yang disebut matriks Hesse:

Minimum Global dan Minimum Lokal

Definisi 2.22

Titik adalah minimum global dari f pada D jika

Titik adalah minimum lokal jika terdapat sehingga

|‖ ‖

dengan ‖ ‖ menyatakan norm Euclid.

Syarat perlu dan syarat cukup untuk minimum lokal dinyatakan dalam teorema berikut:

Teorema 2.2 (Syarat perlu)

Misalkan adalah fungsi yang mempunyai turunan parsial kedua di . Jika adalah minimum lokal, maka , (syarat orde pertama) dan matriks Hesse semidefinit positif (syarat orde kedua).

Titik sehingga dinamakan titik kritis atau titik stasioner fungsi f.

Teorema 2.3 (Syarat cukup)

Misalkan adalah fungsi yang mempunyai turunan parsial kedua di . Jika dan matriks Hesse definit positif, maka adalah minimum lokal dari .

(Snyman 2005)

Fungsi Kuadratik di

Definisi 2.23

Suatu fungsi dinamakan fungsi kuadratik dalam n variabel jika dapat dituliskan sebagai

Dengan , b vektor real berukuran n, dan A matriks real berukuran . Jika maka

(2.26)

Sehingga matriks adalah matriks simetrik.

(Snyman 2005)

Kedefinitan Matriks

Teorema 2.4

Misalkan matriks berukuran dan misalkan adalah minor utama ke-k dari matriks untuk maka

1. definit positif jika dan hanya jika , untuk k = 1,2,…,n,

9 Teorema 2.5

Jika suatu matriks simetrik, maka matriks adalah

1. definit positif jika dan hanya jika semua nilai eigen dari adalah positif, 2. definit negatif jika dan hanya jika semua nilai eigen dari adalah negatif, 3. takdefinit jika dan hanya jika mempunyai paling sedikit satu nilai eigen

positif dan paling sedikit satu nilai eigen negatif.

(Peressini et al. 1988)

Kekonveksan Fungsi

Definisi 2.24 (Ruas Garis)

Misalkan dan dua titik di , maka ruas garis yang menghubungkan dan adalah

| (2.27)

Definisi 2.25 (Himpunan Konveks)

Himpunan dikatakan himpunan konveks jika dan hanya jika untuk setiap dan di C, maka ruas garis yang menghubungkan dan juga terletak di C.

Definisi 2.26 (Fungsi Konveks)

Misalkan ,

1. fungsi f dikatakan konveks pada himpunan konveks C jika

untuk setiap , di C dan untuk setiap dengan

2. fungsi f dikatakan konveks sempurna pada himpunan konveks C jika

untuk setiap , di C dengan dan untuk setiap dengan

Misalkan mempunyai turunan parsial kedua yang kontinu pada suatu himpunan C di . Jika matriks Hesse dari f adalah definit positif pada C, maka adalah fungsi konveks sempurna pada C.

(Snyman 2005)

Tingkat Konvergensi

Defenisi 2.27

Misalkan diberikan barisan iterasi yang dihasilkan oleh suatu algoritme konvergen ke pada sejumlah norm yaitu,

‖ ‖ Jika terdapat bilangan real dan bilangan konstan positif yang bebas terhadap iterasi k, sehingga

‖ ‖

maka dapat dikatakan memiliki -order tingkat konvergensi yang dapat dibagi menjadi tiga bagian:

1. jika dan maka barisan konvergen Q-Linear 2. jika dan atau, dan maka barisan

konvergen Q-Superlinear

3. jika maka barisan konvergen Q-Kuadrat

(Sun dan Yuan 2006)

Deret Taylor

Definisi 2.28

Deret Taylor dari fungsi real yang terturunkan untuk semua tingkatan disekitar titik dapat ditulis sebagai berikut:

dimana adalah gradien pada dan adalah matriks Hessian. (Varberg et al. 2007)

Ketaksamaan Kantorovich

Teorema 2.6

Diberikan matriks simetrik definit positif dengan nilai eigen

. Maka untuk setiap berlaku Ketaksamaan:

( )( )

(Sun dan Yuan 2006)

Iterasi dan Running Time

Definisi 2.29 (Iterasi)

Iterasi adalah sifat tertentu dari algoritme atau program komputer dimana suatu urutan atau lebih dari langkah algoritmik yang dilakukan pada loop program. Iterasi merupakan proses yang dilakukan secara berulang dalam menyelesaikan permasalahan matematik.

(Chapman 2008) Definisi 2.30 (Running Time)

Running time dari suatu algoritme didefenisikan sebagai ukuran operasi primitif atau tahapan proses yang dieksekusi.

3 METODE PENELITIAN

Penelitian ini disusun melalui tiga tahap, pertama dilakukan telaah pustaka (buku dan jurnal terkait) mengenai metode steepest descent. Pada tahap pertama ini akan merekonstruksi empat metode gradien steepest descent yaitu metode steepest descent klasik, metode Barzilai-Borwein, metode Alternatif Minimisasi dan metode Yuan. Selanjutnya pada tahap kedua, memodifikasi ukuran langkah pada metode steepest descent dengan ukuran langkah yang baru. Kemudian pada tahap ketiga, mengimplementasikan metode kedalam bahasa pemrograman dengan menggunakan perangkat lunak. Setelah itu, dilakukan pengujian untuk kasus fungsi kuadratik yang dibangkitkan secara acak. Rata-rata dari hasil pengujian akan dibandingkan untuk melihat metode yang terbaik dalam menemukan solusi nilai minimum dengan iterasi dan running time yang terkecil.

4 HASIL DAN PEMBAHASAN

Metode Steepest Descent

Seperti yang telah dijelaskan dalam pendahuluan bahwa metode steepest descent adalah metode gradien sederhana untuk pengoptimuman nirkendala. Metode ini digunakan untuk meminimumkan fungsi terdiferensialkan beberapa variabel yang menggunakan vektor gradien (turunan parsial orde pertama dari fungsi f ) untuk menentukan arah pencarian disetiap iterasi. Metode ini diperkenalkan pertama kali oleh Cauchy pada tahun 1847 dengan bentuk permasalah pengoptimuman:

dimana adalah fungsi terdiferensialkan secara kontinu di . Secara umum dapat berupa fungsi nonlinear.

Metode steepest descent merupakan metode iteratif untuk memperoleh solusi pendekatan dari problem awal. Dalam pembahasan metode iteratif ini, vektor yang diperoleh pada iterasi ke-k dinyatakan dengan . Misalkan diberikan suatu titik awal kemudian akan dicari , sehingga . Pergerakan pada setiap iterasi haruslah memenuhi

(4.2)

Misalkan f adalah fungsi yang terdefinisi di yang mempunyai turunan parsial pertama yang kontinu. Arah descent ditentukan dengan menggunakan turunan berarah di . Misalkan dan . Dengan menggunakan aturan rantai diperoleh

(4.3)

sehingga

menyatakan laju perubahan di pada arah , yang disebut juga dengan turunan berarah dari di pada arah (Gambar 1).

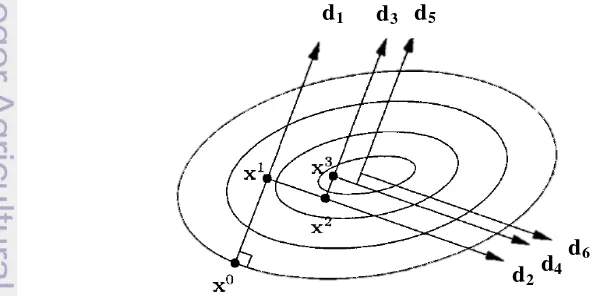

Gambar 1 Pencarian arah d gradien terhadap vektor gradien Perhatikan bahwa

‖ ‖‖ ‖ ‖ ‖ (4.5)

dimana adalah sudut antara dengan . Karena maka

‖ ‖ ‖ ‖ ‖ ‖ (4.6)

Di titik dicari vektor satuan sehingga turunan berarah mempunyai nilai terkecil relatif terhadap semua kemungkinan vektor satuan di . Nilai terkecil dari turunan berarah tersebut adalah ‖ ‖ pada saat , yaitu pada saat sudut antara dengan adalah , yang berarti sudut antara

dengan adalah 0. Jadi vektor arah berimpit dengan vektor

. Ini berarti arah sehingga turunan berarah fungsi di sekecil mungkin adalah .

Secara umum metode steepest descent memiliki bentuk sebagai berikut: (4.7) atau

(4.8) dimana dan adalah vektor gradien dari di dan

> 0 adalah ukuran langkah. Ukuran langkah dapat diperoleh dengan pencarian exact line search yaitu:

(4.9) Jika ingin menemukan nilai minimum dari maka dapat dilakukan dengan mencari sehingga diperoleh

(4.10)

ini berarti gradien dari titik saat ini dan gradien dari titik selanjutnya saling tegak lurus (ortogonal). Untuk batas keturunan nilai fungsi untuk setiap iterasi dalam exact line search diberikan oleh,

‖ ‖‖ ‖ dimana menunjukkan sudut antara dan . Lebih jelasnya teori kekonvergenan exact line search dijelaskan pada subbab selanjutnya.

13 Metode steepest descent selalu konvergen. Artinya, secara teori metode ini tidak akan berhenti atau akan terus melakukan iterasi sampai titik stasionernya ditemukan. Adapun algoritme stespest descent dituliskan dalam tahap-tahap sebagai berikut:

Algoritme 4.1 Steepest Descent

Step 0. Diberikan titik awal dan batas toleransi . Tetapkan .

Step 1. Tentukan . Jika ‖ ‖ , berhenti. Jika tidak tentukan

.

Step 2. Tentukan yang meminimumkan

Step 3. Hitung

Step 4. Beri nilai , dan pergi ke Step 1.

Pada algoritme metode steepest descent ini memerlukan sembarang nilai awal atau titik awal . Pemberian nilai awal ini merupakan kriteria dari suatu metode iteratif. Selanjutntya dalam metode ini membutuhkan batas toleransi ( ) yang digunakan untuk pemberhentian dari proses iteratif. Batas toleransi ini digunakan untuk membatasi nilai ‖ ‖. Pembatasan ini dilakukan untuk menentukan tingkat ketelitian dari solusi. Semakin kecil batas toleransi yang diberikan maka solusi dari permasalahan akan semakin mendekati ke nilai yang sebenarnya. Pada dasarnya dalam metode steepest descent terdapat beberapa kriteria untuk pembatasan proses iterasi atau disebut uji konvergensi diantaranya yaitu norm dari selisih dua nilai terakhir yang disimbolkan dengan ‖

‖. Selain itu dapat juga menggunakan selisih dari dua nilai fungsi terakhir yaitu | |. Untuk kriteria pembatasan proses iterasi ini dapat digunakan secara bersamaan sehingga proses iterasi akan berhenti ketika salah satu kreteria terpenuhi.

Selanjutnya langkah terpenting dalam metode steepest descent yaitu menentukan vektor gradien dan menentukan ukuran langkah . Vektor gradien digunakan untuk menentukan arah dimana suatu kurva pada titik mengalami penurunan yang tercuram sedangkan ukuran langkah digunakan untuk menentukan seberapa besar ukuran atau langkah pada arah penurunan tercuram tersebut. Sehingga akan didapatkan titik yang baru. Proses ini akan terus berlangsung sampai kriteria pemberhentian terpenuhi.

Gambar 2 Ilustrasi steepest descent dalam plot kontur (Snyman 2005). d1 d3 d5

d2d4

Meskipun titik optimum lokal ditemukan dengan arah yang tercuram metode steepest descent sering berkinerja buruk mengikuti jalan zig-zag. Hal ini menyebabkan konvergensi lambat dan menjadi ekstrim ketika masalah dengan skala yang besar yaitu ketika bentuk kontur yang sangat panjang. Kinerja yang buruk ini disebabkan oleh fakta bahwa metode steepest descent memberlakukan secara berturut arah pencarian yang ortogonal (4.10) seperti yang ditunjukkan pada Gambar 2. Meskipun dari sudut pandang teoritis metode ini dapat terbukti menjadi konvergen, tetapi dalam prakteknya metode ini tidak dapat secara efektif konvergen dalam jumlah langkah terbatas. Hal ini tergantung pada titik awal yang diberikan, bahkan konvergensi buruk ini juga terjadi ketika menerapkan metode steepest descent walaupun untuk fungsi kuadratik yang definit positif.

Exact Line Search

Line search adalah pencarian satu dimensi yang mengacu pada prosedur pengoptimuman untuk fungsi dengan variabel tunggal. Line search ini merupakan dasar dari pengoptimuman multivariabel (4.8) untuk mencari Nilai dapat dicari dengan meminimumkan fungsi tujuan pada arah dan dapat dituliskan sebagai berikut:

atau (4.12)

Line search biasanya dinamakan exact line search karena berdasarkan (4.12) dapat ditemukan titik minimum yang tepat dan titik stasioner dari fungsi. Untuk lebih jelasnya akan dibuktikan kekonvergenan dari exact line search.

Teorema 4.1 (Teori Kekonvergenan untuk Exact Line Search)

Misal diberikan yang merupakan solusi dari (4.12). Dimisalkan pula

‖ ‖ , dimana M adalah bilangan positif, maka

‖ ‖

Bukti.

Dari ekspansi deret Taylor diperoleh:

‖ ‖

dari asumsi ‖ ‖ , sehingga

‖ ‖

dimisalkan ̅ ⁄ ‖ ‖ sehingga dari (4.15) dan (4.11)diperoleh

̅

̅ ̅ ‖ ‖

( )

15

‖ ‖ ( )

‖ ‖ ‖ ‖

‖ ‖

Teorema 4.2 (Teori Kekonvergenan untuk Exact Line Search)

Misalkan adalah fungsi kontinu terdiferensialkan pada himpunan terbuka , diasumsikan barisan dari (4.12) memenuhi dan . Misalkan ̅ merupakan titik akumulasi dari dan merupakan indeks dengan | ̅ . Diasumsikan juga terdapat sehingga ‖ ‖ . Jika ̅ adalah titik akumulasi dari maka

̅ ̅ (4.16)

Selanjutnya, jika terdiferensialkan dua kali pada maka

̅ ̅ ̅ (4.17)

Bukti

Misalkan merupakan indeks dengan ̅ . Jika ̅ maka (4.16) memiliki solusi trivial. Jika tidak maka dipertimbangkan dua kasus berikut.

(i)Terdapat indeks sehingga ̅ . Karena merupakan ukuran langkah yang tepat, maka . Karena ‖ ‖ merupakan terbatas seragam dan , maka diambil hasil limit

̅ ̅

(ii) Untuk ̅ . Misalkan adalah indeks dari dengan ̅ ⁄ . Andaikan bahwa (4.16) tidak benar maka

̅ ̅

Jadi terdapat lingkungan ̅ dari ̅ dan indeks sehingga ̅ dan ,

⁄

Misal ̂ adalah bilangan positif terkecil, sehingga untuk ̂ dan , ̅ . Pilih ̅ ⁄ ̂ , maka dari exact line search dan ekspansi Taylor diperoleh

̅ ∑

∑

∑

∑

∑ ( )

dimana . Kontradiksi di atas menunjukkan bahwa (4.16) juga berlaku untuk kasus (ii).

Untuk pembuktian (4.17) sama halnya dengan pembuktian (4.16) yaitu secara kontradiksi hanya berbeda pada ekspansi deret Taylor orde kedua dan memisalkan ̅ ̅ ̅ ⁄ .

̅ ∑

∑

∑

∑

∑ [ ( )]

Hal ini kontradiksi dengan (4.17).

Dalam kasus pengoptimuman dengan fungsi kuadratik (2.25) pencarian

dengan exact line search dapat diubah dalam bentuk sederhana. Misalnya secara umum akan diminimumkan dengan arah descent . Karena masalah pengoptimuman berbentuk fungsi kuadratik (2.25) sehingga fungsi menjadi

Jika diminimumkan maka turunan (4.18) ke nol yaitu

, (4.19)

dari (4.19) diperoleh

berdasarkan(2.26) dan gradien maka didapatkan

17 Kekonvergenan Metode Steepest Descent

Teorema 4.3 (Konvergensi Global Metode Steepest Descent)

Misalkan . Untuk setiap titik akumulasi dari barisan iterasi yang dihasilkan dari Algoritme 4.1 dengan exact line search adalah titik stasioner. Bukti

Misalkan ̅ merupakan titik akumulasi dari dan adalah indeks terbatas sedemikian hingga ̅. Tetapkan . Karena

maka barisan | terbatas seragam dan ‖ ‖ ‖ ‖. Karena

asumsi Teorema 4.2 terpenuhi, maka ‖ ̅ ‖ ini berarti bahwa ̅ . Teorema 4.4 (Konvergensi Global Metode Steepest Descent)

Misalkan terdiferensialkan dua kali pada dan ‖ ‖ untuk konstanta positif. Diberikan nilai awal dan . Maka untuk barisan yang dihasilkan dari Algoritme 4.1 terbatas dibanyak iterasi, atau atau

Bukti

Diketahui bentuk metode steepest descent (4.7) yaitu

Karena masalah pengoptimuman (4.21) berbentuk kuadratik maka dapat dituliskan dalam bentuk

Dengan menggunakan ketaksamaan Kantorovich (2.33) maka diperoleh

sehingga dari (4.25), (4.27) dan (4.28) diperoleh ‖ ‖

Teorema diatas berlaku juga untuk fungsi kuadratik dengan bentuk

19 Metode Barzilai dan Borwein

Metode Barzilai dan Borwein atau disebut metode BB merupakan metode pengembangan dari metode steepest descent dengan mengganti ukuran langkah . Ide utama dari pendekatan metode BB adalah menggunakan informasi dalam iterasi sebelumnya untuk menentukan ukuran langkah dalam iterasi selanjutnya. Ukuran langkah metode BB diturunkan dari dua titik pendekatan ke garis potong persamaan yang didasari oleh metode Newton. Adapun metode Quasi-Newton yaitu sebagai berikut:

(4.30)

dimana dan adalah matriks identitas.

Misalnya diberikan ekspansi deret Taylor (2.32) dari fungsi real untuk pendekatan kuadratik yang terturunkan untuk semua tingkatan di sekitar titik yaitu

Pertama akan dibahas masalah (4.32). Jika masalah (4.32) diselesaikan dengan menggunakan least-squares (kuadrat terkecil) maka akan diperoleh:

‖ ‖

kemudian disederhanakan menjadi

Dari syarat perlu minimum lokal (Teorema 2.2) didapatkan

dengan cara penyelesaian yang sama pada masalah (4.32) maka diperoleh ukuran langkah yang kedua

Dari penyelesaian (4.32) dan (4.33) telah didapatkan dua ukuran langkah yang baru yaitu (4.34) dan (4.35). Kedua ukuran langkah ini merupakan ukuran langkah dari metode Barzilai dan Borwein yang memiliki langkah Q-super linear konvergensi pada tiga langkah berturut-turut (Dai 2003). Lebih jelasnya algoritme dari metode Barzilai dan Borwein dituliskan sebagai berikut:

Algoritme 4.2 Barzilai dan Borwein (BB)

Step 0. Diberikan titik awal dan batas toleransi . Tetapkan .

Step 1. Tentukan . Jika ‖ ‖ , berhenti. Jika tidak tentukan

.

Step 2. Jika k = 0 maka tentukan dengan exact line search. Jika tidak Tentukan dengan

dimana dan Step 3. Hitung

Step 4. Beri nilai , dan pergi ke Step 1.

Metode Alternatif Minimisasi

Dalam beberapa pengertian, prinsipnya bahwa meminimumkan suatu fungsi yang kontinu dan terdiferensialkan dua kali (fungsi smooth) adalah setara dengan meminimumkan norm gradien ‖ ‖. Hal ini merupakan ide dasar dari metode gradien Alternatif Minimisasi (Dai dan Yuan 2003). Metode Alternatif Minimisasi (AM) adalah modifikasi metode steepest descent dengan ukuran langkah yang bergantian antara meminimumkan nilai fungsi dan norm gradien disepanjang garis steepest descent. Lebih tepatnya untuk dipilih ukuran langkah sehingga

‖ ‖ dan

Dapat dilihat bahwa gradien dari ‖ ‖ dan masing-masing adalah

‖ ‖⁄ dan , sehingga dari (4.36) dan (4.37) diperoleh

(4.38)

dan

(4.39)

Dari hubungan di atas dapat simpulkan bahwa saling konjugat dengan , sedangkan dan saling ortogonal. Berdasarkan (4.7) dan didapatkan

21

{

Dari ketaksamaan Cauchy dan asumsi bahwa matriks simetrik definit positif, diperoleh

Hal ini menunjukkan bahwa ukuran langkah metode AM pada setiap iterasi ganjil lebih kecil atau sama dengan ukuran langkah dari metode SD, yaitu

(4.41) Untuk ukuran langkah pada iterasi genap jelas terlihat bahwa

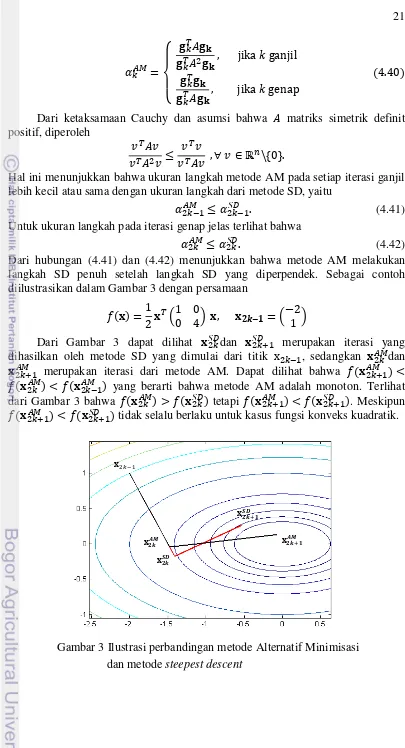

(4.42) Dari hubungan (4.41) dan (4.42) menunjukkan bahwa metode AM melakukan langkah SD penuh setelah langkah SD yang diperpendek. Sebagai contoh diilustrasikan dalam Gambar 3 dengan persamaan

Dari Gambar 3 dapat dilihat dan merupakan iterasi yang dihasilkan oleh metode SD yang dimulai dari titik , sedangkan dan

merupakan iterasi dari metode AM. Dapat dilihat bahwa yang berarti bahwa metode AM adalah monoton. Terlihat dari Gambar 3 bahwa tetapi . Meskipun tidak selalu berlaku untuk kasus fungsi konveks kuadratik.

��

��

��

��

Algoritme 4.3 Alternatif Minimisasi (AM)

Step 0. Diberikan titik awal dan batas toleransi . Tetapkan .

Step 1. Tentukan dan . Jika ‖ ‖ , berhenti. Step 2. Jika k ganjil maka tentukan

jika tidak tentukan

Step 3. Hitung

Step 4. Beri nilai , dan pergi ke Step 1.

Metode Yuan

Metode Yuan (Yuan 2006) menggunakan ukuran langkah yang bergantian seperti yang dilakukan pada metode AM. Akan tetapi metode Yuan menggunakan ukuran langkah yang baru. Untuk analisis pada metode Yuan, diasumsikan bahwa fungsi objektif adalah sebagai berikut:

dimana dan simetris dan definit positif. Metode baru yang digunakan akan memberikan nilai minimum dari dengan melakukan iterasi. Dapat dilihat bahwa pencarian exact line harus dilakukan pada iterasi terakhir sebelum algoritme berhasil menemukan solusinya. Diasumsikan bahwa digunakan pencarian exact line pada iterasi pertama untuk mendapatkan keberuntungan apabila ada kasus dimana algoritme dapat menemukan solusi pada iterasi pertama. Oleh karena itu, dibuatlah algoritme sebagai berikut:

dimana dan didapat dari pencarian exact line dan adalah solusi. Perlu dicari formula untuk sehingga akan menjadi nilai minimum dari fungsi objektif.

Metode steepest descent adalah invarian dengan transformasi ortogonal. Untuk mempermudah analisis, dipelajari kasus dimana dan adalah dua buah sumbu. Sesuai dengan pencarian exact line pada iterasi pertama, gradien dan adalah ortogonal. Oleh karena itu untuk semua vektor dapat dituliskan sebagai kombinasi linear dari dan . Misalkan diberikan fungsi:

‖ ‖ ‖ ‖ (‖ ‖)

⁄‖ ‖ ⁄‖ ‖‖ ‖

23 Berdasarkan pencarian exact line (4.20) pada iterasi pertama dan kedua, diperoleh

‖ ‖ , ‖ ‖ dan ‖ ‖ sehingga

‖ ‖ ‖ ‖ (‖ ‖)

( ‖ ‖ ⁄⁄ ‖ ‖ ‖ ‖ ⁄⁄ ‖ ‖)

Dari persamaan di atas, dapat diketahui nilai minimum dari fungsi objektifnya dengan ⁄ dan ⁄ , sehingga diperoleh masing-masing:

‖ ‖ ‖ ‖ (4.43)

dan

‖ ‖ ‖ ‖ ‖ ‖‖ ‖ (4.44)

Jika dilakukan eliminasi terhadap (4.43) dan (4.44) diperoleh

‖ ‖‖ ⁄ ‖ ‖ ‖ ‖‖ ⁄

dan

‖ ‖ ‖ ⁄ ‖ ‖‖ ‖‖ ⁄

Disederhanakan menjadi

‖ ‖ ‖ ‖‖ ‖

‖ ‖ (‖ ‖ ‖ ‖)

Untuk mendapatkan

‖ ‖ ‖ ‖ , perlu diketahui bahwa arah gradien sejajar terhadap vektor residual . Untuk itu, diperlukan dua arah

( ‖ ‖)

dan

( ‖ ‖) ( ‖ ‖ ⁄⁄ ‖ ‖ ‖ ‖ ⁄⁄ ‖ ‖) ( ‖ ‖)

yang merupakan dua arah yang sejajar. Dua arah tersebut masing-masing sejajar terhadap

‖ ‖

‖ ‖ ‖ ‖ ‖ ‖ ‖ ‖

dan

‖ ‖ ‖ ‖

Diasumsikan bahwa

‖ ‖

‖ ‖ ‖ ‖ ‖ ‖ ‖ ‖ ‖ ‖ ‖ ‖

untuk . Berdasarkan baris pertama persamaan (4.45) didapatkan

‖ ‖ . Kemudian nilai λ tersebut disubtitusikan ke baris kedua pada persamaan (4.45) sehingga diperoleh

‖ ‖ ‖‖

Persamaan ini ekuivalen dengan

‖ ‖ ‖‖ ( )

Karena definit positif, diketahui bahwa

‖ ‖ ‖‖

Dari persamaan (4.46) diperoleh dua solusi positif untuk yaitu :

⁄ ⁄ √ ⁄ ⁄

Dari dua solusi tersebut dipilih nilai yang lebih kecil dan dapat dituliskan sebagai berikut:

√ ⁄ ⁄ ‖ ‖ ⁄‖ ‖ ⁄ ⁄

dengan . inilah yang disebut ukuran langkah baru dan kemudian akan diaplikasikan ke dalam metode hasil modifikasi steepest descent. Untuk fungsi konveks kuadratik di n ( > 2) dimensi, berdasarkan (4.47) dapat dituliskan

√ ⁄ ⁄ ‖ ‖ ⁄‖ ‖ ⁄ ⁄ Secara umum ukuran langkah dari metode Yuan adalah

Algoritme 4.4 Yuan

Step 0. Diberikan titik awal dan batas toleransi . Step 1. Tentukan dan . Jika ‖ ‖ , berhenti. Tetapkan . Step 2. Tentukan . Kemudian hitung

Step 3. Jika ‖ ‖ , berhenti

Step 4. Tentukan dan . Tentukan

√ ⁄ ⁄ ‖ ‖ ⁄‖ ‖ ⁄ ⁄ Hitung

Step 5. Jika ‖ ‖ , berhenti

25 Modifikasi Metode Steepest Descent dengan Ukuran Langkah Baru

Telah dibahas pada sub-bab sebelumnya bahwa metode gradien Yuan menggunakan ukuran langkah dengan exact line search pada iterasi ganjil dan kemudian menggunakan ukuran langkah (4.48) pada iterasi genap yang secara umum dituliskan seperti pada (4.49). Berdasarkan metode Yuan ini maka akan dilakukan modifikasi ukuran langkah dengan dua ukuran langkah yang baru. Untuk ukuran langkah yang pertama akan dibentuk suatu algoritme dengan ide langkah sebagai berikut:

(4.50)

dimana dan merupakan ukuran langkah dengan proses pencarian menggunakan exact line search, sedangkan untuk dan menggunakan ukuran langkah Yuan (4.48). Algoritme (4.50) ini merupakan bentuk awal dari proses iterasi, sehingga untuk proses iterasi (4.50) selanjutnya akan terus berlanjut sampai solusi nilai ditemukan. Secara umum ukuran langkah dari bentuk (4.50) dapat dituliskan sebagai berikut:

Algoritme 4.5 Ukuran Langkah Baru (a)

Step 0. Diberikan titik awal dan batas toleransi . Tetapkan .

Step 1. Tentukan dan . Jika ‖ ‖ , berhenti. Step 2. Jika mod(k,4) = 0 atau 1 maka tentukan

jika tidak tentukan dan

√ ⁄ ⁄ ‖ ‖ ⁄‖ ‖ ⁄ ⁄ Step 3. Hitung

Step 4. Beri nilai , dan pergi ke Step 1.

Untuk ukuran langkah baru yang kedua dapat dibuat algoritme dengan ide langkah sebagai berikut:

(4.52)

(4.52) pula akan terus berlanjut sampai solusi nilai ditemukan. Secara umum ukuran langkah dari bentuk (4.52) dapat dituliskan sebagai berikut:

Algoritme 4.6 Ukuran Langkah Baru (b)

Step 0. Diberikan titik awal dan batas toleransi . Tetapkan .

Step 1. Tentukan dan . Jika ‖ ‖ , berhenti. Step 2. Jika mod(k,4) = 1 atau 2 maka tentukan

Jika tidak tentukan dan

√ ⁄ ⁄ ‖ ‖ ⁄‖ ‖ ⁄ ⁄ Step 3. Hitung

Step 4. Beri nilai , dan pergi ke Step 1.

Hasil Numerik

Pada sub-bab ini dilakukan perbandingan hasil numerik dari setiap metode gradien yang telah dijelaskan pada sub-bab sebelumnya, yaitu SD, BB, AM, Yuan, Algoritme 4.5 dan Algoritme 4.6. Sintaks dari setiap metode dapat dilihat pada Lampiran 1. Ukuran langkah untuk metode SD menggunakan (4.20) yang merupakan penyederhanaan dari exact line search. Untuk metode BB dibagi menjadi dua bagian, yaitu BB1 menggunakan ukuran langkah (4.34) dan BB2 menggunakan ukuran langkah (4.35). Perbandingan dilakukan untuk kasus fungsi nonlinear dengan bentuk kuadratik. Fungsi kuadratik yang digunakan dalam penelitian ini dibangkitkan secara acak dalam bentuk

menyatakan dimensi dari fungsi kuadratik dengan

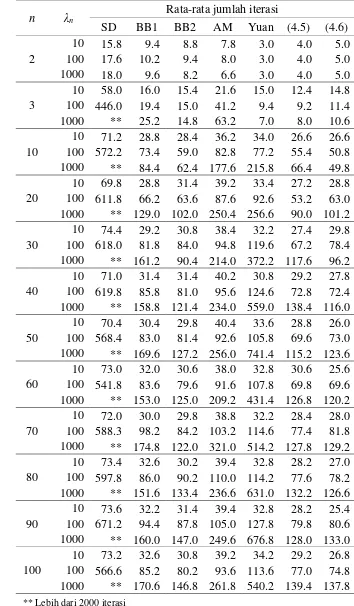

27 Tabel 1 Rata-rata jumlah iterasi dari metode steepest descent

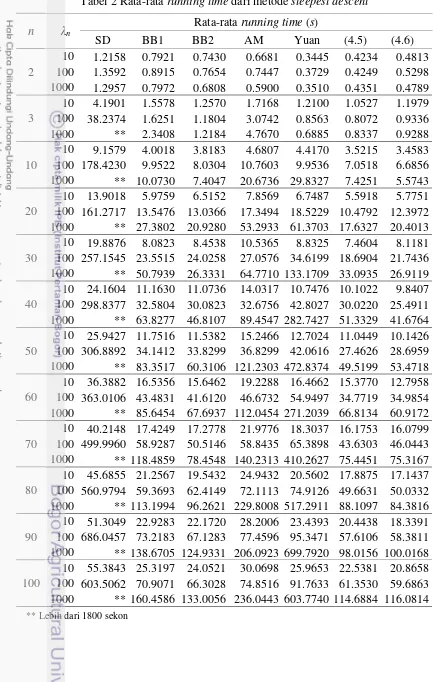

Tabel 2 Rata-rata running time dari metode steepest descent 1000 ** 160.4586 133.0056 236.0443 603.7740 114.6884 116.0814

29

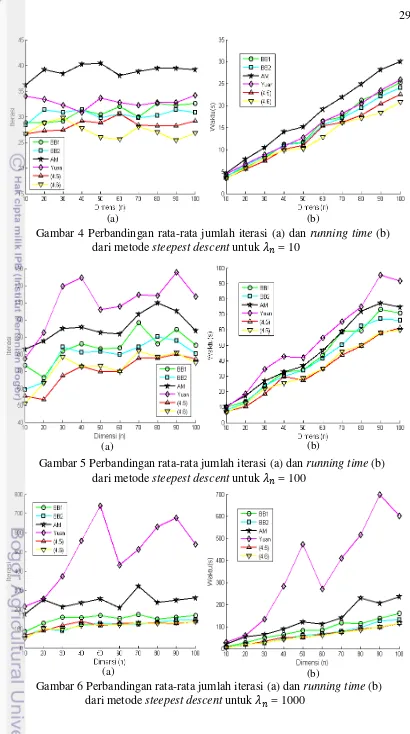

Gambar 4 Perbandingan rata-rata jumlah iterasi (a) dan running time (b) dari metode steepest descent untuk = 10

Gambar 5 Perbandingan rata-rata jumlah iterasi (a) dan running time (b) dari metode steepest descent untuk = 100

Gambar 6 Perbandingan rata-rata jumlah iterasi (a) dan running time (b) dari metode steepest descent untuk = 1000

(a) (b)

(a) (b)

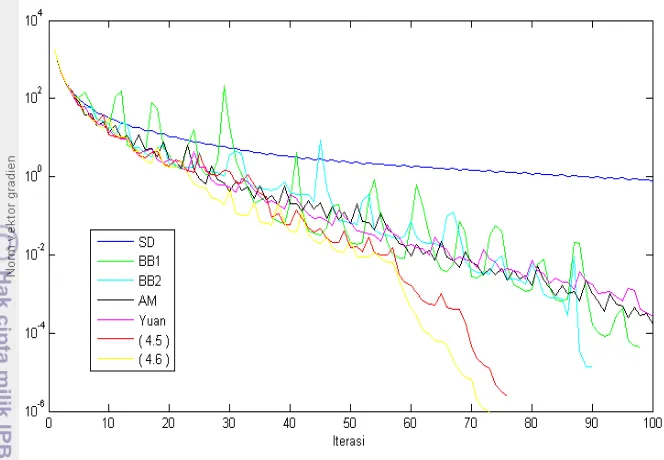

Gambar 7 Kekonvergenan dari metode steepest descent

Berdasarkan hasil percobaan yang dilakukan secara umum dapat dilihat hubungan antara dimensi dan dengan iterasi dan running time. Untuk kasus dimensi kecil (n = 2 & 3) dapat dilihat bahwa besarnya tidak berpengaruh terhadap iterasi dan running time. Artinya semakin besar tidak menjamin bahwa iterasi dan running time akan semakin besar pula (Tabel 1 dan 2). Untuk kasus dimensi besar (n = 10, 20, 100) terlihat bahwa semakin besar maka semakin besar pula iterasi dan running timenya (Gambar 4 – 6). Selanjutnya dapat dilihat bahwa semakin besar dimensi tidak menyebabkan semakin besar iterasinya (Gambar 4a – 6a). Berbeda halnya dengan running time, semakin besar dimensi maka semakin besar pula running timenya (Gambar 4b – 6b).

5 SIMPULAN

Metode Yuan merupakan metode gradien yang mampu memberikan iterasi dan running time yang kecil untuk kasus fungsi kuadratik dengan dimensi yang kecil. Akan tetapi metode Yuan memberikan kinerja yang buruk untuk kasus dengan dimensi dan yang lebih besar. Dalam penelitian ini dilakukan modifikasi ukuran langkah metode steepest descent dengan modifikasi ukuran langkah pada metode Yuan. Berbeda dengan metode Yuan, modifikasi ukuran langkah baru ini memberikan kinerja yang lebih baik untuk kasus fungsi kuadratik dengan dimensi dan yang besar. Bahkan modifikasi ukuran langkah baru ini lebih dominan mampu mengungguli kinerja dari metode Barzilai dan Borwein dan metode Alternatif Minimisasi. Hal ini terlihat dari rata-rata iterasi dan running time hasil percobaan yang dilakukan dengan fungsi kuadratik yang dibangkitkan secara acak. Modifikasi ukuran langkah baru ini mempunyai tingkat konvergensi yang cepat dibandingkan metode gradien yang lainnya.

DAFTAR PUSTAKA

Anton H, Rorres C. 2005. Elementary Linear Algebra 9th ed. New Jersey (USA): John Wiley and Sons.

Barzilai J, Borwein JM. 1988. Two point step size gradient methods. IMA Journal of Numerical Analysis, 8: 141-148.

Bazara MS, Sherali HD, Shetty CM. 2006. Nonlinear Programming. Theory and Algorithms. New Jersey (USA): Wiley-Interescience.

Cauchy A. 1847. General method for solving simultaneous equations Systems, Comp. Rend. Sci. Paris, 25: 46-89

Chapman SJ. 2008. Matlab Programming for Engineers. 4th ed. Ontario (CA): Thomson Learning.

Cormen TH, Leiserson CE, Rivest RL, Stein C. 2001. Introduction to Algorithms 2th ed. Cambridge (USA):Massachusetts Institute of Technology Press. Dai YH. 2001. Alternate step gradient method. Academy of mathematics and

Systems Sciences, Chinese Academy os sciences. Repor AMSS-2001-041. Dai YH, Yuan Y. 2003. Alternate minimization gradient method. IMA Journal of

Numerical Analysis, 23: 377-393.

Dai YH. 2013. A New Analysis on the Barzilai-Borwein Gradient Method. Operations Research Society of China, Periodicals Agency of Shanghai University and Spinger –Verlag Berlin Heidelberg.

Griva I, Nash SG, Sofer A. 2009. Linear and Nonlinear Optimization. Philadelphia (USA): Society for Industrial and Applied Mathematics.

Leon SJ. 1998. Linear Algebra with Applications. 5th ed. New Jersey (USA): Prentice Hall.

Snyman JA. 2005. Practical Mathematical Optimization. An Introduction to Basic Optimization Theory and Classical and New Gradient-Based Algorithms. New York (USA): Spinger.

Sun Wenyu, Yuan Y. 2006. Optimization Theory and Methods. Nonlinear Programming. New York (USA): Spinger Science, Business Media.

Verberg D, Purcell J.E, Rigdon S.E. 2007. Calculus Ninth Edition. New Jersey (USA): Prentice Hall, Inc.

Yuan Y. 2006. A new stepsize for the steepest descent method. Journal of Computational Mathematics, 24: 149-156.

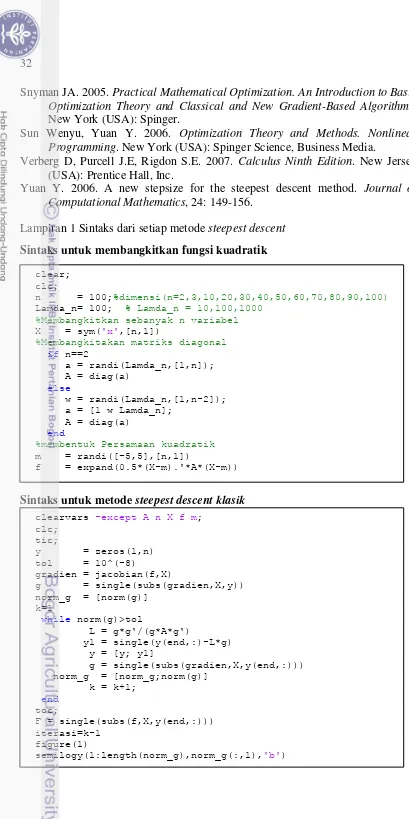

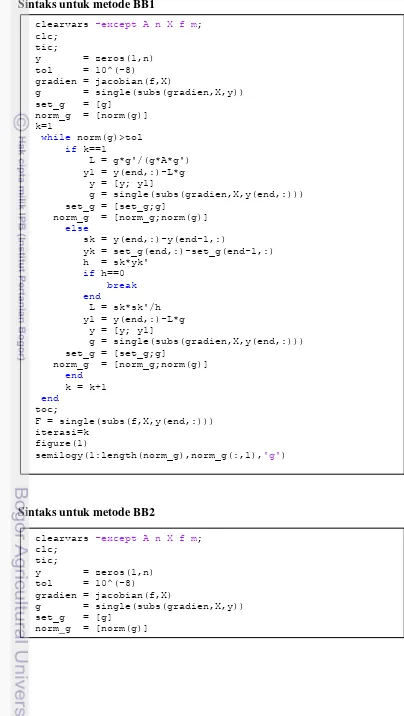

Lampiran 1 Sintaks dari setiap metode steepest descent Sintaks untuk membangkitkan fungsi kuadratik

Sintaks untuk metode steepest descent klasik

clear; clc;

n = 100;%dimensi(n=2,3,10,20,30,40,50,60,70,80,90,100)

Lamda_n= 100; % Lamda_n = 10,100,1000

37

k=1

while norm(g)>tol

if mod(k,4)==1||mod(k,4)==2

L = (g*g')/(g*A*g') y1 = y(end,:)-L*g y = [y; y1]

g = single(subs(gradien,X,y(end,:))) Set_alpha= [Set_alpha ;single(L)]

norm_g = [norm_g;norm(g)]

else

L = (g*g')/(g*A*g')

Set_alpha= [Set_alpha ;single(L)] s = y(end,:)- y(end-1,:)

if s==0

break

end

a1 = 1/Set_alpha(end-1) a2 = 1/Set_alpha(end)

L1 = sqrt((a1-a2).^2+ 4*(g*g')/(s*s'))+a1+a2 LS = single(2/L1)

y1 = y(end,:)-LS*g y = [y; y1]

g = single(subs(gradien,X,y(end,:))) norm_g = [norm_g;norm(g)]

end

k = k+1;

end

toc;

F = single(subs(f,X,y(end,:))) iterasi=k-1

figure(1)

Lampiran 2 Hasil pengujian dari setiap metode steepest descent

Hasil pengujian untuk jumlah iterasi

n λn SD BB1 BB2 AM

2 10 12 14 14 15 24 9 7 11 11 9 9 7 10 9 9 8 6 9 8 8

100 11 22 14 15 26 9 9 8 11 14 9 9 7 10 12 9 7 7 8 9

1000 12 30 16 12 20 10 11 9 9 9 6 10 9 6 10 7 7 7 6 6

3 10 65 69 50 72 34 16 17 17 17 13 15 14 20 17 11 20 20 26 22 20

100 337 358 530 576 429 15 19 18 24 21 17 13 13 19 13 28 12 54 86 26

1000 ** ** ** ** ** 23 41 24 20 18 19 19 13 10 13 80 82 16 96 42

10 10 73 71 70 73 69 27 31 29 26 31 30 29 28 28 27 38 31 38 32 42

100 617 647 505 628 464 69 86 73 76 63 64 58 46 77 50 94 84 76 86 74

1000 ** ** ** ** ** 105 82 78 103 54 51 92 51 58 60 200 198 248 166 76

20 10 69 75 73 66 66 30 26 30 31 27 31 32 29 32 33 36 38 40 36 46

100 518 622 642 628 649 81 44 80 71 55 43 62 65 76 72 76 102 78 94 88

1000 ** ** ** ** ** 98 143 138 131 135 108 109 134 57 102 288 226 204 286 248

30 10 76 79 73 75 69 30 30 29 27 30 30 34 28 32 30 36 42 36 40 38

100 566 644 642 622 616 88 87 74 96 64 90 88 85 82 75 94 70 102 112 96

1000 ** ** ** ** ** 208 148 109 127 214 79 78 102 98 95 216 196 200 216 242

40 10 72 71 73 62 77 32 30 31 32 32 33 30 31 31 32 40 42 37 42 40

100 645 342 642 649 821 79 88 90 84 88 71 84 93 79 78 94 90 96 96 102

1000 ** ** ** ** ** 156 168 181 197 92 143 98 103 134 129 224 234 240 282 190

50 10 70 71 69 66 76 32 29 31 31 29 31 28 32 30 28 40 38 40 40 44

100 638 335 619 616 634 88 64 87 93 83 89 69 71 87 91 107 70 88 98 100

1000 ** ** ** ** ** 128 180 193 178 169 117 97 135 134 153 210 222 314 190 344

60 10 72 74 71 75 73 31 32 33 30 34 30 29 30 30 34 36 40 40 40 34

100 582 232 679 618 598 79 65 99 82 93 75 55 99 82 87 94 66 96 116 86

1000 ** ** ** ** ** 108 196 153 162 146 135 129 108 118 135 214 218 138 218 258

70 10 72 70 71 72 75 29 29 33 30 29 31 32 28 28 30 40 36 42 36 40

100 433 683 596 601 628 93 104 85 108 101 95 83 87 78 78 98 110 108 100 100

1000 ** ** ** ** ** 225 149 150 185 165 126 140 109 137 98 234 232 206 230 703

80 10 75 71 72 76 73 33 28 30 34 38 31 32 27 30 31 43 42 36 36 40

100 547 590 665 616 571 83 107 86 63 91 86 97 97 86 85 92 126 106 112 114

1000 ** ** ** ** ** 199 157 131 138 133 113 125 137 152 140 206 196 284 253 244

90 10 74 72 75 75 72 33 35 33 29 31 32 34 31 30 30 43 36 38 40 40

100 598 663 783 650 662 98 77 106 88 103 95 84 86 85 89 112 99 108 116 90

1000 ** ** ** ** ** 122 181 178 187 132 152 157 130 141 155 242 252 248 210 296

100 10 71 76 68 75 76 34 32 30 33 34 31 30 30 33 30 40 40 40 36 40

100 318 638 588 651 638 60 103 76 87 100 64 97 80 81 79 68 94 94 110 102

1000 ** ** ** ** ** 174 181 157 181 160 131 144 152 139 168 282 243 316 296 172

39 Lanjutan

n λn Yuan Algoritme (4.5) Algoritme (4.6)

2 10 3 3 3 3 3 4 4 4 4 4 5 5 5 5 5

100 3 3 3 3 3 4 4 4 4 4 5 5 5 5 5

1000 3 3 3 3 3 4 4 4 4 4 5 5 5 5 5

3 10 15 25 9 15 11 12 14 12 16 8 13 13 17 18 13

100 11 15 7 7 7 8 12 8 8 10 13 9 9 13 13

1000 7 7 7 7 7 8 8 8 8 8 13 11 9 9 11

10 10 37 31 43 28 31 24 24 28 28 29 25 26 27 29 26

100 59 103 65 82 77 64 60 48 65 40 57 57 41 62 37

1000 131 137 613 141 57 72 84 60 60 56 49 41 53 53 53

20 10 33 31 33 37 33 28 24 29 29 26 31 30 25 33 25

100 65 101 131 107 59 28 56 65 77 40 41 57 87 69 61

1000 219 209 163 161 531 96 118 76 88 72 77 109 89 69 162

30 10 31 35 35 31 29 30 25 28 25 29 30 29 29 32 29

100 115 153 115 114 101 60 72 64 80 60 77 69 79 93 74

1000 617 319 167 147 611 124 112 148 88 116 125 65 97 101 93

40 10 29 31 31 29 34 32 28 28 28 30 30 29 25 26 29

100 131 105 117 133 137 72 60 78 73 81 69 69 69 77 78

1000 721 191 581 525 777 140 132 128 164 128 129 109 137 92 113

50 10 33 39 31 34 31 29 29 33 24 29 25 26 29 25 25

100 127 69 111 115 107 72 54 76 74 72 74 61 73 78 79

1000 679 703 667 827 831 112 108 134 118 104 110 137 129 133 109

60 10 32 31 35 33 33 28 29 36 28 32 26 26 25 26 25

100 113 63 109 119 135 64 49 72 86 78 65 53 77 79 74

1000 487 595 539 323 213 102 132 112 148 140 109 129 105 125 133

70 10 33 33 31 33 31 28 28 29 29 28 25 27 33 26 29

100 131 129 121 105 87 88 81 69 84 65 81 89 83 81 75

1000 613 549 131 575 703 104 128 136 131 140 125 157 119 147 98

80 10 31 35 29 32 37 28 29 28 28 28 29 26 29 25 26

100 101 125 109 117 119 68 76 96 80 68 74 82 77 73 85

1000 599 515 665 677 699 104 152 128 157 120 125 129 113 169 97

90 10 33 35 31 32 33 25 29 30 29 28 25 25 27 25 25

100 113 113 157 139 117 80 70 96 81 72 71 85 74 87 86

1000 461 912 747 599 665 128 144 144 104 120 141 149 129 125 121

100 10 33 33 35 37 33 28 28 28 30 32 29 25 26 29 25

100 80 131 99 131 127 53 88 68 84 92 57 93 73 78 73

Hasil pengujian untuk running time

n λn SD BB1 BB2 AM

2 10 1.0166 0.9557 1.0193 1.3552 1.7324 0.7584 0.5982 0.9671 0.8600 0.7769 0.7302 0.6040 0.8012 0.7748 0.8047 0.6602 0.7020 0.7165 0.6215 0.6401 100 0.9255 1.7883 1.1718 1.1645 1.7460 1.0088 0.7149 0.6933 0.8580 1.1826 0.8208 0.7603 0.5778 0.8134 0.8547 0.7548 0.6881 0.6894 0.7930 0.7983 1000 0.9808 2.0206 1.1582 0.9588 1.3599 0.8533 0.9154 0.6961 0.7939 0.7274 0.5381 0.7640 0.7576 0.5454 0.7989 0.5674 0.6775 0.6451 0.5409 0.5193 3 10 4.6460 4.8915 3.5525 5.3289 2.5318 2.5700 1.2931 1.4581 1.3267 1.1409 1.2226 1.1666 1.6603 1.3337 0.9016 1.6262 1.5989 1.9550 1.7865 1.6176 100 26.3653 29.0768 45.2854 54.4283 36.0311 1.2355 1.5988 1.4089 1.9416 1.9408 1.3145 1.0113 1.1382 1.4690 0.9692 2.1226 0.9858 3.9466 6.5600 1.7558

1000 ** ** ** ** ** 1.7818 2.8121 1.9333 1.5704 3.6063 1.6303 1.4274 1.0316 0.8590 1.1437 5.9586 6.2007 1.2329 7.0326 3.4104

41 Lanjutan

n λn Yuan Algoritme (4.5) Algoritme (4.6)

RIWAYAT HIDUP

Penulis dilahirkan di Kecamatan Telaga Kabupaten Gorontalo pada tanggal 12 Juni 1989, sebagai anak pertama dari 2 bersaudara, dari pasangan Usman Wungguli dan Hadidjah Luther. Pendidikan sarjana ditempuh di Program Studi Pendidikan Matematika, Fakultas MIPA Universitas Negeri Gorontalo, lulus pada tahun 2011. Kesempatan untuk melanjutkan ke program magister pada Program Studi Matematika Terapan IPB diperoleh pada tahun 2012 dengan sponsor beasiswa pascasarjana dari Direktorat Jenderal Pendidikan Tinggi (DIKTI) melalui program Beasiswa Unggulan.

Selama mengikuti perkuliahan, penulis juga aktif dalam berbagai kegiatan akademik maupun nonakademik, diantaranya: peserta Seminar Nasional Sains V dengan tema “Sains sebagai Landasan Inovasi dalam Bidang Energi, Lingkungan dan Pertanian Berkelanjutan” yang diselenggarakan oleh Fakultas MIPA Institut Pertanian Bogor pada tanggal 10 November 2012; peserta Seminar Nasional Matematika IPB Mathematics Challenge 2013 “Life is Meaningless without Mathematics” yang diselenggarakan oleh Gumatika FMIPA IPB pada tanggal 5-6 Oktober 2013; peserta International Seminar on Sciences 2013 (ISS 2013) dengan tema “Perspectives on Innovative Sciences” yang diselenggarakan oleh Fakultas MIPA Institut Pertanian Bogor pada tanggal 15-17 November 2013.