Fakultas Ilmu Komputer

Universitas Brawijaya

2821

Peringkasan Teks Otomatis Secara Ekstraktif Pada Artikel Berita

Kesehatan Berbahasa Indonesia Dengan Menggunakan Metode Latent

Semantic Analysis

Nurina Savanti Widya Gotami1, Indriati2, Ratih Kartika Dewi3

Program Studi Teknik Informatika, Fakultas Ilmu Komputer, Universitas Brawijaya Email: 1[email protected], 2[email protected], 3[email protected]

Abstrak

Meningkatnya jumlah data digital dengan cepat setiap tahunnya, salah satunya adalah data teks dokumen yang dapat berupa teks artikel berita dapat membuat sulit pembaca dalam memahami seluruh informasi sehingga mempengaruhi perolehan informasi yang akurat dan dibutuhkannya waktu yang lebih lama untuk mengekstrasi suatu informasi pada sebuah dokumen. Oleh karena itu, perlu adanya sebuah sistem peringkasan teks otomatis secara ekstraktif pada artikel kesehatan berbahasa Indonesia dengan tujuan membantu pembaca atau pengguna untuk mempermudah dalam proses ekstraksi informasi yang ada pada dokumen dengan waktu yang cepat, ringkas dan jelas. Penelitian ini menggunakan metode latent semantic analysis (LSA) yang merupakan sebuah metode yang mengekstrak struktur semantik atau makna yang tersembunyi pada sebuah kalimat dan menghasilkan ringkasan yang bermakna umum atau luas. Metode LSA menggunakan pendekatan aljabar linear singular value decomposition (SVD) dengan membentuk matriks representasi dari asosiasi term yang merupakan kata-kata pada dokumen yang berhubungan erat dari proses perhitungan TF-IDF. Sedangkan Cross method LSA digunakan untuk menyusun urutan ringkasan dalam tahap ekstraksi ringkasan. Pengujian penelitian ini menghasilkan bahwa hasil peringkasan teks dengan metode LSA memperoleh nilai rata-rata akurasi precision, recall dan f-measure secara berurutan pada compression rate 50% dengan nilai 0.668, 0.743, 0.700 dan 0.690 sedangkan pada compression rate 40% sebesar 0.696, 0.605, 0.642 dan 0.663.

Kata kunci: peringkasan teks ekstraktif, latent semantic analysis,singular value decomposition, compression rate.

Abstract

Increasing the amount of digital data quickly each year, one of which is text data of documents that can be text news articles can make it difficult for the reader to understand all the information so as to affect the acquisition of accurate information and need a longer time to extract an information on a document. Therefore, it is necessary to have an automatic extract text extracting system in Indonesian language health articles in order to help the reader or user to facilitate the process of extraction of information in the document with a fast, concise and clear time. This study uses the latent semantic analysis (LSA) method which is a method that extracts semantic structure or hidden meaning in a sentence and produces a general or broad meaningful summary. The LSA method uses the linear value decomposition (SVD) linear algebra approach by forming a representation matrix of term associations which are words in the closely related document of the TF-IDF calculation process. The LSA cross method is used to construct a summary sequence in the summary extraction stage. Tests of this research resulted that the result of text summary with LSA method obtained the accuracy value of precision, recall and f-measure in consecutive order at compression rate 50% with value 0.668, 0.743, 0.700 and 0.690 while at compression rate 40% equal to 0.696, 0.605 , 0.642 and 0.663.

Keywords: Extractive text summarization, latent semantic analysis,singular value decomposition, compression rate.

1. PENDAHULUAN

World wide web sebagai sumber penyedia

(web surfing) dengan memberikan hasil informasi serta halaman web atau dokumen yang berbeda-beda setiap kali melakukan pencarian informasi sehingga mempersulit proses ekstrasi dari keseluruhan informasi yang tersedia pada sebuah dokumen teks. Jenis-jenis informasi pada penyimpanan cloud di tahun 2020 menurut (Gantz & Reinsel, 2012) diperkirakan data yang paling banyak data berupa dokumen dalam kategori entertainment yakni sebanyak 46,7%, kemudian diikuti kategori komputer serta konsumen elektronik dan kesehatan.

Membaca merupakan salah satu kegiatan yang tidak bisa lepas bagi manusia, baik membaca buku, majalah maupun artikel berita. Masalah muncul apabila teks atau dokumen yang akan dibaca panjang dan banyak karena membutuhkan waktu yang lama untuk dapat memahami isi dokumen tersebut. Salah satu cara agar dapat memahami isi dokumen keseluruhan dengan cepat adalah dengan membaca ringkasannya. Banyaknya informasi yang tersedia pada data teks dokumen yang salah satunya adalah artikel berita membuat proses pengambilan data dari dokumen menjadi lebih sulit dilakukan serta tidak efisien. Sehingga diperlukan sebuah peringkas teks otomatis yang dapat membantu pengurangan isi dokumen yang lebih ringkas dan singkat dengan mengambil inti dokumen serta membuang term tanpa mengurangi makna dari dokumen tersebut (Luthfiarta, et al., 2013). Sehingga dihasilkan sebuah informasi yang bermanfaat dengan jelas dan ringkas, dimana hal ini dapat menghemat waktu serta tenaga yang ada.

Pada penelitian ini akan dibangun sebuah sistem untuk melakukan peringkasan teks agar dapat membantu pembaca memperoleh inti dari sebuah informasi dari sebuah berita dengan waktu yang cepat dengan menggunakan metode

latent semantic analysis (LSA). Metode TF-IDF dari penelitian yang dilakukan oleh (Evan, Pranowo, & Purnomo, 2014) sebagai metode dalam proses pembobotan kata berdasar frekuensi kemunculan kata. Kemudian dilakukan langkah selanjutnya yang pernah dilakukan oleh (Jamhari, Noersasongko, & Subagyo, 2014) yaitu metode Cross latent semantic analysis merupakan metode yang menerapkan ekstraksi dari makna tersembunyi atau dikenal dengan makna semantik yang ada pada sebuah kalimat.

Peringkasan teks sendiri digolongkan menjadi peringkasan teks ekstraktif dan abstraktif. Peringkasan teks secara ekstraktif

merupakan peringkasan teks yang dilakukan dengan menampilkan kembali paragraf atau kalimat dari dokumen teks yang merupakan topik utama sebuah dokumen teks namun dengan bentuk yang sederhana. Sedangkan peringkasan teks abstraktif merupakan sebuah interpretasi dari teks asli yang ada. Kalimat yang terdapat pada dokumen ditransformasikan kembali menjadi kalimat yang lebih singkat (Dalal & Malik, 2014). Penelitian sebelumnya mengenai peringkasan teks yang dilakukan oleh (Prabowo, et al., 2017) menggunakan

normalized google distance yang merupakan metode pengukuran nilai kemiripan kalimat berdasar peristiwa kemunculan term secara bersamaan yang menentukan dari kemiripan setiap objek dari kecenderungan fitur paling dominan (term dan kalimat). Kemudian dengan metode k-means dilakukan untuk mengelompokkan suatu data berdasar labelnya yakni berupa kemiripan antar data yang berperan penting bagi pengujian akurasi nantinya. Namun kekurangan dari metode ini, sebuah pengukuran yang berdasarkan keterkaitan antara seluruh kalimat atau dokumen tapi semakin besar kalimat atau dokumen maka diperlukan fitur kecerdasan yang lebih besar. Selain itu penelitian yang dilakukan oleh (Evan, Pranowo, & Purnomo, 2014) dimana dilakukan peringkasan dokumen dengan menyaring kata-kata penting pada dokumen menggunakan

sentence scoring dengan metode TF-IDF. Pada metode TF-IDF diberikan nilai pada setiap kata sesuai dengan kemunculan kata pada setiap dokumen. Sedangkan sentence scoring

dilakukan dengan menjumlahkan nilai dari setiap kata sehingga diperoleh nilai akhir dari tiap-tiap kalimat. Kalimat yang akan digunakan sebgai ringkasan di pilih berdasarkan peringkat pada dokumen. Penelitian menghasilkan ringkasan yang berupa kalimat-kalimat yang memiliki keterkaitan dengan topik pada sebuah dokumen teks. Namun, pada penelitian ini perlu adanya pengoptimalan pemilihan kalimat yang akan dijadikan ringkasan dengan metode yang mencari kemiripan kata serta kalimat sehingga menghindari adanya redudansi (Evan, Pranowo, & Purnomo, 2014).

(LSA). Metode TF-IDF dari penelitian yang dilakukan oleh (Evan, Pranowo, & Purnomo, 2014) sebagai metode dalam proses pembobotan kata berdasar frekuensi kemunculan kata sehingga kata dengan nilai TF-IDF tinggi, merupakan kata itu memiliki hubungan erat dengan dokumen yang terdapat kemunculan kata tersebut. Kemudian dilakukan langkah selanjutnya yang pernah dilakukan oleh (Jamhari, Noersasongko, & Subagyo, 2014) yaitu metode latent semantic analysis

merupakan metode yang menerapkan ekstraksi dari makna tersembunyi atau dikenal dengan makna semantik yang ada pada sebuah kalimat.

2.

DASAR TEORI

2.1. Data Yang Digunakan

Pengumpulan data dibutuhkan sebagai hal penting dalam proses perhitungan sistem. Data-data yang digunakan meliputi Data-data stoplist atau data yang berisi kata-kata tak penting dalam bahasa Indonesia pada tahap preprocessing

dalam proses filtering serta data dokumen artikel berita kesehatan dari website berita online kompas.com yang akan diringkas oleh sistem sebanyak 10 dokumen. Dokumen artikel berita disimpan dalam bentuk file.txt. Jumlah kalimat yang dipakai pada dokumen tidak lebih dari 20 kalimat. Pakar melakukan ringkasan tidak lebih dari 50% dari keseluruhan isi dokumen. Pakar merupakan guru bahasa Indonesia di SMA Dharma Wanita di kecamatan Pare kabupaten Kediri.

2.2. Prepocessing

Prepocessing merupakan tahap awal pada pemrosesan teks. preprocessing memiliki tujuan menghasilkan term-term indeks dari dokumen teks yang dilakukan agar dapat di proses ke tahap selanjutnya yakni tahap pemrosesan TF-IDF dan metode LSA yang menggunakan SVD agar bersih dari noise yang dapat mengganggu ke tahapan proses selanjutnya. Tahapan dalam

preprocessing dilakukan dengan tahapan

parsing, tokenisasi , filtering dan stemming.

2.2.1 Parsing

Merupakan tahapan dimana akan dilakukan pemisahan string atau struktur di setiap kalimat dengan pembatas simbol titik menjadi komponen-komponen terpisah. Setiap dokumen yang telah dipecah akan dimasukkan kedalam list kalimat. Keluaran dari hasil

segmentasi berupa kumpulan kalimat yang akan digunakan pada proses berikutnya.

2.2.2 Tokenisasi

Merupakan proses pemotongan string input

dari tiap kata penyusunnya atau memisah tiap kata dalam satu dokumen yang dilakukan dalam seluruh kalimat hasil dari proses parsing. Pada tahap ini dilakukan penghilangan angka, tanda baca dan karakter selain huruf alphabet karena dianggap sebagai delimiter atau pemisah kata yang tak memiliki pengaruh dalam pemrosesan teks. Pada tahap lexing juga dilakukan proses

case folding dengan mengubah huruf menjadi huruf kecil.

2.2.3 Filtering

Merupakan suatu tahapan dimana akan dilakukan penghapusan beberapa kata umum atau tidak penting lah lebih dikenal dengan

stoplist atau stopword dari hasil tokenisasi yang telah dikerjakan sebelumnya. Dari proses ini akan dihasilkan kata-kata yang nantinya akan dijadikan term. Proses penghilangan kata tidak penting ini dilakukan dengan menghilangkan kata tak penting yang didapatkan dari data

stoplist penelitian yang dilakukan sebelumnya oleh (Tala, 2003).

2.2.4 Stemming

Merupakan sebuah tahapan mengubah data hasil filtering menjadi kata dasar dengan menghilangkan imbuhan yang ada pada setiap kata. Pada proses ini digunakan library python Sastrawi, dengan menghilangkan imbuhan pada kata dan menjadikan kata dasar sehingga mengurangi variasi kata dengan kata yag juga memiliki kata dasar sama.

2.3. Processing 2.3.1 TF-IDF

Tahap perhitungan TF-IDF dilakukan guna memperoleh bobot dari setiap kata di setiap dokumen. Pembobotan pada setiap kata dilakukan menggunakan term indeks dari

perhitungan frekuensi kemunculan term dalam dokumen yang disebut TF (Term Frequency),lalu menghitung frekuensi kemunculan dokumen yang mengandung term yang disebut DF (document frequency) serta perhitungan IDF (inverse Document Frequency) yang menghitung jumlah dokumen yang mengandung term yang dicari dari beberapa dokumen yang ada.

𝑇𝐹 − 𝐼𝐷𝐹 = 𝑇𝐹 × 𝐼𝐷𝐹 (1)

𝑇𝐹 = 1 + 𝐿𝑜𝑔 𝑡𝑓 (2)

𝐼𝐷𝐹 = 𝑙𝑜𝑔𝑑𝑓(𝑡)𝑁 (3)

Keterangan :

TF-IDF = bobot dokumen terhadap kata TF = banyak kata dicari pada sebuah dokumen IDF = Inversed Document Frequency

N = total dokumen

df = banyak dokumen terdapat kata dicari

2.3.2 Perhitungan LSA

Algoritme LSA merupakan metode yang digunakan untuk menganalisa hubungan antara sebuah frase ataupun kalimat dengan sekumpulan dokumen. Metode statistik untuk menentukan serta menunjukkan kesamaan makna dari beberapa kata dan teks dengan analisis dari beberapa teks dalam jumlah yang banyak. Metode ini juga semantik dari teks dapat dihitung dari proses perhitungan semantik

similarities. LSA sendiri digunakan untuk mengidentifikasi semantik kalimat-kalimat dengan peringkat tertinggi dan yang beda dari yang lain. LSA menggunakan metode aljabar

linear singular value decomposition (SVD). Langkah –langkah pada algoritme LSA adalah sebagai berikut :

1. Pembuatan Inputan Matriks

Inputan matriks diperoleh dari proses perhitungan TF-IDF yang membentuk sebuah matriks A.

2. Singular Value Decomposition

Metode singular value decomposition (SVD) mengubah matriks yang lebih sederhana dengan mendekomposisi menjadi 3 komponen matriks. SVD memiliki kemampuan pemodelan hubungan antara kata - kata dan kalimat serta dapat mereduksi noise yang membantu untuk meningkatkan akurasi.

∑

= Matriks diagonal berdimensi k x k

m

= Jumlah baris matriks

n

= Jumlah kolom matriks

Gambar 1. Dekomposisi Matriks SVD

Untuk menentukan nilai

eigenvalue

serta

eigenvector dari matriks N adalah

sebagai berikut :

𝑁 = 𝐴

𝑇𝐴

(5)

Keterangan :

N = Matriks bujursangkar dimensi m atau n

A = Matriks input proses preprocessing TF-IDF AT = Matriks transpose dari inputan TF-IDF

Untuk

mencari

nilai

eigenvalue

diperoleh dari determinan matriks dengan

aturan Sarrus sebagai berikut :

𝐷𝑒𝑡(𝑁 − 𝜆𝐼)

(6)

untuk mencari nilai matriks ∑ sebagai

berikut :

𝜎

𝑖= √𝜆

𝑖(7)

Matriks ∑ merupakan matriks diagonal

yang terbentuk dari

𝜎

𝑖yang diperoleh dari

akar

eigenvalue

(λ) hasil pemfaktoran

determinan dan menyusun nilai σ

isebagai

Matriks U dibentuk dari perkalian matriks A yang merupakan matriks inputan awal dari proses perhitungan TF-IDF serta matriks V yang diperoleh dari proses normalisasi eigenvector. Sedangkan matriks S-1 merupakan matriks S

yang kemudian di invers.

𝑈 = 𝐴𝑉𝑆

−1(8)

3. Peringkasan Teks

ekstraksi ringkasannya dengan melakukan

perhitungan nilai rata-rata dan panjang

(length) yang diperoleh dari matriks V

Tserta

matriks ∑.

𝑙𝑒𝑛𝑔𝑡ℎ = √∑

𝑗=1𝑛𝑉

𝑖𝑗2𝑥∑

𝑗𝑗2(9)

3. IMPLEMENTASI

Tahapan pada implementasi sistem adalah ditunjukkan pada gambar 2 sebagai berikut :

Gambar 2 Alur Proses Penelitian

Dari alur flowchart hal pertama yang dilakukan pada penelitian ini dengan menginputkan berupa data artikel berita kesehatan. Lalu dilakukan proses preprocessing

diantaranya parsing, tokenisasi, filtering dan

stemming. Kemudian dilakukan perhitungan Tf-IDF untuk mencari bobot dari setiap term. Kemudian dihitung hasil bobot tadi ke proses LSA dengan SVD yang mendekomposisi matriks menjadi 3 matriks dan baru stelah itu akan diekstraksi hasil ringkasan dengan cross mrthod untuk memperoleh hasil ringkasan dari dokumen.

4. PENGUJIAN DAN ANALISIS

Pada pengujian ini akan menggunakan

precision,recall, f-measure dan akurasi yang

dihitung

dengan

nilai

parameter

compression

rate.

Pengujian

pada

compression rate ini dilakukan dengan

dilakukan uji coba sebanyak 6 kali dari besar

persentasenya yaitu dengan nilai 10%, 20%,

30%, 40% dan 50% untuk setiap data teks

dokumen yang akan digunakan. Dipakainya

nilai variasi persentase diatas karena dengan

nilai compression rate dengan besar 10-50%

sudah dapat dikatakan cukup untuk

menghasilkan sebuah ringkasan yang cukup

baik (Alguliev & Aliguliyev, 2009). Namun

sebaiknya sebuah ringkasan tidak lebih dari

50% dari seluruh isi dokumen teks. Nilai

precision,recall, f-measure dan akurasi

dapat dihitung menggunakan persamaan

sebagai berikut :

𝑃𝑟𝑒𝑐𝑖𝑠𝑠𝑖𝑜𝑛 (𝑃) =

(𝑡𝑝+𝑓𝑝)𝑡𝑝(10)

𝑅𝑒𝑐𝑎𝑙𝑙 (𝑅) =

(𝑡𝑝+𝑓𝑛)𝑡𝑝(11)

𝐹 − 𝑀𝑒𝑎𝑠𝑢𝑟𝑒 =

(𝑃+𝑅)2𝑅𝑃(12)

𝐴𝑘𝑢𝑟𝑎𝑠𝑖 =

(𝑡𝑝+𝑓𝑝+𝑡𝑛+𝑓𝑛)𝑡𝑝+𝑡𝑛(13)

True positive (tp) merupakan kalimat yang ada dalam ringkasan manual dan muncul dalam ringkasan sistem. False positif (fp)

kalimat yang ada dalam ringkasan manual tapi tidak muncul di sistem. False negative (fn)

merupakan kalimat yang ada pada ringkasan manual tapi tidak muncil pada ringkasan sistem. Dan true negative (tn) merupakan kalimat yang taka da dalam ringasan manual maupun ringkasan sistem.

Berdasar hasil pengujian diatas nilai

presicion, recall, f-measure dan akurasi pada

pengujian

compression rate 10% dari

seluruh dokumen. Dapat disimpulkan bahwa

pada

compression rate

10% menghasilkan

hasil

precision

tingga dan

recall

yang

rendah. Nilai

precision

tinggi ditentukan

dari ketepatan ringkasan yang dihasilkan

sistem sesuai dengan ringkasan yang

dihasilkan pakar. Sedangkan nilai

recall

yang rendah dikarenakan data yang dipakai

saat digunakan parameter compression rate

10%

hanya

menghasilkan

ringkasan

sejumlah

1 hingga 2 kalimat saja dari

keseluruhan jumlah kalimat ringkasan yang

telah ditentukan. Sedangkan untuk nilai

f-measure

terendah

pada Gambar grafik 6.1

adalah pada dokumen 1 yang bernilai 0.2

sedangkan untuk yang tertinggi adalah 0.333

pada dokumen 3. Untuk akurasi yang

dihasilkan berada pada rata-rata nilai 0.5.

Gambar 3 Pengujian CR 10%

4.2 Pengujian Compression Rate 20%

Tabel 2 Pengujian CR 20%

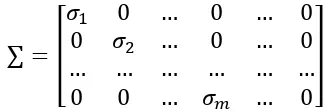

Dari

hasil

pengujian

diatas

menunjukkan

peningkatan

pada

hasil

perhitungan

recall

dikarenakan kenaikan

nilai parameter compression rate 20% yang

berhasil me-retrieve hasil kalimat ringkasan

lebih banyak daripada saat digunakan nilai

compression rate

10%. Beberapa

precision

juga

mengalami

sedikit

penurunan

dikarenakan

bertambahnya

jumlah

ringkasan yang dihasilkan sistem terkadang

merupakan sebuah kalimat ringkasan pada

sistem namun bukan bukan merupakan

ringkasan

menurut

pakar

sehingga

mempengaruhi

hasil

precisionnya.

Sedangkan untuk nilai

f-measure

terendah

pada dokumen 9 yang bernilai 0.25

sedangkan untuk yang tertinggi adalah 0.545

pada dokumen 10. Pada nilai f-measure juga

mengasilkan nilai yang semakin naik apabila

presicion

atau nilai

recall

mengalami

kenaikan. Karena nilai f-measure

merupakan

nilai hubungan antara nilai

precision

dan

recall

itu sendiri. Untuk akurasi yang

dihasilkan cukup stabil dari hasil akurasi

sebelumnya yang dihasilkan pada nilai

compression rate

10 %

yakni masih antara

sekitaran 0.5.

Gambar 4 Pengujian CR 20%

4.3 Pengujian Compression Rate 30%

Tabel 3 Pengujian CR 30%

0 0,2 0,4 0,6 0,8 1

1 2 3 4 5 6 7 8 9

10

R

ata-rata

Evaluasi Pengujian

Compression Rate 10%

CR=10% P CR=10% R

CR=10% F-Measure CR=10% Akurasi

0 0,5 1

1 2 3 4 5 6 7 8 9 10

Rata-…

Evaluasi Pengujian CR 20%

CR=20% P CR=20% R

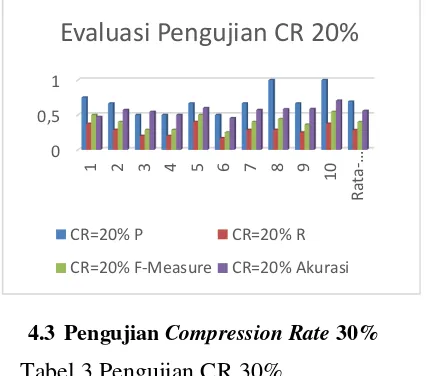

hasil pengujian dapat dilihat bahwa

nilai rata-rata

precission, recall, f-measure

dan akurasi pada nilai

compression rate

sebesar 30% secara berurutan adalah

0.69556, 0.605, 0.64159 dan 0.66333.

Sedangkan nilai

precission, recall,

f-measure

dan

akurasi

tertinggi

pada

compression rate

sebesar 20% secara

berurutan adalah 0.83333, 0.625, 0.71429

dan 0.76471 yakni pada dokumen 10.

Gambar 4 Pengujian CR 30%

4.4 Pengujian Compression Rate 40%

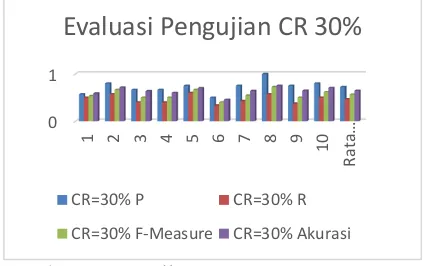

dari hasil pengujian dapat dilihat bahwa nilai

rata-rata precission, recall, f-measure dan

akurasi pada nilai compression rate sebesar

30% secara berurutan adalah 0.66828,

0.74262, 0.70027, 0.69003. Sedangkan nilai

precission, recall, f-measure dan akurasi

tertinggi pada compression rate sebesar 20%

secara berurutan adalah 0.85714, 0.85714,

0.85714 dan 0.83333 yakni pada dokumen 8.

Gambar 5 Pengujian CR 40%

4.5 Pengujian Compression Rate 50%

Tabel 5 Pengujian CR 50%

Dari keseluruhan rata-rata nilai

precission

terbaik terdapat pada nilai

compression rate

10% dengan nilai 0.95

,sedangkan untuk recall

terbaik terdapat

pada nilai

compression rate

50% hal ini

terjadi karena semakin banyak kata yang di

retrieve

oleh sistem akan mengandung

semakin banyak kalimat ringkasan yang

telah ditentukan pakar sebelumnya,untuk

f-measure memiliki nilai tertinggi pada saat

nilai

compression rate

pada saat 40% yang

menunjukkan

hubungan

antara

nilai

precision

dan nilai

recall yakni nilai nonot

harmonic rata-rata dari

precision

dan nilai

recall dan akurasi terbaik terdapat pada nilai

compression rate bernilai 50%. Dari kelima

tabel tersebut juga dapat disimpulkan bahwa

semakin besar nilai

compression rate maka

semakin besar juga rata-rata dari ke-4

akurasi yang didapat.

0 0,5 1

1 2 3 4 5 6 7 8 9

10

Rata-…

Evaluasi Pengujian CR 40%

CR=40% P CR=40% R

CR=40% F-Measure CR=40% Akurasi

0 1

1 2 3 4 5 6 7 8 9

10

Rata…

Evaluasi Pengujian CR 30%

CR=30% P CR=30% R

Gambar 6 Pengujian CR 50%

KESIMPULAN DAN SARAN

Berdasarkan pengujian dan analisis

hasil yang sudah dilakukan maka dapat

diambil kesimpulan sebagai berikut:

Peringkasan

teks

otomatis

secara

ekstraktif pada artikel berita kesehatan

berbahasa Indonesia dengan menggunakan

LSA dapat diterapkan dengan cara LSA

sebagai algoritme untuk mendapat

kalimat-kalimat yang memiliki keterkaitan kata

dengan pendekatan secara semantik dengan

menggunakan SVD sebagai fitur penghilang

redudansi atau

noise pada kata tertentu. Serta

penggunaan

Cross method

LSA sebagai

pengekstrasi ringkasan yang akan dipilih

dari artikel berita kesehatan dalam data teks

dokumen.

Hasil akurasi pada penelitian ini

diperoleh dengan cara pengujian akurasi

precission, recall, f-measure

dan akurasi

terhadap seluruh teks dokumen yang

digunakan. Dimana diperoleh ringkasan

terbaik dengan nilai

compression rate

40%

yang didapati nilai

precission, recall,

f-measure

serta akurasi secara berurutan

adalah 0.75 , 0.6 , 0.667 dan 0.727 serta pada

compression rate

sebesar 50% secara

berurutan adalah 0.668, 0.743, 0.700 and

0.690.

DAFTAR PUSTAKA

Alguliev, R., & Aliguliyev, R. (2009). Evolutionary algorithm for extractive text summarization. Intelligent Information Management, 1(02), 128-138.

Dalal, V., & Malik, L. G. (2014). A Survey of Extractive and Abstractive Text Summarization Techniques, 1-2.

Evan, F. H., Pranowo, & Purnomo, S. Y. (2014). Pembangunan Perangkat Lunak Peringkas Dokumen dari Banyak Sumber Menggunakan Sentence Scoring dengan Metode TF-IDF.

Seminar Nasional Aplikasi Teknologi Informasi (SNATI), 17-22.

Gantz, J., & Reinsel, D. (2012). THE DIGITAL UNIVERSE IN 2020 : Big Data,Bigger Digital Shadows, and Biggest Growth in the Far East. IDC iView: IDC Analyze the future, 2007, 1-16.

Jamhari, M., Noersasongko, E., & Subagyo, H. (2014). PengaruhPeringkas Dokumen Otomatis Dengan Penggabungan Metode Fitur dan Latent Semantic Analysis (LSA) Pada Proses Clustering Dokumen Teks Berbahasa Indonesia. 1, 2355-5920.

Luthfiarta, A., Zeniarja, J., & Salam, A. (2013).

Algoritma Latent Semantic Analysis (LSA) pada Peringkas Dokumen Otomatis Untuk Proses Clustering Dokumen, 1-2.

Noviani, A. (2015). Menkes: 65% Penduduk Sakit, Klaim BPJS Membengkak. Retrieved Januari 07, 2018, from http://finansial.bisnis.com/read/201502 27/215/407320/menkes-65-penduduk-sakit-klaim-bpjs-membengkak

Tala, F. (2003). A Study of Stemming Effects on Information Retrieval in Bahasa Indonesia. M.S. thesis Master of Logic Project. Institute for Logic, Language and Computation. Universiteti van Amsterdam The Netherlands.

0 0,5 1

1 2 3 4 5 6 7 8 9

10

Rata-…

Evaluasi Pengujian CR 50%

CR=50% P CR=50% R