MODUL EXTRACT, TRANSFORM, LOAD (ETL) UNTUK

DATA WAREHOUSE AKADEMIK DEPARTEMEN

ILMU KOMPUTER IPB MENGGUNAKAN KETTLE

NURHASNI FADILAH

DEPARTEMEN ILMU KOMPUTER

FAKULTAS MATEMATIKA DAN ILMU PENGETAHUAN INSTITUT PERTANIAN BOGOR

PERNYATAAN MENGENAI SKRIPSI DAN

SUMBER INFORMASI SERTA PELIMPAHAN HAK CIPTA

Dengan ini saya menyatakan bahwa skripsi berjudul Modul Extract, Transform, Load (ETL) untuk Data Warehouse Akademik Departemen Ilmu Komputer IPB Menggunakan Kettle adalah benar karya saya dengan arahan dari dosen pembimbing dan belum diajukan dalam bentuk apapun ke perguruan tinggi mana pun. Sumber informasi yang berasal atau dikutip dari karya yang diterbitkan maupun tidak diterbitkan dari penulis lain telah disebutkan dalam teks dan dicantumkan dalam Daftar Pustaka di bagian akhir skripsi ini.

Dengan ini saya melimpahkan hak cipta dari karya tulis saya kepada Institut Pertanian Bogor.

ABSTRAK

NURHASNI FADILAH. Modul Extract, Transform, Load (ETL) untuk Data Warehouse Akademik Departemen Ilmu Komputer IPB Menggunakan Kettle. Dibimbing oleh RINA TRISMININGSIH.

Proses extraction, transformation, dan loading (ETL) merupakan proses yang memiliki peranan penting untuk menentukan kualitas dari sebuah data warehouse. ETL menjadi penghubung antara sumber data dan data warehouse. Aktivitas proses seperti pembersihan, pengintegrasian dan pemuatan data ke data warehouse dilakukan pada proses ETL. Pembuatan ETL secara manual terbilang tidak efisien, selain karena jumlah data yang akan terus bertambah juga sumber data yang berbeda-beda menjadi masalah tersendiri dalam pengintegrasian data. Dalam penelitian ini dilakukan pembuatan ETL dengan menggunakan perangkat khusus yang diharapkan dapat mempermudah proses ETL dan menghasilkan data yang konsisten. Perangkat ETL yang digunakan adalah Kettle, sedangkan pemodelan data warehouse menggunakan Pentaho Schema Workbench dan hasilnya divisualisasikan dalam OLAP dengan Mondrian untuk menguji proses ETL. Hasil dari penelitian ini berupa data warehouse yang memiliki ETL dinamis dan terintegrasi.

Kata Kunci: data warehouse, ETL, kettle, mondrian, pentaho schema workbench

ABSTRACT

NURHASNI FADILAH. Extract, Transform, Load (ETL) Module for Academic Data Warehousing at Computer Science Departement of IPB Using Kettle. Supervised by RINA TRISMININGSIH.

Extraction, transformation, and loading (ETL) are processes which have important role to determine data warehouse quality. ETL is bridging between data source and data warehouse. Activities such as cleaning, integration, and data loading at data were done in this process. Making ETL manually is inefficient, because data that will grow and data with different sources become problematic in data integration. This research performs ETL using special tools that are expected to simplified the ETL process and consistently of data output. ETL tool which used are Kettle, while designing a data warehouse using Pentaho Schema Workbench and result are visualized in OLAP in Mondrian to test the ETL process. The result in this research is a data warehouse having integrated and dynamic ETL.

Skripsi

sebagai salah satu syarat untuk memperoleh gelar Sarjana Ilmu Komputer

pada

Departemen Ilmu Komputer

MODUL EXTRACT, TRANSFORM, LOAD (ETL) UNTUK

DATA WAREHOUSE AKADEMIK DEPARTEMEN

ILMU KOMPUTER IPB MENGGUNAKAN KETTLE

NURHASNI FADILAH

DEPARTEMEN ILMU KOMPUTER

FAKULTAS MATEMATIKA DAN ILMU PENGETAHUAN INSTITUT PERTANIAN BOGOR

Judul Skripsi : Modul Extract, Transform, Load (ETL) untuk Data Warehouse Akademik Departemen Ilmu Komputer IPB Menggunakan Kettle Nama : Nurhasni Fadilah

NIM : G64124015

Disetujui oleh

Rina Trisminingsih, SKom MT Pembimbing

Diketahui oleh

Dr Ir Agus Buono, MSi MKom Ketua Departemen

PRAKATA

Segala puji bagi Allah atas ketinggian ilmu-Nya, yang dengannya, Allah memudahkan penulis untuk bisa memahami metode dan menerapkannya. Tentunya hal tersebut diiringi dengan usaha yang optimal. Tak lupa shalawat serta salam teruntuk Nabi Muhammad shalallahu’alaihi wa salam, para sahabat, dan keluarganya hingga akhir zaman.

Tiada ucapan yang sangat ingin disampaikan selain “Alhamdulillah” dan “terima kasih”. Dua kata tersebut mewakili kebahagiaan atas tercapainya penelitian ini dengan lancar. Meskipun masih terdapat kekurangan, penulis berharap hasil penelitian ini dapat memberikan sumbangsih kepada dunia pengetahuan khususnya dalam bidang Ilmu Komputer dan dapat bermanfaat untuk civitas akademika dalam mengelola data warehouse akademik.

Adapun faktor yang sangat berperan terhadap kelancaran penelitian ini adalah bimbingan dari dosen pembimbing dan juga dukungan dari keluarga, maka izinkan penulis untuk menyampaikan terima kasih secara khusus kepada:

1 Ibunda Sumaini dan Ayahanda Hasan Basri serta kakak juga adik yang senantiasa memberikan doa dan dukungan baik moril maupun materiil. 2 Ibu Rina Trisminingsih, SKom MT selaku dosen pembimbing atas

bimbingan dan kesabarannya memberi arahan kepada penulis selama masa penelitian. memberikan kesempatan kepada penulis untuk mendiskusikan beberapa hal yang kurang dipahami dari prosiding beliau.

6 Teman-teman dari Yayasan Rubi Indonesia yang menghibur penulis dikala jenuh dalam mengerjakan penelitian dengan kegiatan-kegiatan yang luar biasa.

7 Teman-teman dari Program Studi S1 Alih Jenis Ilmu Komputer yang saling menyemangati.

Sejatinya, kesuksesan seseorang tidak berasal hanya dari dirinya sendiri tetapi juga karena bantuan, dukungan, doa dan motivasi dari orang-orang di sekelilingnya. Semoga penulis dapat mengamalkan ilmu yang didapat dari universitas untuk menjadi orang yang bermanfaat di kemudian hari.

DAFTAR TABEL

10 Pencocokan fungsi transformasi 18

11 Perbandingan data pada pengujian pertama 22

12 Perbandingan data pada peng kedua 23

DAFTAR GAMBAR

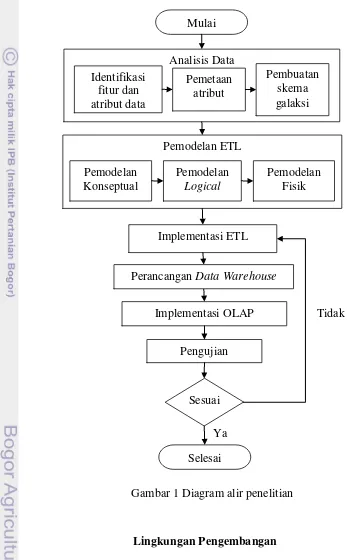

1 Diagram alir penelitian 3

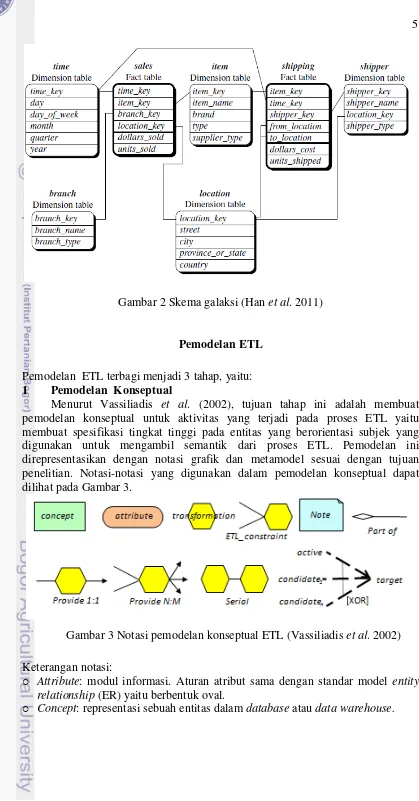

2 Skema galaksi (Han et al. 2011) 5

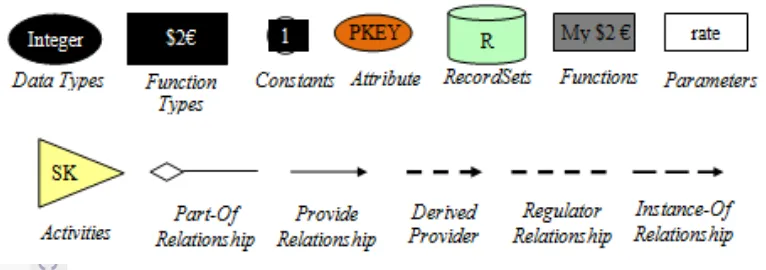

3 Notasi pemodelan konseptual ETL (Vassiliadis et al. 2002) 5 4 Template transformasi (Vassiliadis et al. 2002) 6

5 Notasi pemodelan logical (Simitsis 2005) 6

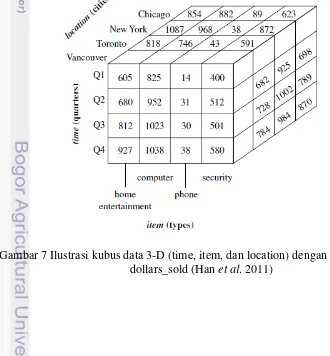

6 Deployment diagram (Lujan-Mora dan Trujilo 2004) 7 7 Ilustrasi kubus data 3-D (time, item, dan location) dengan measures

dollars_sold (Han et al. 2011) 8

8 Skema galaksi (Fhatiyya 2014) 11

9 Perbaikan skema galaksi 12

10 Pemodelan konseptual tabel fakta akademik 13

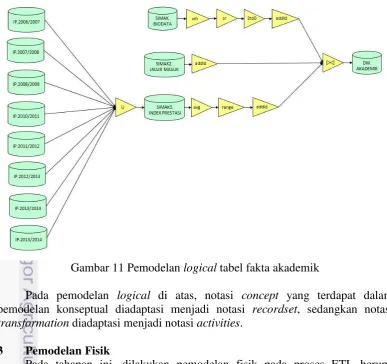

11 Pemodelan logical tabel fakta akademik 14

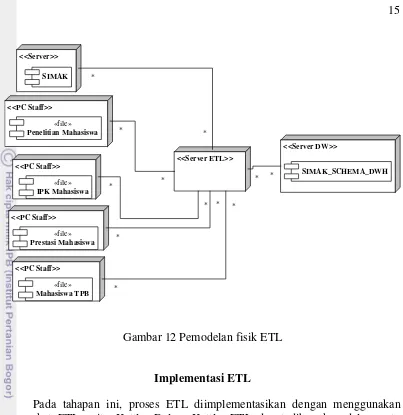

12 Pemodelan fisik ETL 15

13 Modul transformation tabel fakta akademik 16

14 Hasil transformation tabel fakta akademik 17

15 Rancangan job 17

16 Skema multidimensi data warehouse akademik 19

17 Refresh skema 19

18 Visualisasi OLAP 20

19 Hasil step metrics untuk tabel fakta akademik 21

20 Hasil kueri SQL tabel fakta akademik 21

21 Hasil OLAP tabel fakta akademik 22

22 Hasil kueri SQL untuk kabupaten Ciamis 22

23 Hasil OLAP untuk kabupaten Ciamis 22

DAFTAR LAMPIRAN

3 Pemodelan logical tabel fakta tugas akhir 26

4 Pemodelan logical tabel fakta prestasi 26

5 Modul transformation tabel fakta tugas akhir 26

6 Modul transformation tabel fakta prestasi 27

7 Hasil transformation tabel fakta tugas akhir 28

8 Hasil transformation tabel fakta prestasi 28

9 Hasil step metrics tabel fakta tugas akhir 29

10 Hasil step metrics tabel fakta prestasi 29

11 Hasil kueri SQL tabel fakta tugas akhir 30

12 Hasil OLAP tabel fakta tugas akhir 30

13 Hasil kueri SQL tabel fakta prestasi 30

14 Hasil OLAP tabel fakta prestasi 31

15 Hasil kueri SQL untuk kata kunci data warehouse 31

16 Hasil OLAP untuk kata kunci data warehouse 31

17 Hasil kueri SQL untuk kategori PKM 32

PENDAHULUAN

Latar Belakang

Proses extraction, transformation, dan loading (ETL) digunakan untuk memindahkan data dari satu atau banyak sumber data ke dalam target sistem untuk disimpan dalam repositori data, data mart, atau data warehouse. Proses extraction adalah tahap pertama dari serangkaian proses ETL, yakni proses memindahkan data yang relevan ke dalam area staging.Proses selanjutnya adalah proses transformation, proses ini disebut sebagai jantungnya ETL. Teknik pengintegrasian, pembersihan, dan pembuangan data dilakukan pada proses ini sehingga proses ini menjadi lebih kompleks. Proses akhir dari ETL adalah proses loading.Proses ini memasukkan data yang terintegrasi, terkonsolidasi, dan bersih di area staging ke dalam data warehouse (Albrecht et al. 2008).

Dalam pembuatan data warehouse, ETL memiliki peranan penting yang tidak dapat ditinggalkan karena proses ETL akan menentukan kualitas data warehouse. Data yang salah dan kurang relevan akan membuat keputusan bisnis yang salah. Oleh karena itu, pemodelan proses ETL yang baik dan benar akan meningkatkan kualitas data warehouse. Ada beberapa tugas yang harus dilakukan, yakni mengagregasikan data, mengonversi tipe dan format data ke format yang umum, mengecek primary dan foreign keys untuk menjamin kualitas data, dan memberikan surrogate keys untuk data operasional yang terdapat pada data warehouse, serta memfilter data. Tugas-tugas dalam proses ETL yang begitu kompleks membutuhkan pemodelan untuk membantu pemodelan dan pengaturan proses ETL (Trujilo et al. 2003).

Vasiliadis et al. (2002) telah melakukan penelitian dengan membuat pondasi formal untuk merepresentasikan pemodelan konseptual dari sebuah proses ETL. Dalam penelitian tersebut, dihasilkan pemodelan konseptual dengan dilengkapi notasi-notasi grafik yang memudahkan desainer data warehouse untuk membuat dokumentasi proyek data warehouse secara cepat. Selain itu, Simitsis (2005) telah melakukan penelitian untuk pemetaan pemodelan konseptual ke pemodelan logical untuk proses ETL. Penelitian tersebut menghasilkan notasi-notasi grafik yang dapat digunakan dalam membuat pemodelan logical. Lujan-Mora et al. (2004) melakukan penelitian terhadap pemodelan fisik untuk data warehouse menggunakan UML. Penelitian tersebut memberikan tahapan pemodelan yang perlu dibuat dari sumber data sampai OLAP.

Pemodelan ETL juga telah dilakukan oleh Indra dan Painem (2012) untuk mengimplementasikan data warehouse yang mampu menyelesaikan pelaporan Evaluasi Program Studi Berdasarkan Evaluasi Diri (EPSBED) menggunakan Kettle dan berhasil membuat laporan EPSBED dengan cepat. Kemudian, Fhatiyya (2014) telah mengembangkan data warehouse dan OLAP untuk memantau akademik dan prestasi mahasiswa Ilmu Komputer IPB. Namun, pada penelitian tersebut proses ETL yang dilakukan masih manual yaitu pemrosesan data masih menggunakan dokumen Microsoft Excel. Hal ini akan menjadi kendala ketika data yang diolah sangat banyak.

2

melakukan pemodelan data warehouse menggunakan Pentaho Schema Workbench dan memvisualisasikannya dalam OLAP menggunakan Mondrian. Ketiga perangkat lunak tersebut merupakan open source dari Pentaho Corporation. Penelitian ini mengadopsi skema galaksi yang telah dibuat oleh Fhatiyya (2014). Skema tersebut menjadi acuan dalam pembuatan proses ETL. Hasil dari penelitian ini berupa data warehouse yang memiliki ETL dinamis dan terintegrasi.

Perumusan Masalah

Rumusan masalah dalam penelitian ini adalah:

1 Bagaimana menerapkan pemodelan konseptual, logical, dan fisik untuk proses ETL pada data SIMAK IPB dengan mengacu skema multidimensi Fhatiyya (2014)?

2 Bagaimana mengimplementasikan pemodelan ETL menggunakan Kettle? 3 Bagaimana merancang data warehouse?

4 Bagaimana cara menguji proses ETL?

Tujuan Penelitian

Adapun tujuan dari penelitian ini adalah:

1 Membuat pemodelan dan mengimplementasikan proses ETL untuk data warehouse akademik.

2 Merancang data warehouse dan membangun aplikasi OLAP untuk menguji ETL.

Manfaat Penelitian

Penelitian ini diharapkan dapat memberikan manfaat bagi para stakeholder untuk mendukung pengambilan keputusan di Departemen Ilmu Komputer.

Ruang Lingkup Penelitian

Ruang lingkup penelitian ini adalah: 1 Penelitian ini menggunakan data dari:

o Data akademik Ilmu Komputer IPB dari DIDSI IPB tahun 2006-2013. o Data Indeks Prestasi Mahasiswa (IPK) tahun 2006-2015.

o Data jalur masuk tahun 2007-2009.

o Data prestasi mahasiswa Ilmu Komputer tahun 2012 dan 2013. o Data tugas akhir mahasiswa tahun 2006-2008.

o Data pulau, provinsi, kabupaten di seluruh Indonesia merujuk pada data

BPS (Badan Pusat Statistik) tahun 2014.

2 Pembuatan ETL mengadopsi skema galaksi yang telah dibuat Fhatiyya (2014).

3

METODE

Penelitian ini dikembangkan dengan beberapa tahap penelitian, diagram alir penelitian dapat dilihat pada Gambar 1.

Lingkungan Pengembangan

Penelitian ini diimplementasikan menggunakan spesifikasi perangkat keras dan lunak sebagai berikut:

4

1 Perangkat Keras

Spesifikasi perangkat keras yang digunakan adalah:

o Intel® Dual Core™ CPU 2.10GHz

o Java Runtime Environment (JRE) 7 o Java Development Kit (JDK) 1.7.0_67

o MySQL 5.5.32

o Microsoft Visio 2007 untuk membuat desain skema data warehouse o Microsoft Word 2007 untuk membuat pemodelan ETL

o Pentaho Skema Workbench 3.8 o Pentaho BI Server 4.8

Analisis Data

Pada tahap ini data dianalisis dengan 3 tahap, yaitu:

1 Identifikasi fitur dan atribut data

Tahapan ini untuk mengidentifikasi data yang terlibat dalam pemodelan ETL dan melakukan pengecekan isi data secara manual untuk mengetahui apakah isi data sudah sesuai atau belum. Isi data dikatakan sesuai apabila data tidak bernilai null, data bersifat tunggal dalam satu baris, dan tidak terdapat kesalahan ejaan.

2 Pemetaan atribut

Tahapan ini untuk memetakan atribut pada data operasional ke atribut yang ada pada data warehouse. Hal tersebut guna menghindari konflik nama pada atribut yang biasa terjadi karena menggunakan lebih dari satu sumber data. Konflik atribut dapat mempengaruhi konsistensi data pada saat dilakukan pemuatan ke dalam data warehouse.

3 Pembuatan skema galaksi

Sebuah data warehouse dan OLAP bersandar pada model data multidimensi. Model data multidimensi biasanya memiliki sebuah tabel yang menjadi pusat untuk tabel lainnya, tabel ini dinamakan tabel fakta. Pada tabel fakta terdapat numeric measures yang nilainya berasal dari tabel dimensi yang dipilih untuk dianalisis keterhubungannya.

5

Gambar 2 Skema galaksi (Han et al. 2011)

Pemodelan ETL

Pemodelan ETL terbagi menjadi 3 tahap, yaitu:

1 Pemodelan Konseptual

Menurut Vassiliadis et al. (2002), tujuan tahap ini adalah membuat pemodelan konseptual untuk aktivitas yang terjadi pada proses ETL yaitu membuat spesifikasi tingkat tinggi pada entitas yang berorientasi subjek yang digunakan untuk mengambil semantik dari proses ETL. Pemodelan ini direpresentasikan dengan notasi grafik dan metamodel sesuai dengan tujuan penelitian. Notasi-notasi yang digunakan dalam pemodelan konseptual dapat dilihat pada Gambar 3.

Keterangan notasi:

o Attribute: modul informasi. Aturan atribut sama dengan standar model entity relationship (ER) yaitu berbentuk oval.

o Concept: representasi sebuah entitas dalam database atau data warehouse.

6

o Transformation: representasi sebagian atau seluruh dari kode modul yang mengeksekusi tugas tunggal.

o ETL Constraints: atribut konsep yang memenuhi banyak syarat. o Note: tags informal yang dibuat desainer data warehouse.

o Part of Relationship: konsep dibentuk dari kumpulan atribut.

o Candidate relationship: konsep memiliki lebih dari satu sumber data yang

dapat dimuat ke target.

o Active candidate relationship: candidate relationship yang memiliki kesamaan

struktur dan penyaringan semantik.

Untuk notasi transformasi terdapat template yang dapat digunakan untuk melengkapi pemodelan konseptual. Template dapat dilihat pada Gambar 4.

Gambar 4 Template transformasi (Vassiliadis et al. 2002)

2 Pemodelan Logical

Menurut Simitsis (2005), tujuan pemodelan logical adalah untuk menyingkat aliran data dari aktivitas data warehouse dan penyimpanan data. Notasi grafik pemodelan logical dapat dilihat pada Gambar 5.

Keterangan notasi:

o Attributes: karakteristik nama dan tipe data.

7

o Recordset: karakteristik berdasarkan nama (kumpulan record dalam skema recordset).

o Elementary Activites: abstraksi logical untuk sebagian atau seluruh modul kode. o Provider relationship: menghubungkan activities dari atribut dengan recordset.

o Part-of relationship: menghubungkan atribut dan parameter ke activities, recordset, atau fungsi.

3 Pemodelan Fisik

Menurut Lujan-Mora dan Trujilo (2004), pemodelan fisik untuk proses ETL dapat didefinisikan dengan Integration Transportation Diagram (ITD). ITD adalah struktur fisik dari proses ETL yang digunakan untuk memuat data dari sumber data ke data warehouse. Diagram yang dimaksud adalah deployment diagram. Deployment diagram merupakan sebuah diagram yang menggambarkan konfigurasi waktu dalam memproses elemen dan komponen perangkat lunak, proses dan objek yang dieksekusi. Ilustrasi deployment diagram dapat dilihat pada Gambar 6.

Gambar 6 Deployment diagram (Lujan-Mora dan Trujilo 2004)

Implementasi ETL

Tahap ketiga dari penelitian ini adalah implementasi ETL. Menurut Caster et al. (2010), terdapat 3 tahap dalam implementasi ETL, yaitu:

1 Ekstraksi

8

2 Transformasi

Tahap transformasi memproses hasil ekstraksi data dengan operasi-operasi transformasi. Beberapa operasi yang dapat dilakukan pada tahapan ini sebagai berikut:

o Memindahkan data. o Melakukan validasi data.

o Melakukan modifikasi isi atau struktur data. o Mengintegrasikan data dengan data lainnya.

o Menghitung nilai pembagian atau agregasi berdasarkan proses data.

3 Loading

Tahapan ini adalah tahapan akhir dari implementasi ETL. Pada tahapan ini dilakukan proses pemuatan data ke sistem yang menjadi target. Proses yang terjadi adalah mengelola surrogate keys dan mengelola tabel dimensi.

Perancangan Data Warehouse

Perancangan data warehouse merupakan tahapan setelah implementasi ETL. Perancangan ini dilakukan untuk mengubah bentuk data relasional ke data multidimensi. Memetakan seluruh tabel fakta dan dimensi ke kubus-kubus data multidimensi. Sebuah kubus data dapat memodelkan dan menampilkan banyak dimensi. Sebuah kubus di dalam struktur geometri biasanya merepresentasikan data 3-D, namun di dalam data warehouse, kubus dapat merepresentasikan n-dimensi (Han et al 2011). Ilustrasi kubus data dapat dilihat pada Gambar 7.

9

Pengujian ETL

Pada tahap ini, terdapat dua tahap pengujian, yaitu:

1 Pengujian ETL

Pengujian ini dilakukan dengan melihat step metrics dari tab hasil eksekusi pada Kettle saat menjalankan modul transformation. Pada step metrics terdapat kolom active yang menjadi acuan untuk menentukan keberhasilan proses ETL. Kolom tersebut memiliki beberapa status, yakni halting, stopped, dan finished. Status halting menandakan pengeksekusian proses terhambat, stopped menandakan proses terhenti karena error, dan finished menandakan proses berhasil dieksekusi.

2 Pengujian data warehouse

Tahap pengujian ini adalah menguji data warehouse dari hasil yang divisualisasikan oleh OLAP dengan hasil kueri pada basis data. Kemudian hasil tersebut dibandingkan untuk mengetahui perhitungan keduanya sesuai.

HASIL DAN PEMBAHASAN

Analisis Data

Data yang digunakan berasal dari 6 sumber data yaitu basis data simak.sql, kumpulan data prestasi.xls, data tugas akhir.xls, kumpulan data index prestasi mahasiswa.xls, data kota/kabupaten.xls, dan data jalur masuk.xls.

1 Identifikasi Fitur dan Atribut

Tahap analisis pertama adalah mengidentifikasi fitur dan atribut. Pengidentifikasian ini menggunakan cara manual. Pada basis data ditemukan kesalahan ejaan yakni pada tabel biodata dengan kolom jenis kelamin. Pada umumnya, data jenis kelamin diisikan dengan notasi biner antara 0 atau 1. Namun, sebanyak 60 baris dari 1111 baris data terisi dengan notasi 2. Pada 60 baris tersebut seluruhnya adalah perempuan, sehingga data tersebut perlu diganti dengan notasi yang seharusnya.

Pada data kata kunci skripsi terdapat beberapa kesalahan ejaan sehingga perlu dipetakan ke katayang benar, misalkan: Belief Revison diganti ke Belief Revision. Kemudian, untuk data prestasi, atribut yang dibutuhkan dari data prestasi, yakni kategori, tingkat, bidang. Namun, 3 atribut tersebut tidak ada didalam fail sehingga harus menambahkannya sendiri. Pada data prestasi juga, terdapat merging pada kolom prestasi sehingga perlu diuraikan menjadi baris-baris tunggal. Selain itu, data kota yang terdapat pada tabel biodata, ada beberapa kota yang mengalami perubahan sehingga tidak lagi menjadi kota/kabupaten, seperti Bekasi Barat. Kabupaten Bekasi Barat sudah berubah menjadi kecamatan dan kini termasuk dalam Kabupaten Bekasi berdasarkan data yang didapat dari BPS.

10

itu, pada data IPK ada beberapa fail di mana kolom IPK berisi banyak nilai (tidak hanya nilai IPK, tetapi juga predikat). Hal tersebut akan menyulitkan proses pengekstrakan data sehingga perlu dilakukan pemisahan data antara IPK dan predikat.

2 Pemetaan Atribut

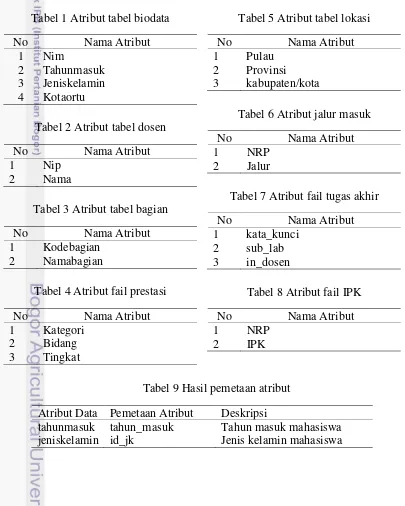

Tahap analisis selanjutnya dilakukan pemetaan atribut terhadap data yang telah dipilih, yakni menyeleksi dan memetakan nama atribut. Atribut yang terlibat dalam setiap fail dapat dilihat pada Tabel 1-8. Untuk Tabel 1, 2, dan 3 atribut diambil dari basis data akademik. Untuk Tabel 4 atribut diambil dari fail prestasi. Untuk Tabel 5 atribut diambil dari fail kabupaten/kota. Untuk Tabel 6 atribut diambil dari fail jalur masuk. Untuk Tabel 7 atribut diambil dari fail tugas akhir. Untuk Tabel 8 atribut diambil dari fail IPK. Penyeleksian dan pemetaan nama atribut dilakukan untuk menghindari konflik nama pada atribut. Hasil pemetaan atribut dapat dilihat pada Tabel 9.

Tabel 1 Atribut tabel biodata

No Nama Atribut

1 Nim

2 Tahunmasuk 3 Jeniskelamin 4 Kotaortu

Tabel 2 Atribut tabel dosen

No Nama Atribut

1 Nip

2 Nama

Tabel 3 Atribut tabel bagian

No Nama Atribut

1 Kodebagian 2 Namabagian

Tabel 4 Atribut fail prestasi

No Nama Atribut

1 Kategori 2 Bidang 3 Tingkat

Tabel 5 Atribut tabel lokasi

No Nama Atribut

1 Pulau 2 Provinsi 3 kabupaten/kota

Tabel 6 Atribut jalur masuk

No Nama Atribut

1 NRP

2 Jalur

Tabel 7 Atribut fail tugas akhir

No Nama Atribut

1 kata_kunci 2 sub_lab 3 in_dosen

Tabel 8 Atribut fail IPK

No Nama Atribut

1 NRP

2 IPK

Tabel 9 Hasil pemetaan atribut Atribut Data Pemetaan Atribut Deskripsi

11 Jalur jalur_masuk Jalur masuk mahasiswa

kodebagian id_lab Kode lab keilmuan

sub_lab id_lab Kode lab keilmuan

Namabagian lab_keilmuan Lab keilmuan

Nip id_dosen_ps Nomor induk pegawai (dosen) in_dosen id_dosen_ps Nomor induk pegawai (dosen)

Nama dosen_ps Nama dosen

kata_kunci kata_kunci_skripsi Kata kunci skripsi mahasiswa Kategori kategori_kompetensi Kategori kompetensi prestasi Bidang bidang_komp Bidang kompetensi prestasi Tingkat tingkat_kompetensi Tingkat kompetensi prestasi

Pulau Pulau Nama pulau

Provinsi Provinsi Nama provinsi Kabupaten Kabupaten Nama kabupaten

IPK rataan_ipk Rataan ipk mahasiswa

Untuk atribut nim/nrp tidak dilakukan pemetaaan karena atribut tersebut tidak akan dimasukkan ke dalam skema galaksi. Atribut tersebut hanya akan digunakan untuk menggabungkan data yang di dalamnya memiliki atribut nim/nrp.

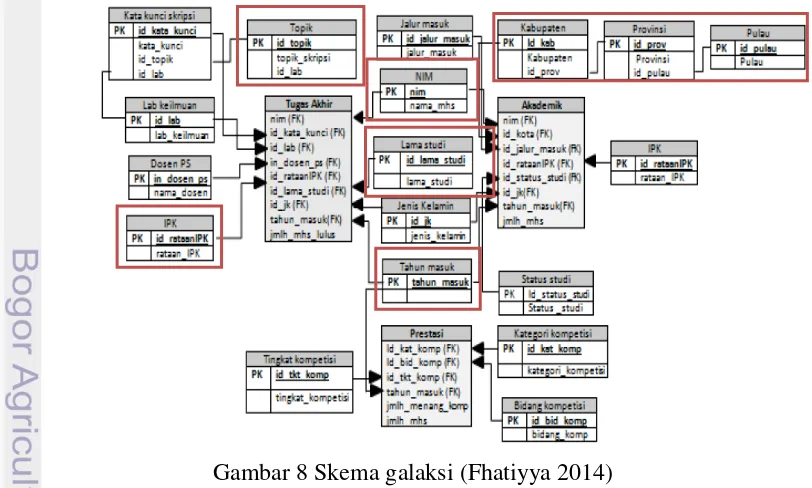

3 Pembuatan Skema Galaksi

Pada tahapan ini dilakukan perbaikan skema multidimensi yang telah dibuat Fhatiyya (2014) dengan menghapus beberapa dimensi, yakni dimensi topik, dimensi nim, dimensi lama studi, dan dimensi IPK. Skema Fhatiyya (2014) dapat dilihat pada Gambar 8. Dimensi yang terhapus dan berubah ditandai dengan kotak warna merah.

Gambar 8 Skema galaksi (Fhatiyya 2014)

12

Penghapusan dimensi lama studi dikarenakan data lama studi tidak dibutuhkan dalam penelitian ini. Selain itu, dimensi IPK pada skema terdapat dua sehingga perlu dihapus salah satunya.

Pada skema juga dilakukan penyatuan beberapa dimensi, yakni dimensi kabupaten, provinsi, dan pulau. Hal tersebut dikarenakan operasi OLAP seperti roll up dapat dilakukan lebih dari 1 kali sehingga akan lebih baik disatukan dalam dimensi yang sama.

Untuk dimensi kabupaten, provinsi, dan pulau pada penelitian ini dijadikan satu dimensi, yaitu dimensi lokasi. Untuk data status studi dan rataan IPK tidak terdapat pada 6 sumber data di atas sehingga akan dilakukan generate rows saat implementasi ETL.

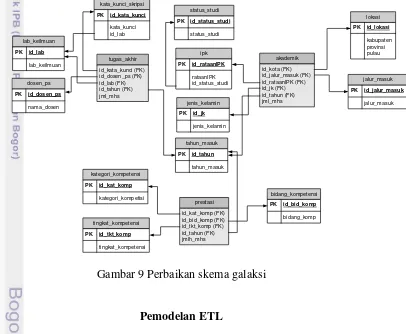

Setelah dilakukan penghapusan dan perbaikan skema, maka pada skema yang baru terdapat 12 tabel dimensi dengan 3 tabel fakta. Skema perbaikan dapat dilihat pada Gambar 9.

Gambar 9 Perbaikan skema galaksi

Pemodelan ETL

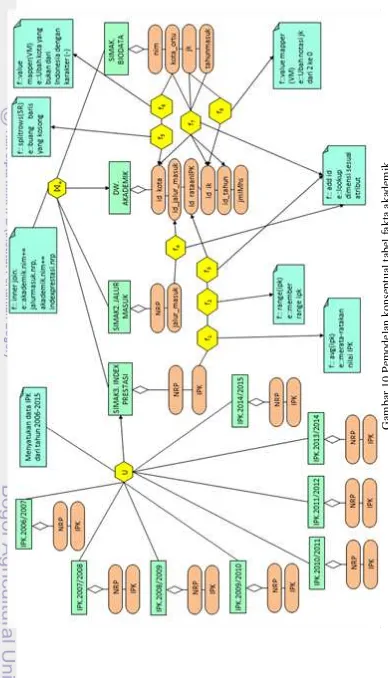

1 Pemodelan Konseptual

13

Ga

mbar

10 P

emodela

n k

onsep

tual tabe

l fa

kt

a a

ka

de

mi

14

Pada data biodata diperlukan fungsi value mapper untuk memetakan nama kota yang sesuai dengan data BPS dan untuk mengubah angka 2 pada kolom jenis kelamin menjadi angka 1. Selain itu, data biodata juga memerlukan fungsi split rows untuk membuang baris yang kosong. Sebuah fungsi lookup dimensions diperlukan oleh seluruh sumber data karena untuk mendapatkan seluruh id dari atribut yang terlibat di dalam pemodelan ini.

Pemodelan konseptual untuk tabel fakta tugas akhir dan prestasi dapat dilihat pada Lampiran 1 dan 2.

2 Pemodelan Logical

Pada tahapan ini dilakukan pemodelan logical, yakni model yang mengadaptasi fungsi transformasi dari pemodelan konseptual kemudian mengubah notasi transformasi tersebut dengan notasi yang berlaku pada pemodelan logical. Dengan rancangan ini, dapat terlihat dengan jelas semua fungsi transformasi yang dilakukan per tahapan sebelum dimuat ke dalam data warehouse. Pemodelan logical untuk tabel fakta akademik dapat dilihat pada Gambar 11. Pemodelan logical untuk tabel fakta tugas akhir dan prestasi dapat dilihat pada Lampiran 3 dan 4.

Gambar 11 Pemodelan logical tabel fakta akademik

Pada pemodelan logical di atas, notasi concept yang terdapat dalam pemodelan konseptual diadaptasi menjadi notasi recordset, sedangkan notasi transformation diadaptasi menjadi notasi activities.

3 Pemodelan Fisik

15

Gambar 12 Pemodelan fisik ETL

Implementasi ETL

Pada tahapan ini, proses ETL diimplementasikan dengan menggunakan perangkat ETL yaitu Kettle. Dalam Kettle, ETL dapat dibungkus dalam satu transformation dan dapat dijalankan secara bersamaan. Kettle memiliki GUI yaitu Spoon. Pada Spoon inilah, pemodelan modul transformation dan job dilakukan dengan menarik ikon yang diperlukan ke dalam kanvas yang tersedia. Modul transformation yang dihasilkan sebanyak 12 modul untuk tabel dimensi dan 3 moduluntuk tabel fakta serta 1 modul job.

Modul transformation untuk tabel fakta akademik membentuk 78 buah langkah dari proses ekstrak data sampai pemuatan data ke target. Proses ekstrak memakai 21 fungsi ekstrak data, proses transformasi memakai 56 fungsi transformasi dan proses loading memakai 1 fungsi untuk memuat data ke target. Modul transformation tersebut dapat dilihat pada Gambar 13.

Modul transformation untuk tabel fakta tugas akhir dan prestasi dapat dilihat pada Lampiran 5 dan 6. Semua fungsi transformasi utama yang terdapat dalam pemodelan konseptual, telah berhasil diimplementasikan. Meskipun dalam penerapannya ada fungsi transformasi tambahan yang dilakukan sebelum menjalankan fungsi utama.

16

Ga

mbar

13 Modul

trans

format

ion

tabe

l fa

kta a

k

ade

mi

17

Gambar 14 Hasil transformation tabel fakta akademik

Setelah modul transformation dibuat, maka diperlukan sebuah modul job untuk menjalankan seluruh modul transformation yang ada. Selain itu, modul job digunakan untuk memuat data bila terjadi perubahan pada data sumber, rancangan modul job dapat dilihat pada Gambar 15.

Pada rancangan job, apabila transformation berhasil diperbaharui maka dilaporkan sukses melalui ikon success, jika tidak berhasil maka transformation yang gagal akan dilaporkan melalui ikon mail failure.

18

Pencocokan fungsi transformasi yang ada pada pemodelan konseptual dengan yang ada pada implementasi ETL untuk tabel fakta akademik dapat dilihat pada Tabel 10.

Tabel 10 Pencocokan fungsi transformasi Fungsi Transformasi

Pemodelan Konseptual Implementasi ETL (Kettle)

(append stream 17)

(group by)

(number range)

(dimension lookup)

(split field to rows)

(value mapper)

(inner join)

Perancangan Data Warehouse

Pada tahapan ini dilakukan perancangan untuk data warehouse dengan menggunakan Pentaho Skema Workbench 3.8. Pada pemodelan ini, dilakukan pembuatan kubus data untuk tabel fakta. Pada penelitian ini, terdapat tiga tabel fakta maka kubus yang terbentuk sebanyak tiga, yakni kubus akademik, kubus prestasi, dan kubus tugas akhir. Hasil skema multidimensi dapat dilihat pada Gambar 17.

19

Gambar 16 Skema multidimensi data warehouse akademik

Implementasi Data Warehouse

Pada tahapan ini rancangan data warehouse di publish ke dalam folder Pentaho BI Server. Setelah itu, dilakukan refresh skema pada Pentaho User Console. Refresh skema dapat dilihat pada Gambar 17.

Gambar 17 Refresh skema

20

Gambar 18 Visualisasi OLAP

Pengujian

Setelah tahapan implementasi ETL dan pemodelan data warehouse selesai, maka tahap selanjutnya adalah pengujian. Pengujian ini dilakukan dengan 2 tahap yaitu menguji ETL dan menguji data warehouse.

1 Pengujian ETL

21

Gambar 19 Hasil step metrics untuk tabel fakta akademik

2 Pengujian data warehouse

Pada tahap ini dilakukan dua kali perngujian. Pengujian pertama dilakukan dengan membandingkan total jumlah mahasiswa per tabel fakta dan pengujian kedua dilakukan dengan membandingkan jumlah mahasiswa pada level terbawah dari sebuah dimensi.

o Pengujian pertama

Pengujian untuk tabel fakta akademik dapat dilihat pada Gambar 20 dan Gambar 21. Total jumlah mahasiswa yang dihasilkan dari kueri SQL dan OLAP adalah sesuai yaitu 208 mahasiswa. Total tersebut adalah total jumlah mahasiswa yang terdapat pada tabel fakta akademik. Pengujian untuk tabel fakta tugas akhir dapat dilihat pada Lampiran 11 dan 12. Pengujian untuk tabel fakta prestasi dapat dilihat pada Lampiran 13 dan 14.

22

Gambar 21 Hasil OLAP tabel fakta akademik

o Pengujian kedua

Pengujian kedua untuk tabel fakta akademik dapat dilihat pada Gambar 22 dan Gambar 23 Jumlah mahasiswa dari kabupaten Ciamis yang dihasilkan dari kueri SQL dan OLAP adalah sesuai yaitu 4 mahasiswa. Pengujian kedua untuk tabel fakta tugas akhir dapat dilihat pada Lampiran 15 dan 16. Pengujian kedua untuk tabel fakta prestasi dapat dilihat pada Lampiran 17 dan 18.

Hasil perbandingan data pada pengujian pertama dapat dilihat pada Tabel 11 dan hasil perbandingan data pada pengujian kedua dapat dilihat pada Tabel 12.

Tabel 11 Perbandingan data pada pengujian pertama Tabel Fakta Kueri SQL Mondrian Hasil

Akademik 208 data 208 data Sesuai Tugas Akhir 197 data 197 data Sesuai Prestasi 86 data 86 data Sesuai Gambar 22 Hasil kueri SQL untuk kabupaten Ciamis

23 Tabel 12 Perbandingan data pada pengujian kedua

Tabel Fakta Tabel Dimensi Kueri SQL Mondrian Hasil Akademik Kabupaten Ciamis 4 data 4 data Sesuai Tugas Akhir Kata kunci data warehouse 5 data 5 data Sesuai Prestasi Kategori PKM 49 data 49 data Sesuai

SIMPULAN DAN SARAN

Simpulan

Penelitian ini berhasil membuat tiga pemodelan ETL yaitu pemodelan konseptual, pemodelan logical, dan pemodelan fisik. Pemodelan ETL tersebut berhasil diimplementasikan dengan Kettle dan menghasilkan 12 jenis transformation untuk tabel dimensi dan 3 transformation untuk tabel fakta serta 1 jenis job sebagai model yang dapat menjalankan seluruh transformation yang ada secara sekuensial. Selain itu, penelitian ini juga berhasil membuat pemodelan data warehouse dengan menghasilkan 3 kubus data multidimensi yaitu kubus akademik, kubus prestasi, dan kubus tugas akhir menggunakan Pentaho Schema Workbench. Kubus data tersebut berhasil divisualisasikan dalam aplikasi OLAP untuk menguji proses ETL.

Saran

Saran untuk penelitian tentang ETL selanjutnya adalah pemodelan ETL perlu disempurnakan lagi agar tercapai model yang optimal. Data yang berkaitan juga perlu dilengkapi mencakup seluruh mahasiswa yang ada di Departemen Ilmu Komputer, agar ketika digabungkan data yang terbuang tidak terlalu banyak. Selain itu, perlu dibangun sebuah modul program pada sistem informasi akademik yang terhubung dengan tombol start di fail job supaya data dapat terubah dapat diproses oleh ETL secara otomatis.

DAFTAR PUSTAKA

Albrecht A, Naumann F. 2008. Managing ETL Processes. VLDB ’08; 24-30 Agustus; Auckland, New Zealand. Auckland (NZ): ACM.

Caster C, Bouman R, Dongen JV. 2010. Pentaho Kettle Solutions: Building Open Source ETL Solutions With Pentaho Data Integration. Indianapolis (IN): Wiley.

24

Han J, Kamber M, Pei J. 2011. Data Mining: Concepts and Techniques. 3rd Ed. United Stated of America (USA): Morgan Kaufmann Publisher.

Indra, Painem. 2012. Model Extract, Transform, Load (ETL) Pada Data Warehouse Untuk Pelaporan Evaluasi Program Studi Berdasarkan Evaluasi Diri (EPSBED) Menggunakan Model Data Warehouse EPSBED Studi Kasus: Universitas Budi Luhur. 9 (1): 54-60.

Kimball R, Ross M. 2013. The Data Warehouse Toolkit: The definitive guide to Dimensional Modelling. Indianapolis (IN): Wiley.

Lujan-Mora S, Trujilo J. 2004. Physical Modeling of Data Warehouses using UML. DOLAP 2004; 12-13 November; Washington, DC, USA. Washington (USA): ACM. hlm 48-57.

Rahm E, Do HH. 2000. Data Cleaning: Problems and Current Approaches. Jerman (DE): University of Leipzeig.

Simitsis A. 2005. Mapping Conceptual to Logical Model for ETL Processes. DOLAP 2005; 4-5 November; Bremen, Jerman. Bremen (DU): ACM. hlm 67-76.

Trujilo J, Lujan-Mora S. 2003. UML Based Aproach for Modelling ETL Processes in Data Warehouse. Spain (ES): Universidad de Alicante.

25 Lampiran 1 Pemodelan konseptual tabel fakta tugas akhir

26 Lampiran 3 Pemodelan logical tabel fakta tugas akhir

Lampiran 4 Pemodelan logical tabel fakta prestasi

27

La

mpi

ra

n

6 Modul

trans

format

ion

tabe

l fa

kta pr

es

28

Lampiran 7 Hasil transformation tabel fakta tugas akhir

29 Lampiran 9 Hasil step metrics tabel fakta tugas akhir

30

Lampiran 11 Hasil kueri SQL tabel fakta tugas akhir

Lampiran 12 Hasil OLAP tabel fakta tugas akhir

31 Lampiran 14 Hasil OLAP tabel fakta prestasi

Lampiran 15 Hasil kueri SQL untuk kata kunci data warehouse

32

Lampiran 17 Hasil kueri SQL untuk kategori PKM

33

RIWAYAT HIDUP

Penulis dilahirkan di Serang pada tanggal 04 Februari 1992 dari Ayah Hasan Basri dan Ibu Sumaini. Penulis adalah putri ketiga dari tujuh bersaudara. Tahun 2009 penulis lulus dari SMA Negeri 4 Bandar Lampung dan pada tahun yang sama penulis diterima di Jurusan Manajemen Informatika Program Diploma Institut Pertanian Bogor (IPB) melalui jalur Undangan Seleksi Masuk IPB. Tahun 2012 penulis lulus dari Diploma IPB dan pada tahun yang sama penulis diterima di Program Alih Jenis S1 Ilmu Komputer IPB melalui tes seleksi masuk.

Selama mengikuti perkuliahan, penulis menjadi asisten dosen di Diploma IPB sebagai asisten mata kuliah Aplikasi Komputer, Basis Data, Rekayasa Perangkat Lunak, Pemrograman Berorientasi Objek dan Algoritma Pemrograman. Penulis bersama kolega juga aktif mengajarkan pelajaran dasar sepekan sekali untuk anak-anak tingkat Sekolah Dasar di Malabar, Bogor Tengah. Selain itu, penulis juga aktif dalam kegiatan-kegiatan sosial yang dinaungi oleh Yayasan Rubi Indonesia.