TINJAUAN PUSTAKA

Citra Digital

Secara umum citra merupakan gambar pada bidang dua dimensi. Ditinjau dari sudut pandang matematis, citra merupakan sebuah fungsi kontinu dari intensitas radiasi pada bidang dua dimensi. Sumber radiasi mengeluarkan radiasi yang kemudian mengenai objek, objek memantulkan kembali sebagian dari radiasi tersebut, pantulan radiasi ini ditangkap oleh sensor pada alat-alat optik seperti mata, kamera, pemindai (scanner) dan sebagainya. Akhirnya bayangan objek tersebut direkam dalam suatu media tertentu. Citra semacam ini disebut juga sebagai citra pantulan. Jika objek menghasilkan radiasi sendiri, maka citra yang tertangkap oleh sensor disebut sebagai citra emisi. Sedangkan jika objek bersifat transparan, sehingga citra yang dihasilkannya merupakan representasi dari radiasi yang berhasil diserap oleh partikel-partikel dari objek tersebut, maka citra tersebut adalah citra absorpsi. Untuk pembahasan selanjutnya pada seluruh bagian dari riset ini, yang disebut sebagai citra adalah citra pantulan yang ditangkap oleh sensor pada kamera.

Analisis terhadap sebuah citra dapat dilakukan dengan menggunakan bantuan komputer melalui sebuah sistem visual buatan yang biasa disebut dengan computer vision. Secara umum, tujuan dari sistem visual adalah untuk membuat model nyata dari sebuah citra. Untuk itu citra yang ditangkap oleh sensor yang masih dalam bentuk fungsi kontinu (analog) harus dirubah terlebih dahulu menjadi fungsi diskret (digital) yang dapat dibaca oleh komputer. Proses ini disebut sebagai digitasi, terdiri dari dua sub proses yaitu sampling dan kuantifikasi. Sampling merupakan proses untuk mengubah sebuah sinyal dalam ruang kontinu menjadi sinyal dalam ruang diskret, hasil dari proses ini adalah citra yang terdiri dari piksel-piksel yang tersusun dalam kolom dan baris. Setiap piksel merupakan hasil penggabungan dari beberapa sinyal yang saling berdekatan. Sekali sebuah citra mengalami proses sampling, tidak dimungkinkan untuk mengembalikannya kedalam bentuk kontinu. Setiap piksel biasanya akan memuat nilai intensitas yang pada awalnya mempunyai range kontinu, artinya sangat banyak kemungkinan nilai yang dapat dimuat oleh setiap piksel.

Sehubungan dengan keterbatasan kemampuan komputer untuk memproses pengkodean nilai-nilai tersebut, dibutuhkan sebuah metode untuk membatasinya. Kuantifikasi merupakan proses untuk mengubah range nilai intensitas yang semula kontinu menjadi range nilai yang diskret sedemikian sehingga dapat diakomodasi oleh sistem pengkodean biner pada komputer. Akhirnya, sebuah citra yang telah melalui proses digitasi disebut sebagai citra digital.

Representasi Citra Digital

Citra digital biasa direpresentasikan sebagai sebuah fungsi dua dimensi f(x,y), x dan y adalah koordinat spasial yang menunjukkan lokasi dari sebuah piksel didalam sebuah citra dan amplitudo dari f pada setiap pasangan koordinat (x,y) adalah intensitas dari citra pada piksel tersebut [Gonzales, 2004]. Untuk kebutuhan pengolahan dan analisis, representasi tersebut ditampilkan dalam bentuk matriks sebagai berikut :

…... (1)

Tipe-Tipe Citra Digital

Tiga tipe citra digital yang sering digunakan adalah citra intensitas, citra biner, dan citra RGB. Citra intensitas dan citra biner merupakan citra monokrom (lebih dikenal dengan citra hitam putih) sedangkan citra RGB merupakan citra berwarna.

a. Citra Intensitas, merupakan sebuah matriks dua dimensi berukuran mxn yang setiap selnya berisi nilai intensitas antara 0 sampai dengan 255. Intensitas 0 ditangkap sebagai warna hitam pekat, sedangkan intensitas 255 ditangkap sebagai warna putih terang oleh mata manusia. Nilai intensitas yang ada diantaranya merupakan gradasi dari warna hitam ke putih, atau lebih sering disebut warna keabuan (grayscale).

b. Citra biner, merupakan sebuh matriks dua dimensi berukuran mxn yang setiap selnya berisi kode 0 atau 1 yang merupakan representasi dari nilai logical "benar"

atau "salah", disebut juga tipe data boolean. Nilai 0 sering diasosiasikan dengan warna putih terang (setara dengan nilai 255 pada citra intensitas) sedangkan nilai 1 sering diasosiasikan dengan warna hitam (setara dengan nilai 0 pada citra intensitas). Namun bagaimanapun, asosiasi tersebut bisa berubah-ubah tergantung dari asumsi yang digunakan oleh pengguna. Tidak ada kesepakatan baku yang mengatur bagaimana nilai 0 dan 1 dihubungkan dengan warna hitam dan putih. Umumnya, citra biner terbentuk dari citra intensitas yang mengalami proses tresholding. Proses ini sangat sederhana, pertama-tama tetapkan sebuah nilai T yang terletak diantara range nilai intensitas. Ubah nilai intensitas dari setiap piksel dengan mengikuti aturan berikut:

…... (2)

c. Citra RGB (red, green, blue), merupakan kumpulan dari 3 buah matriks 2 dimensi yang masing-masing memuat nilai intensitas (0 s.d. 255) untuk warna merah, hijau dan biru. Sebuah piksel merupakan komposisi dari ketiga nilai intensitas tersebut (triplet). Jika digunakan sebagai input pada sistem monitor berwarna, triplet tersebut akan menghasilkan warna-warna yang unik.

Principal Components Analisys (PCA)

Ide utama dari principal component analysis (PCA) adalah mengurangi dimensionalitas dari set data yang mengandung banyak sekali variabel yang berinterelasi, dengan tetap mempertahankan sebanyak mungkin informasi (variansi data). Hal ini dicapai dengan mentransformasikan set data ke set variabel data yang baru, dinamakan principal component (PC). Principal Component satu dengan yang lain tidak saling berkorelasi dan diurutkan sedemikian rupa sehingga Principal Component yang pertama memuat paling banyak variasi dari data set. Sedangkan Principal Component yang kedua memuat variasi yang tidak dimiliki oleh Principal Component pertama. (Jolliffe IT, 2002)

Principal Components Analisys 1D (Turk and Pentland, 1991).

Secara matematis ide dasar dari PCA adalah melakukan sebuah transformasi

0, jika f(n)≥T 1, jika f(n)<T g(n) =

linear dari Rm ke Rn dimana n <<< m dengan memaksimumkan variansi data. Misalkan input vector adalah x ∈Rm dengan E[x]=0 (zero mean) dan

y

adalah vektor berdimensi n, maka transformasi linear dari Rm ke Rn dapat dinyatakan sebagai :

[

⋯a1T ⋯ ⋯a2T⋯ ⋮ ⋯anT⋯]

[

x1 x2 ⋮ xm]

=[

y1 y2 ⋮ yn]

…... (3) dengan : a1=[

a11 a12 ⋮ a1m]

, a2=[

a21 a22 ⋮ a2m]

… an=[

an1 an2 ⋮ anm]

Secara umum transformasi dapat dinyatakan sebagai :

yi=aiTx ; i = 1,2,...,n …... (4) sehingga :

var yi = var aiTx

var yi = E [( aiTx xTai var yi = aiT E xxTai

var yi = aiT

∑

ai …... (5) dimanaΣ

adalah matriks covarian.Selanjutnya harus ditentukan ai yang dapat membuat var yi menjadi maksimum dengan kondisi batas ∥a∥=1 atau aiTai=1 atau aiTai−1=0 karena ai adalah sebuah unit vektor. Salah satu teknik memecahkan permasalah optimisasi seperti ini adalah menggunakan teknik pengganda lagrange.

Penentuan ai dihitung sebagai berikut : Masalah optimisasi :

Maksimumkan : var yi = ai T

∑

ai Kendala : aiTai−1=0f ai = ai T

∑

ai - λ( ai T ai−1 ) ∂F ∂ai=0 = 2Σ

ai - 2 λ ai = 0Σ

ai=

λ ai …... (6)Dari persamaan 6 terlihat bahwa λ adalah nilai-nilai eigen dari matriks

Σ,

sedangai adalah vektor eigen yang bersesuaian dengan masing-masing λ. Jika ruas kiri dan kanan persamaan tersebut dikalikan dengan aiT maka akan diperoleh :

aiT

∑

ai=

aiT λ ai kerena aiTai=1 , maka :aiT

∑

ai=

λvar yi = λ …... (7) Dari persamaan (7) tersebut dapat dilihat bahwa nilai eigen dari matriks covarian

Σ

adalah var yi . Sehingga agar diperoleh varian maksimum maka ai adalah vetor-vektor eigen yang bersesuaian dengan nilai-nilai eigen terbesar dari matriksΣ.

Principal Components Analisys 2 Dimensi (Yang J. et al, 2004)

Pada teknik pengenalan wajah berbasis 1D PCA, citra wajah 2D akan dirubah terlebih dahulu menjadi vektor citra 1D. Akibatnya ruang vektor citra yang terbentuk akan memiliki dimensi sangat besar. Hal ini menyebabkan perhitungan matriks kovarian secara akurat serta perhitungan nilai eigen dan vektor eigen dari matriks kovarian tersebut menjadi relatif sulit. Berbeda dengan 1D PCA, pada 2D PCA citra wajah tetap direpresentasikan dengan matriks. Hal ini menyebabkan matriks kovarian yang terbentuk menjadi jauh lebih kecil. Dampak dari fakta tersebut, 2D PCA memiliki dua kelebihan dibandingkan dengan 1D PCA, yaitu :

1. Evaluasi terhadap matriks kovarian lebih akurat.

2. Waktu yang diperlukan untuk menghitung nilai eigen dan vektor eigen lebih cepat

Formulasi 2D PCA

Misalkan X adalah vektor kolom satuan berdimensi n. PCA 2D melakukan poreksi sebuah matriks acak dari citra A berukuran m x n kepada X dengan transformasi linear .

Y = A X

Sehingga akan diperoleh vektor Y berdimensi m, dinamakan vektor feature dari A. Permasalahannya adalah menetukan vektor X yang memaksimumkan total scatter dari proyeksi data. Secara matematis dapat dinyatakan sebagai :

J(X) = tr (Sx) …... (8)

dimana Sx menyatakan matriks kovarian dari vektor feature data-data training, dan

tr (Sx) adalah trace dari Sx. Selanjutnya matriks kovarian Sx dapat dinyatakan

sebagai :

Sx = E Y −EY Y −EY T=E [ AX −E AX ][ AX −E AX ]T

= E [ A−EA X ][ A− EA X ]T , sehingga :

tr Sx=XT[E [ A− EATA−EA]] X ... (9) Kemudian didefinisikan sebuah matriks

Gt=E [ A−EATA−EA] …... (10) Matriks Gt dinamakan matriks kovarian(scatter) citra yang berukuran n x n. Matriks ini dapat dihitung langsung dari M buah citra-citra training

Ajj=1,2,... , M Gt= 1 M

∑

j=1 M Aj−AT Aj− A …... (11) Maka kriteria pada persamaan (8) dapat dinyatakan sebagai :J X = XTGtX …...(12) Kolom vektor satuan X yang memaksimisasi J(X) disebut sumbu proyeksi yang optimal. Ini berarti total scatter (varians) dari data yang telah diproyeksikan pada X menjadi maksimum. Sumbu tersebut adalah vektor-vektor eigen dari matriks

Linear Support Vector Machine (SVM)

Konsep SVM dapat dijelaskan secara sederhana sebagai usaha mencari hyperplane terbaik yang berfungsi sebagai pemisah dua buah class pada input space. Gambar berikut memperlihatkan beberapa pattern yang merupakan anggota dari dua buah kelas : +1 dan –1. Pola yang tergabung pada class –1 disimbolkan dengan segitiga, sedangkan pola pada class +1, disimbolkan dengan lingkaran. Problem klasifikasi dapat diterjemahkan dengan usaha menemukan garis (hyperplane) yang memisahkan antara kedua kelompok tersebut.

Gambar 2 : Support vector, hyperplane dan margin

Hyperplane pemisah dapat dinyatakan dengan persamaan wTxb=0 dimana

w adalah vektor normal dari hyperplane dan b merupakan intercept hyperplane. Misalkan himpunan n buah data training adalah D={ x , y }, anggotanya adalah pasangan xi dan label kelasnya yi untuk i=1,2,...,n, dimana dalam SVM label kelas dinyatakan sebagai +1 dan -1. Selanjutnya linear classifier dapat dinyatakan sebagai

f xi=signwTxib …... (13)

Permasalahan selanjutnya adalah mencari set parameter w , b sehingga f xi=wTxib= yi untuk semua i. SVM berusaha mencari fungsi pemisah/hyperplane optimum diantara fungsi yang tidak terbatas jumlahnya yang memisahkan dua kelas objek. Optimal hyperplane kemudian ditentukan terhadap support vector dengan memaksimumkan margin (ρ). Support vectors adalah data training yang terletak paling dekat ke hyperplane. Data-data ini merupakan data yang paling sulit untuk diklasifikasikan. Hyperplane yang optimal diperoleh pada

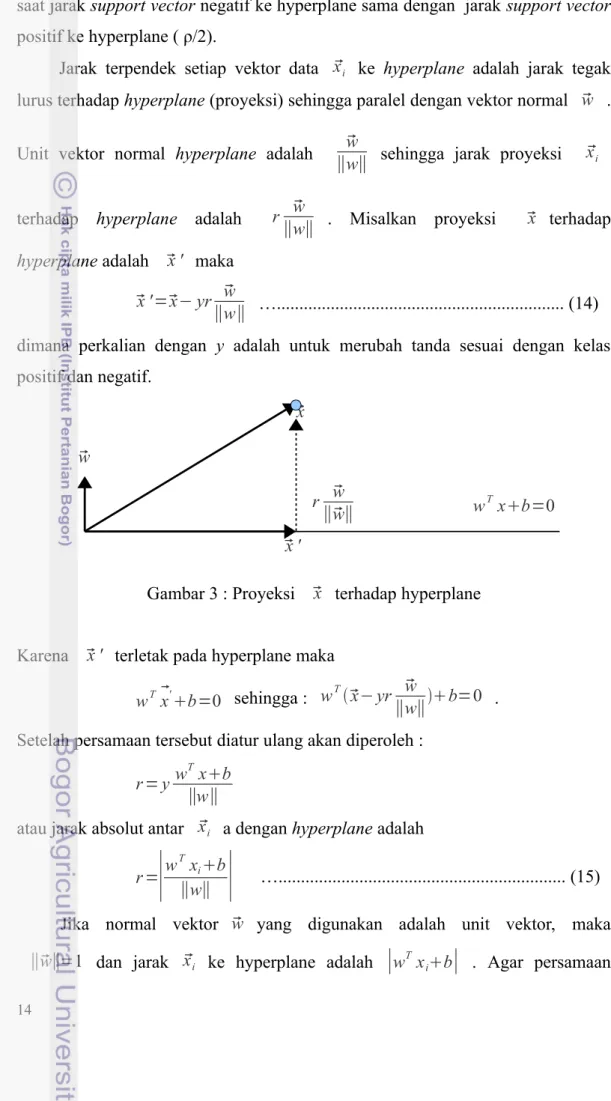

saat jarak support vector negatif ke hyperplane sama dengan jarak support vector positif ke hyperplane ( ρ/2).

Jarak terpendek setiap vektor data xi ke hyperplane adalah jarak tegak lurus terhadap hyperplane (proyeksi) sehingga paralel dengan vektor normal w .

Unit vektor normal hyperplane adalah w

∥w∥ sehingga jarak proyeksi xi terhadap hyperplane adalah r w

∥w∥ . Misalkan proyeksi x terhadap

hyperplane adalah x ' maka x '=x− yr w

∥w∥ …... (14)

dimana perkalian dengan y adalah untuk merubah tanda sesuai dengan kelas positif dan negatif.

Gambar 3 : Proyeksi x terhadap hyperplane

Karena x ' terletak pada hyperplane maka

wTx'b=0 sehingga : wTx− yr∥ww∥ b=0 .

Setelah persamaan tersebut diatur ulang akan diperoleh :

r = yw T

xb

∥w∥

atau jarak absolut antar xi a dengan hyperplane adalah r =

∣

wTx ib

∥w∥

∣

…... (15)Jika normal vektor w yang digunakan adalah unit vektor, maka

∥w∥=1 dan jarak xi ke hyperplane adalah

∣

wTxib∣

. Agar persamaanx x ' w r w ∥w∥ wTxb=0

menjadi unik, diambil

∣

wT xib∣

=1 untuk setiap support vector xi (vektor terdekat ke hyperplane). Sehingga jarak support vector xi terhadap hyperplaneadalah

∣

w Tx ib ∥w∥∣

= 1 ∥w∥ dan margin ρ = 2 ∥w∥ .Permasalahan kemudian menjadi bagaimana memilih w dan b agar

2

∥w∥ maksimum dengan kondisi batas :

∣

wT xib∣

≥1 jika xi kelas positif dan∣

wT xib∣

≤1 jika xi kelas negatif. Permasalah ini dapat dirubah menjadi formulasi standar SVM sebagai permasalahan minimisasi : Minimumkan fungsi : J w =1 2∥

w∥

2 Kondisi batas : gi w , b=1− yiwTxib untuk i = 1, 2 … nPermasalahan ini merupakan permasalahan optimisasi fungsi kuadrat dengan kendala linear. Karena J w adalah sebuah fungsi kuadrat, maka akan ada satu global minimum. Salah satu teknik pemecahannya adalah dengan metoda Pengganda Lagrange dan Teorema Karush-Kuhn-Tucker. (Smith, 2004), (Kecman, 2001). Dengan metoda tersebut permasalahan menjadi

maksimumkan : LDλ=

∑

i=1 n λi−12∑

i=1 n∑

j=1 n λiλjyiyjxi T xj …... (16) kendala : λi≥0 dan∑

i=1 n λiyi=0 …... (17) dimana λ = { λ1,... λn } adalah pengganda lagrange (variabel baru) untuk masing-masing data. Persamaan (16 ) dapat ditulis menggunakan notasi matriks :LDλ=

∑

i=1 n λi−1 2[

λ1 ⋮ λn]

T H[

λ⋮1 λn]

…... (18)dimana H merupakan matiks berukuran n x n, dengan nilai pada baris ke-i dan kolom ke-j dari matriks H adalah Hij=yiyjxi

T xj

Selanjutnya LDλ dapat dioptimasi menggunakan Quadratic Programming. Berdasarkan pada λ = { λ1,... λn } optimal yang diperoleh :

• jika λi=0 maka data ke-i adalah bukan support vector

• jika λi≠0 dan yiwT xib−1=0 maka data ke-i adalah support vector.

Kemudian w dihitung menggunakan persamaan

w=

∑

i=1 nλiyixi …... (19) b dapat dihitung menggunakan sembarang λi0 melalui persamaan

b= 1 yi−w

T

xi …... (20)

Persamaan hyperplane optimal yang diperoleh adalah :

f x=

∑

xi∈Sλiyixi

Txib …... (21) dimana S adalah himpunan support vector

S={ xi | λi≠0 }

Metoda Kernel

Jika suatu kasus klasifikasi memperlihatkan ketidaklinieran, algorithma linear SVM tidak bisa melakukan klasifikasi dengan baik. Metoda kernel adalah salah satu teknik untuk mengatasi hal ini. Dengan metoda kernel suatu data xi di input space dimapping ke feature space F dengan dimensi yang lebih tinggi melalui map φ sebagai berikut

φ : x → φ(x).

Karena itu data x di input space menjadi φ(x) di feature space.

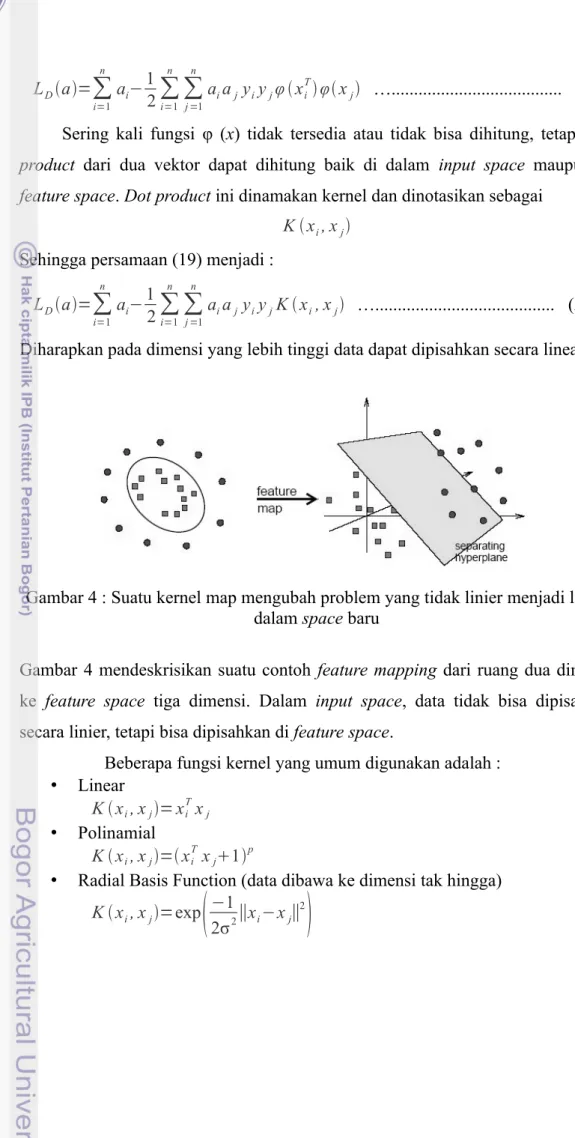

Dari persamaan (16) terlihat bahwa optimisai fungsi LDa hanya bergantung pada data xi melalui perkalian titik xiTxj . Jika xi dibawa ke dimensi yang lebih tinggi oleh φ(x) maka harus dihitung hasil kali titik pada dimensi yang lebih tinggi tersebut φ xiTφ xj . Fungsi yang akan dimaksimasi menjadi

LDa=

∑

i=1 n ai−1 2∑

i=1 n∑

j =1 n aiajyiyjφ xiTφ xj …... (22) Sering kali fungsi φ (x) tidak tersedia atau tidak bisa dihitung, tetapi dot product dari dua vektor dapat dihitung baik di dalam input space maupun di feature space. Dot product ini dinamakan kernel dan dinotasikan sebagaiK xi, xj Sehingga persamaan (19) menjadi :

LDa=

∑

i=1 n ai−1 2∑

i=1 n∑

j =1 n aiajyiyjK xi, xj …... (23) Diharapkan pada dimensi yang lebih tinggi data dapat dipisahkan secara linear.Gambar 4 : Suatu kernel map mengubah problem yang tidak linier menjadi linier dalam space baru

Gambar 4 mendeskrisikan suatu contoh feature mapping dari ruang dua dimensi ke feature space tiga dimensi. Dalam input space, data tidak bisa dipisahkan secara linier, tetapi bisa dipisahkan di feature space.

Beberapa fungsi kernel yang umum digunakan adalah : • Linear

K xi, xj=xiTxj • Polinamial

K xi, xj=xiTxj1p

• Radial Basis Function (data dibawa ke dimensi tak hingga)

K xi, xj=exp

−12σ2∥xi−xj∥

2