15

BAB 3

METODOLOGI PENELITIAN

Metodologi penelitian adalah langkah dan prosedur yang akan dilakukan dalam pengumpulan data atau informasi guna memecahkan permasalahan dan menguji hipotesis penelitian.

3.1. Pendahuluan

Pada Bab 3 didalam penelitian ini menjelaskan bagaimana metodologi yang digunakan untuk menyelesaikan masalah-masalah penelitian. Tujuan dari tesis ini adalah untuk membuat model aturan pola dan prediksi Indeks Harga Konsumen (IHK) menggunakan Jaringan Saraf Tiruan dengan metode Backpropagation sebagai pedoman pengambilan keputusan yang lebih baik dengan output berupa pola dan prediksi Indeks Harga Konsumen (IHK).

Langkah-langkah proses penelitian tertuang pada kerangka kerja penelitian yaitu : 1) Mengumpulkan Data

2) Studi Pustaka

3) Mengidentifikasi Masalah 4) Praproses

5) Menentukan Model

6) Menguji Hasil Pengolahan Data 7) Memprediksi

8) Mengevaluasi Akhir

3.2. Kerangka Kerja Penelitian

Pada Bab 3 ini akan diuraikan metodologi dan kerangka penelitian kerja yang digunakan dalam menyelesaikan masalah penelitian.

16

melaksanakan penelitian ini agar hasil yang dicapai tidak menyimpang dan tujuan yang diinginkan dapat terlaksana dengan baik dan sesuai dengan tujuan yang telah ditetapkan sebelumnya.

Gambar 3.1. Kerangka Kerja Penelitian

Berdasarkan kerangka kerja pada gambar diatas maka masing-masing langkah dapat diuraikan sebagai berikut :

1) Mengumpulkan Data

Pada tahap ini, data-data diperoleh dari Berita Resmi Statistik (BRS) yang rutin diterbitkan secara bulanan oleh Badan Pusat Statistik (BPS) Kota Pematangsiantar melalui https://siantarkota.bps.go.id/ serta dengan langsung datang ke kantor BPS yang bertempat di Jln. Porsea No. 5 Pematangsiantar. Dalam mengumpulkan data dilakukan observasi yaitu pengamatan secara langsung di tempat penelitian sehingga permasalahan yang ada dapat diketahui dengan jelas. Kemudian dilakukan interview yang bertujuan untuk mencapai

Mulai

Jurnal, Prosiding dan Buku Jaringan

Syaraf Tiruan Megumpulkan Data Studi Pustaka

Mengidentifakasi Masalah Praproses

Menentukan Pola

Menguji Hasil Pengolahan Data

Memprediksi

17

informasi atau data yang dibutuhkan. Selain itu juga dilakukan studi kepustakaan yaitu membaca jurnal dan buku-buku penunjang dalam melakukan analisa terhadap data dan informasi yang tepat.Dalam melakukan pengumpulan data ada beberapa cara yaitu;

a) Survey

Melakukan pengumpulan data dan observasi dengan meninjau langsung ke lapangan pada pihak-pihak yang terkait yang mempunyai wewenang dalam menyelesaikan penelitian ini.

b) Studi Literatur

Melakukan penelitian dan pembelajaran terhadap referensi-referensi yang berhubungan dengan penelitian seperti jurnal-jurnal yang berhubungan atau buku-buku tentang Jaringan Saraf Tiruan, atau melalui situs-situs di internet dalam menyelesaikan penelitian ini.

c) Wawancara

Melakukan tanya jawab dengan bagian yang menjadi objek penelitian sehingga nantinya dapat memberikan informasi yang akurat dan terpercaya.

2) Studi Pustaka

Untuk mencapai tujuan yang akan ditentukan, maka perlu dipelajari beberapa literatur-literatur yang digunakan. Studi pustaka merupakan langkah awal dalam penelitian ini, studi pustaka ini dilakukan untuk melengkapi pengetahuan dasar dan teori-teoriyang digunakan dalam penelitian ini.

3) Mengidentifikasi Masalah

Pada tahap identifikasi masalah ini, dilakukan setelah semua data-data terpenuhi kemudian didapatkan dataset yang sesuai untuk dilakukan proses pada tahap konversi data yang didapat sesuai dengan bobot yang ditentukan. 4) Praproses

18 5) Menentukan Model

Pada tahap ini akan dilakukan penentuan model Jaringan Saraf Tiruan dengan metode Backpropagation. Hasil dari tahap ini adalah beberapa model jaringan saraf tiruan dengan metode Backpropagation untuk menentukan pola.

6) Menguji Hasil Pengolahan Data

Seteleh proses penentuan model selesai, maka dilakukan tahapan uji coba terhadap hasil pengolahan data dengan menggunakan Software Matlab R2011b (7.13). Pengujian dilakukan melalui tahapan sebagai berikut:

a) Melakukan pengolahan data secara manual dengan metode Backpropagation.

b) Menguji hasil pengolahan data secara manual dengan metode Backpropagation dengan data yang sama pada langkah pertama.

c) Menguji hasil pengolahan data secara komputerisasi dengan metode Backpropagation dengan data yang sama pada langkah pertama dengan menggunakan software Matlab R2011b (7.13).

d) Membandingkan hasil manual dengan hasil pengujian dengan menggunakan software Matlab R2011b (7.13).

e) Menguji hasil pengolahan data secara komputerisasi dengan metode Backpropagation dengan menggunakan software Matlab R2011b (7.13) dengan data yang lebih lengkap dengan beberapa model Jaringan Saraf Tiruan

7) Memprediksi

Prediksi dilakukan untuk membandingkan jumlah dengan model Jaringan Saraf Tiruan dengan metode Backpropagation yang paling akurat.

8) Mengevaluasi Akhir

19

3.3. Teknik Proses Pelatihan Dan Pengujian

Proses pelatihan dan pengujian menggunakan metode Backpropagation dan Conjugate Gradient Fletcher Reeves dapat dilihat pada gambar 3.2.

Gambar 3.2. Proses Pelatihan dan Pengujian Menggunakan BP dan CGFR

Keterangan :

Pelatihan jaringan menggunakan kedua metode dimulai dengan proses normalisasi data train kemudian parameter awal masing-masing metode ditentukan. Jaringan dilatih hingga membentuk model classifier. Selanjutnya model tersebut diuji menggunakan data test yang telah dinormalisasi dan menghasilkan hasil pengujian yang dapat diketahui berdasarkan nilai akurasi dan MSE (Mean Squared Error) nya.

3.4. Tempat Penelitian

Penelitian ini dilaksanakan Badan Pusat Statistik (BPS) Jln. Porsea No.5, Teladan, Siantar Barat, Kota Pematangsiantar Sumatera Utara 21144.

3.5. Alat Dan Bahan

Alat dan Bahan yang digunakan dalam penelitian antara lain: 1) Komputer/Laptop untuk membantu dalam mengolah data.

2) Software Matlab R2011b (7.13) sebagai alat untuk memudahkan dalam pengolahan data.

20

3.6. Tahap Pemrosesan Data

Pada penelitian ini, dibuat sistem pengenalan pola dan prediksi Indeks Harga Konsumen (IHK). Proses ini memiliki 2 tahapan dimana tahapan pertama adalah melakukan pengenalan pola dengan cara menemukan arsitektur terbaik dari model Jaringan Saraf Tiruan yang dibuat. Proses pelatihan dan pengujian data untuk mendapatkan model terbaik didapat dari data Indeks Harga Konsumen (IHK) pada Badan Pusat Statistik (BPS) Kota Pematangsiantar sebanyak 24 Pola terhitung tahun 2014 sampai 2016, dengan kriteria Pola 1 sampai dengan Pola 12 adalah data pelatihan (training), sedangkan Pola 13 sampai dengan Pola 24 adalah data Uji. Tahap kedua adalah melakukan prediksi dengan pola arsitektur terbaik yang diperoleh di tahapan pertama.

3.7. Data Yang Digunakan

Data yang digunakan dalam penelitian ini adalah data Indeks Harga Konsumen (IHK) berdasarkan kelompok Bahan Makanan Kota Pematangsiantar dari tahun 2014 sampai dengan tahun 2016, dari mulai bulan Januari sampai dengan bulan Desember. Data Indeks Harga Konsumen (IHK) ini berasal dari Badan Pusat Statistik (BPS) Kota Pematangsiantar. Perhitungan Indeks Harga Konsumen (IHK) berdasarkan sektor bahan makanan diperoleh dari rata-rata sub kelompok bahan makanan tersebut. Pada Tabel 3.1. adalah contoh bagaimana perhitungan Indeks Harga Konsumen (IHK) bulan Agustus 2016 berdasarkan sektor bahan makanan.

Tabel 3.1. Indeks Harga Konsumen Bulan Agustus Tahun 2016 Sektor : Bahan Makanan

No Sub Kelompok Indeks

1 Padi-padian, Umbi-umbian dan Hasilnya 125,47

2 Daging dan Hasil-hasilnya 108,15

3 Ikan Segar 129,45

4 Ikan Diawetkan 132,55

5 Telur, Susu dan Hasil-hasilnya 126,18

21

Rata-rata indeks yang didapat dari 11 sub kelompok berdasarkan bahan makanan seperti yang diperlihatkan pada Tabel 3.1. akan digunakan sebagai data pelatihan dan juga data pengujian. Berikut ini adalah Tabel dari data Indeks Harga Konsumen (IHK) tersebut.

Tabel 3.2. Indeks Harga Konsumen Tahun 2014

Kelompok Pengeluaran

IHK Tahun 2014 Dalam Bulan

Januari Februari Maret April Mei Juni Juli Agustus September Oktober November Desember

Bahan Makanan 116,22 116,03 117,54 113,89 120,12 119,79 120,05 119,22 119,98 123,53 126,17 127,07

Sumber : Badan Pusat Statistik Pematangsiantar

Tabel 3.3. Indeks Harga Konsumen Tahun 2015

Kelompok Pengeluaran

IHK Tahun 2015 Dalam Bulan

Januari Februari Maret April Mei Juni Juli Agustus September Oktober November Desember

Bahan Makanan 125,95 119,6 118,37 117,91 122,16 127,04 125,53 124,15 122,17 122,85 123,72 128,4

Sumber : Badan Pusat Statistik Pematangsiantar

Tabel 3.4. Indeks Harga Konsumen Tahun 2016

Kelompok Pengeluaran

IHK Tahun 2016 Dalam Bulan

Januari Februari Maret April Mei Juni Juli Agustus September Oktober November Desember

Bahan Makanan 130,65 128,53 130,7 128,3 130,83 131,66 131,9 134,01 135,67 138 141.85 144,06

Sumber : Badan Pusat Statistik Pematangsiantar

Tabel 3.5. Data Input Yang Digunakan

INDEKS HARGA KONSUMEN TAHUN 2014-2016 Sektor : Bahan Makanan

Tahun Bulan

Januari Februari Maret April Mei Juni Juli Agustus September Oktober November Desember 2014 116,22 116,03 117,54 113,89 120,12 119,79 120,05 119,22 119,98 123,53 126,17 127,07

2015 125,95 119,60 118,37 117,91 122,16 127,04 125,53 124,15 122,17 122,85 123,72 128,40

2016 130,65 128,53 130,70 128,30 130,83 131,66 131,90 134,01 135,67 138,00 141.85 144,06

Sumber : Badan Pusat Statistik Pematangsiantar

22

Dari data input pada Tabel 3.5, dijelaskan bahwa dataset Indeks Harga Konsumen (IHK) berdasarkan sektor Bahan Makanan Tahun 2014-2015 digunakan sebagai data pelatihan (training), sedangkan dataset Indeks Harga Konsumen (IHK) berdasarkan sektor Bahan Makanan Tahun 2015-2016 digunakan sebagai data pengujian (testing). Data yang disajikan adalah data bulan Januari sampai dengan bulan Desember tiap tahunnya.

3.7.1. Arsitektur Jaringan

Pada penelitian ini data yang digunakan sebagai pelatihan adalah dataset tahun 2014 dengan target dataset tahun 2015. Kemudian dataset tahun 2015 yang telah menjadi target tadi, dijadikan menjadi data pelatihan dengan target dataset tahun 2016, dibagi menjadi 12 pola dengan sistem perputaran. Fungsi aktivasi yang digunakan adalah fungsi sigmoid dengan ukuran rentang nilai antara 0 dan 1.

Contoh arsitektur jaringan yang digunakan dapat dilihat pada Gambar 3.3. yang terdiri dari tiga lapisan, yaitu : 12 masukan (input), 12 neuron hidden layer dan 1 lapisan keluaran (output).

23

Pola arsitektur jaringan yang digunakan untuk prediksi Indeks Harga Konsumen (IHK) yaitu 12-N-1. Dimana 12 adalah node data input. Sedangkan jumlah hidden node N menggunakan aturan ‘rule of thumb’, serta 1 keluaran.

3.7.2. Proses Normalisasi

Sebelum diproses, data dinormalisasi terlebih dahulu. Normalisasi terhadap data dilakukan agar keluaran jaringan sesuai dengan fungsi aktivasi yang digunakan. Berdasarkan penjelasan pada Sub Bab 2.3.3 (Hal.7) mengenai fungsi aktivasi, maka Fungsi aktivasi yang peneliti gunakan dalam penelitian ini adalah fungsi aktivasi sigmoid biner dan fungsi aktivasi sigmoid bipolar.

Dalam backpropagation, fungsi aktivasi yang dipakai harus memenuhi beberapa syarat yaitu : kontinu, terdiferensial dengan mudah dan merupakan fungsi yang tidak turun. Salah satu fungsi yang memenuhi ketiga syarat tersebut sehingga sering dipakai adalah fungsi sigmoid biner yang memiliki range (0, 1) dan bipolar yang memiliki range (-1,1). Fungsi aktivasi sigmoid biner hampir sama dengan fungsi sigmoid bipolar, karena sering digunakan oleh para peneliti dalam proses prediksi (peramalan), tetapi fungsi sigmoid bipolar hanya cocok digunakan dalam prediksi (peramalan) yang menggunakan data yang tidak fluktuatif (Stabil) dan menggunakan range antara -1 sampai 1. Sedangkan fungsi sigmoid biner kebalikannya.

24

(3.1) Keterangan :

x’ : Data yang telah ditransformasi x : Data yang akan dinormalisasi a : Data minimum

b : Data maksimum

3.7.3. Pengolahan Data (Normalisasi)

Pengolahan data yang akan dilakukan adalah mengubah data Indeks Harga Konsumen (IHK) berdasarkan sektor bahan makanan yaitu dengan membuat suatu pola arsitektur terbaik menggunakan Jaringan Syaraf Tiruan dengan backpropogation. Berikut ini akan dijabarkan normalisasi data dalam proses prediksi berdasarkan tabel 3.5. pada pembahasan sebelumnya.

0.8( )

' x a 0.1

x

b a −

= +

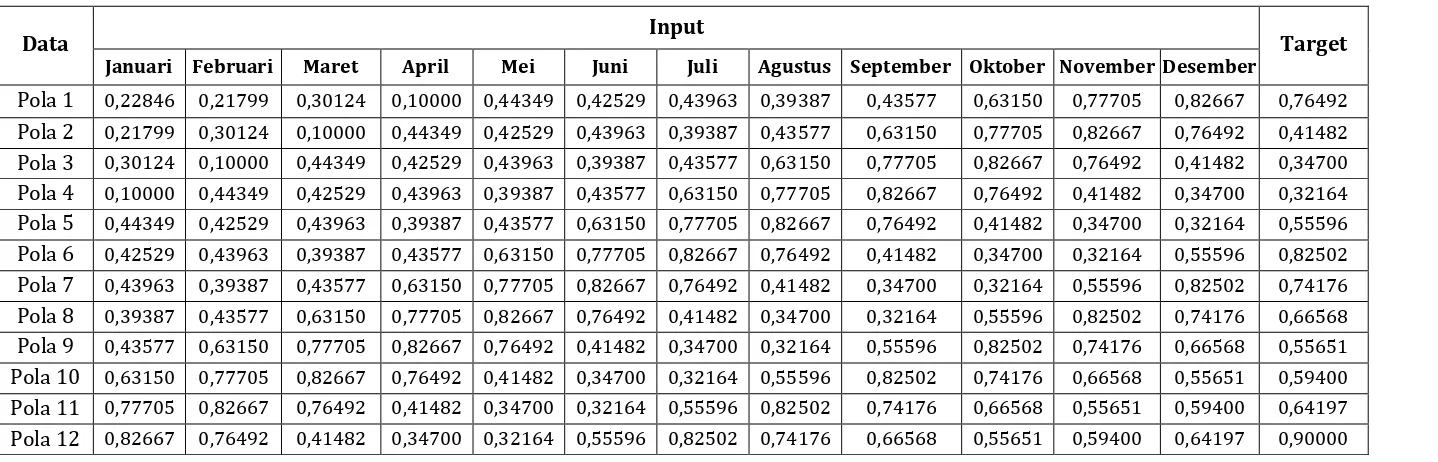

Tabel 3.6. Data Awal Pelatihan Tahun 2014-2015 Dengan Menggunakan Rotasi Putar

Data Data Input Target

Januari Februari Maret April Mei Juni Juli Agustus September Oktober November Desember

Pola 1 116,22 116,03 117,54 113,89 120,12 119,79 120,05 119,22 119,98 123,53 126,17 127,07 125,95

Pola 2 116,03 117,54 113,89 120,12 119,79 120,05 119,22 119,98 123,53 126,17 127,07 125,95 119,60

Pola 3 117,54 113,89 120,12 119,79 120,05 119,22 119,98 123,53 126,17 127,07 125,95 119,60 118,37

Pola 4 113,89 120,12 119,79 120,05 119,22 119,98 123,53 126,17 127,07 125,95 119,60 118,37 117,91

Pola 5 120,12 119,79 120,05 119,22 119,98 123,53 126,17 127,07 125,95 119,60 118,37 117,91 122,16

Pola 6 119,79 120,05 119,22 119,98 123,53 126,17 127,07 125,95 119,60 118,37 117,91 122,16 127,04

Pola 7 120,05 119,22 119,98 123,53 126,17 127,07 125,95 119,60 118,37 117,91 122,16 127,04 125,53

Pola 8 119,22 119,98 123,53 126,17 127,07 125,95 119,60 118,37 117,91 122,16 127,04 125,53 124,15

Pola 9 119,98 123,53 126,17 127,07 125,95 119,60 118,37 117,91 122,16 127,04 125,53 124,15 122,17

Pola 10 123,53 126,17 127,07 125,95 119,60 118,37 117,91 122,16 127,04 125,53 124,15 122,17 122,85

Pola 11 126,17 127,07 125,95 119,60 118,37 117,91 122,16 127,04 125,53 124,15 122,17 122,85 123,72

Pola 12 127,07 125,95 119,60 118,37 117,91 122,16 127,04 125,53 124,15 122,17 122,85 123,72 128,40

Penjelasan :

- Data Pelatihan Tahun 2014-2015 dilakukan dengan menggunakan rotasi putar, maksudnya setiap dataset memiliki hak yang sama untuk mencapai target.

- Nilai data pada pola 1 diambil dari IHK sektor bahan makanan tahun 2014. Sedangkan nilai Target diambil dari IHK sektor bahan makanan bulan Januari tahun 2015.

- Nilai data pada pola 2 diambil dari IHK sektor bahan makanan tahun 2014 bulan Februari s/d Desember serta dataset bulan Januari tahun 2015. Nilai Target pada pola 2 ini diambil dari IHK sektor bahan makanan bulan Februari tahun 2015.

- Nilai data pada pola 3 diambil dari IHK sektor bahan makanan tahun 2014 bulan Maret s/d Desember serta dataset bulan Januari s/d Februari tahun 2015. Nilai Target pada pola 3 ini diambil dari IHK sektor bahan makanan bulan Maret tahun 2015.

2

26 - Begitu seterusnya hingga seluruh nilai selesai di putar.

- Nilai maksimum (b) dari dataset adalah 128,40. Sedangkan nilai minimum (a) adalah 113,89. - Dengan menggunakan fungsi sigmoid biner maka akan di dapat data normalisasi sebagai berikut :

Maka akan didapatkan hasil Normalisasi pola 1 untuk bulan Januari 0,228846. Begitu seterusnya untuk semua data, di normalisasi dengan menggunakan fungsi yang sama.

Tabel 3.7. Hasil Normalisasi Data Pelatihan Tahun 2014-2015

Data Input Target

Januari Februari Maret April Mei Juni Juli Agustus September Oktober November Desember

Pola 1 0,22846 0,21799 0,30124 0,10000 0,44349 0,42529 0,43963 0,39387 0,43577 0,63150 0,77705 0,82667 0,76492

Pola 2 0,21799 0,30124 0,10000 0,44349 0,42529 0,43963 0,39387 0,43577 0,63150 0,77705 0,82667 0,76492 0,41482

Pola 3 0,30124 0,10000 0,44349 0,42529 0,43963 0,39387 0,43577 0,63150 0,77705 0,82667 0,76492 0,41482 0,34700

Pola 4 0,10000 0,44349 0,42529 0,43963 0,39387 0,43577 0,63150 0,77705 0,82667 0,76492 0,41482 0,34700 0,32164

Pola 5 0,44349 0,42529 0,43963 0,39387 0,43577 0,63150 0,77705 0,82667 0,76492 0,41482 0,34700 0,32164 0,55596

Pola 6 0,42529 0,43963 0,39387 0,43577 0,63150 0,77705 0,82667 0,76492 0,41482 0,34700 0,32164 0,55596 0,82502

Pola 7 0,43963 0,39387 0,43577 0,63150 0,77705 0,82667 0,76492 0,41482 0,34700 0,32164 0,55596 0,82502 0,74176

Pola 8 0,39387 0,43577 0,63150 0,77705 0,82667 0,76492 0,41482 0,34700 0,32164 0,55596 0,82502 0,74176 0,66568

Pola 9 0,43577 0,63150 0,77705 0,82667 0,76492 0,41482 0,34700 0,32164 0,55596 0,82502 0,74176 0,66568 0,55651

Pola 10 0,63150 0,77705 0,82667 0,76492 0,41482 0,34700 0,32164 0,55596 0,82502 0,74176 0,66568 0,55651 0,59400

Pola 11 0,77705 0,82667 0,76492 0,41482 0,34700 0,32164 0,55596 0,82502 0,74176 0,66568 0,55651 0,59400 0,64197

Pola 12 0,82667 0,76492 0,41482 0,34700 0,32164 0,55596 0,82502 0,74176 0,66568 0,55651 0,59400 0,64197 0,90000

Penjelasan :

- Nilai dataset pada tabel 3.7. adalah hasil normalisasi berdasarkan pada tabel 3.6. dengan menggunakan fungsi sigmoid biner.

2

27

Tabel 3.8. Data Awal Pengujian Tahun 2015-2016 Dengan Menggunakan Rotasi Putar

Data Input Target

Januari Februari Maret April Mei Juni Juli Agustus September Oktober November Desember

Pola 13 125,95 119,60 118,37 117,91 122,16 127,04 125,53 124,15 122,17 122,85 123,72 128,40 130,65

Pola 14 119,60 118,37 117,91 122,16 127,04 125,53 124,15 122,17 122,85 123,72 128,40 130,65 128,53

Pola 15 118,37 117,91 122,16 127,04 125,53 124,15 122,17 122,85 123,72 128,40 130,65 128,53 130,70

Pola 16 117,91 122,16 127,04 125,53 124,15 122,17 122,85 123,72 128,40 130,65 128,53 130,70 128,30

Pola 17 122,16 127,04 125,53 124,15 122,17 122,85 123,72 128,40 130,65 128,53 130,70 128,30 130,83

Pola 18 127,04 125,53 124,15 122,17 122,85 123,72 128,40 130,65 128,53 130,70 128,30 130,83 131,66

Pola 19 125,53 124,15 122,17 122,85 123,72 128,40 130,65 128,53 130,70 128,30 130,83 131,66 131,90

Pola 20 124,15 122,17 122,85 123,72 128,40 130,65 128,53 130,70 128,30 130,83 131,66 131,90 134,01

Pola 21 122,17 122,85 123,72 128,40 130,65 128,53 130,70 128,30 130,83 131,66 131,90 134,01 135,67

Pola 22 122,85 123,72 128,40 130,65 128,53 130,70 128,30 130,83 131,66 131,90 134,01 135,67 138,00

Pola 23 123,72 128,40 130,65 128,53 130,70 128,30 130,83 131,66 131,90 134,01 135,67 138,00 141,85

Pola 24 128,40 130,65 128,53 130,70 128,30 130,83 131,66 131,90 134,01 135,67 138,00 141,85 144,06

Penjelasan :

- Data Pengujian Tahun 2015-2016 dilakukan dengan menggunakan rotasi putar, maksudnya setiap dataset memiliki hak yang sama untuk mencapai target.

- Nilai data pada pola 13 diambil dari IHK sektor bahan makanan tahun 2015. Sedangkan nilai Target diambil dari IHK sektor bahan makanan bulan Januari tahun 2016.

- Nilai data pada pola 14 diambil dari IHK sektor bahan makanan tahun 2015 bulan Februari s/d Desember serta dataset bulan Januari tahun 2016. Nilai Target pada pola 2 ini diambil dari IHK sektor bahan makanan bulan Februari tahun 2016.

- Nilai data pada pola 15 diambil dari IHK sektor bahan makanan tahun 2015 bulan Maret s/d Desember serta dataset bulan Januari s/d Februari tahun 2016. Nilai Target pada pola 3 ini diambil dari IHK sektor bahan makanan bulan Maret tahun 2016.

2

28 - Begitu seterusnya hingga seluruh nilai selesai di putar.

- Nilai maksimum (b) dari dataset adalah 144,06. Sedangkan nilai minimum (a) adalah 117,91. - Dengan menggunakan fungsi sigmoid biner maka akan di dapat data normalisasi sebagai berikut :

Maka akan didapatkan hasil Normalisasi pola 13 untuk bulan Januari 0,34597. Begitu seterusnya untuk semua data, di normalisasi dengan menggunakan fungsi yang sama.

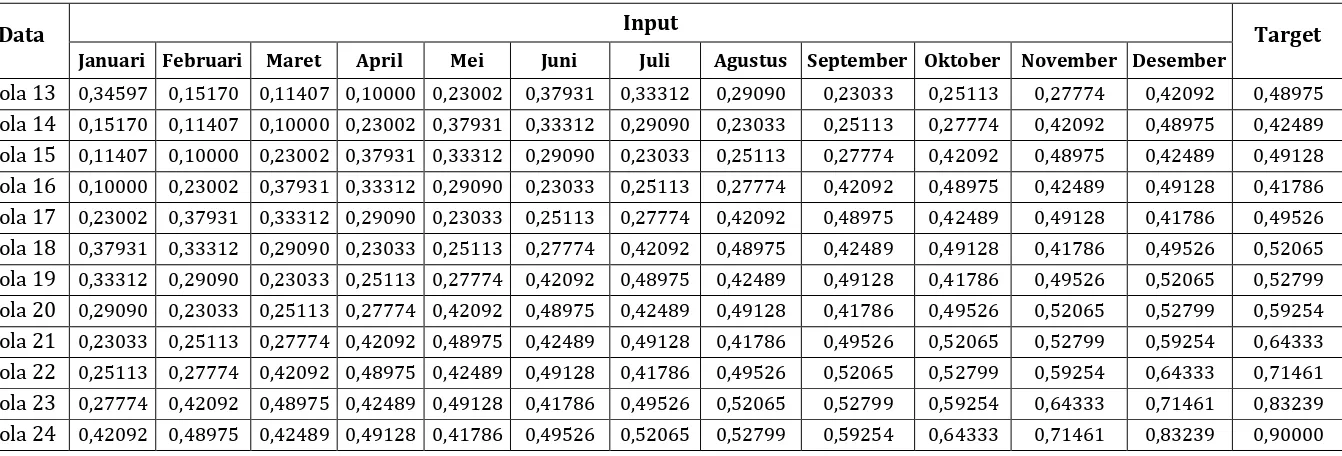

Tabel 3.9. Hasil Normalisasi Data Pengujian Tahun 2015-2016

Data Input Target

Januari Februari Maret April Mei Juni Juli Agustus September Oktober November Desember

Pola 13 0,34597 0,15170 0,11407 0,10000 0,23002 0,37931 0,33312 0,29090 0,23033 0,25113 0,27774 0,42092 0,48975

Pola 14 0,15170 0,11407 0,10000 0,23002 0,37931 0,33312 0,29090 0,23033 0,25113 0,27774 0,42092 0,48975 0,42489

Pola 15 0,11407 0,10000 0,23002 0,37931 0,33312 0,29090 0,23033 0,25113 0,27774 0,42092 0,48975 0,42489 0,49128

Pola 16 0,10000 0,23002 0,37931 0,33312 0,29090 0,23033 0,25113 0,27774 0,42092 0,48975 0,42489 0,49128 0,41786

Pola 17 0,23002 0,37931 0,33312 0,29090 0,23033 0,25113 0,27774 0,42092 0,48975 0,42489 0,49128 0,41786 0,49526

Pola 18 0,37931 0,33312 0,29090 0,23033 0,25113 0,27774 0,42092 0,48975 0,42489 0,49128 0,41786 0,49526 0,52065

Pola 19 0,33312 0,29090 0,23033 0,25113 0,27774 0,42092 0,48975 0,42489 0,49128 0,41786 0,49526 0,52065 0,52799

Pola 20 0,29090 0,23033 0,25113 0,27774 0,42092 0,48975 0,42489 0,49128 0,41786 0,49526 0,52065 0,52799 0,59254

Pola 21 0,23033 0,25113 0,27774 0,42092 0,48975 0,42489 0,49128 0,41786 0,49526 0,52065 0,52799 0,59254 0,64333

Pola 22 0,25113 0,27774 0,42092 0,48975 0,42489 0,49128 0,41786 0,49526 0,52065 0,52799 0,59254 0,64333 0,71461

Pola 23 0,27774 0,42092 0,48975 0,42489 0,49128 0,41786 0,49526 0,52065 0,52799 0,59254 0,64333 0,71461 0,83239

Pola 24 0,42092 0,48975 0,42489 0,49128 0,41786 0,49526 0,52065 0,52799 0,59254 0,64333 0,71461 0,83239 0,90000

Penjelasan :

- Nilai dataset pada tabel 3.9. adalah hasil normalisasi berdasarkan pada tabel 3.8. dengan menggunakan fungsi sigmoid biner.

2

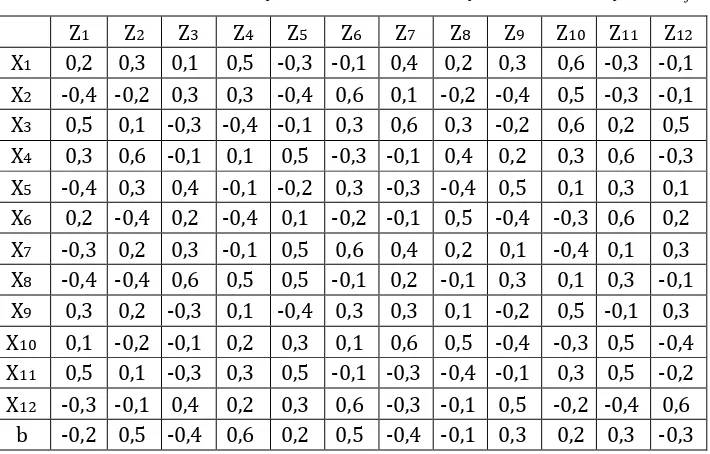

Langkah 0

Inisialisasi semua bobot dengan bilangan acak kecil.

Table 3.10. Bobot Dari Layar Masukan Ke Layar Tersembunyi = Vji

Jika kondisi penghentian belum terpenuhi, lakukan langkah 2 sampai dengan 9

Langkah 2

Untuk setiap pasang data pelatihan, lakukan langkah 3 sampai dengan 8 Fase I: Propagasi Maju

Tiap unit masukkan menerima sinyal dan meneruskannya ke unit tersembunyi

Langkah 4

Hitung semua keluaran di unit tersembunyi Zj (j = 1, 2, ... , p) :

= -0,2 + (0,2*0,2) + (0,5*-0,4) + 0,4*0,5) + (0,1*0,3) + (0,3*-0,4) + (-0,2*0,2) +

(-0,4*-0,3) + (-0,1*-0,4) + (0,5*0,3) + (0,3*0,1) + (0,6*0,5) + (-0,3*-0,3) = 0,04

= 0,5 + (0,2*0,3) + (0,5*-0,2) + ... + (-0,3*-0,1) = 0,74

= -0,4 + (0,2*0,1) + (0,5*0,3) + ... + (-0,3*0,4) = 0,70

= 0,6 + (0,2*0,5) + (0,5*0,3) + ... + (-0,3*0,2) = 1,29

= 0,2 + (0,2*0,3) + (0,5*0,4) + ... + (-0,3*0,3) = 0,20

= 0,47

= -0,4 + (0,2*0,4) + (0,5*0,1) + ... + (-0,3*-0,3) = -0,53

= -0,1 + (0,2*0,2) + (0,5*-0,2) + ... + (-0,3*-0,1) = -0,54

= 0,3 + (0,2*0,3) + (0,5*-0,4) + ... + (-0,3*0,5) = -0,01

= 0,2 + (0,2*0,6) + (0,5*0,5) + ... + (-0,3*-0,2) = 1,00

= 0,3 + (0,2*-0,3) + (0,5*-0,3) + ... + (-0,3*-0,4) = 0,49

= -0,3 + (0,2*-0,1) + (0,5*-0,1) + ... + (-0,3*0,6)

Langkah 5

Hitung semua jaringan di unit keluaran (Yk)

= 0,3 + (0,51*0,5) + (0,68*0,2) + (0,33*0,3) + (0,78*-0,4) + (0,45*-0,1) + (0,62*0,1)

+ (0,37*-0,2) + (0,37*-0,4) + (0,50*0,6) * (0,73*-0,3) + (0,62*0,4) + (0,27*-0,2)

= 0,54

Fase II : Propagasi Mundur

δk = (tk-Yk) f’’ (Ynetk) = (tk-Yk) Yk(1-Yk) = (0-0,54) * 0,54 * (1-0,54) = -0,14

δk merupakan unit kesalahan yang akan dipakai dalam perubahan bobot layer dibawahnya (langkah 7).

Suku perubahan bobot Wkj (dengan α = 0,2)

∆Wkj= αδk zj

∆W10= αδ0 (1) = 0,2 . (-0,14). (1) = -0,03

∆W11= αδ1 (z1) = 0,2 . (-0,14) . (0,51) = -0,01

∆W12= αδ2 (z2) = 0,2 . (-0,14) . (0,68) = -0,02

∆W13= αδ3 (z3) = 0,2 . (-0,14) . (0,33) = -0,01

∆W14= αδ4 (z3) = 0,2 . (-0,14) . (0,78) = -0,02

∆W15= αδ5 (z3) = 0,2 . (-0,14) . (0,45) = -0,01

∆W16= αδ6 (z3) = 0,2 . (-0,14) . (0,62) = -0,02

∆W17= αδ7 (z3) = 0,2 . (-0,14) . (0,37) = -0,01

∆W18= αδ8 (z3) = 0,2 . (-0,14) . (0,37) = -0,01

∆W19= αδ9 (z3) = 0,2 . (-0,14) . (0,50) = -0,01

∆W20= αδ10 (z3) = 0,2 . (-0,14) . (0,73) = -0,02

∆W21= αδ11 (z3) = 0,2 . (-0,14) . (0,62) = -0,02

∆W22= αδ12 (z3) = 0,2 . (-0,14) . (0,27) = -0,01

Langkah 7

Hitung penjumlahan kesalahan dari unit tersembunyi ( = δ )

Karena jaringan hanya memiliki sebuah unit keluaran maka δnetj = δ Wij δnet1 = δk.W11 = (-0,14) . (-0,01) = 0,0014

δnet10 = δk.W20 = (-0,14) . (-0,02) = 0,0028 δnet11 = δk.W21 = (-0,14) . (-0,02) = 0,0028 δnet12 = δk.W22 = (-0,14) . (-0,01) = 0,0014 Faktor kesalahan di unit tersembunyi : δj = δnetj f’(Znetj) = δnet Zj (1-Zj)

Tabel 3.12. Suku Perubahan Bobot Ke Unit Tersembunyi

Langkah 8

Hitung semua perubahan bobot. Perubahan bobot unit keluaran : Wkj (baru) = Wkj (lama) + ∆Wkj

Tabel 3.13. Perubahan Bobot Unit Keluaran

Y Wkj (lama) Wkj (baru)

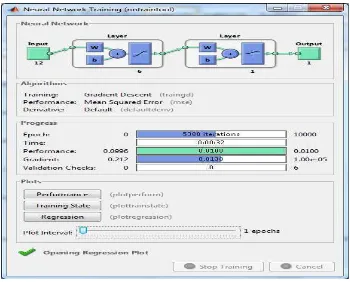

lamanya waktu iterasi (Epoch). Tujuan utama dari langkah ini adalah untuk memperoleh tingkat akurasi laju pembelajaran yang optimal. Dengan memakai arsitektur jaringan terbaik pada pelatihan, maka akan diamati laju pembelajaran terhadap kinerja jaringan. Arsitektur yang digunakan untuk pelatihan sebanyak 5 pola. Ke 5 pola arsitektur ini menggunakan Learning rate 0,1, target error (goal) 0,01 dan maksimum epoch nya adalah 10000 iterasi serta untuk menghasilkan error paling rendah menggunakan traingd.

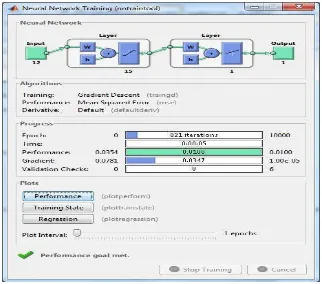

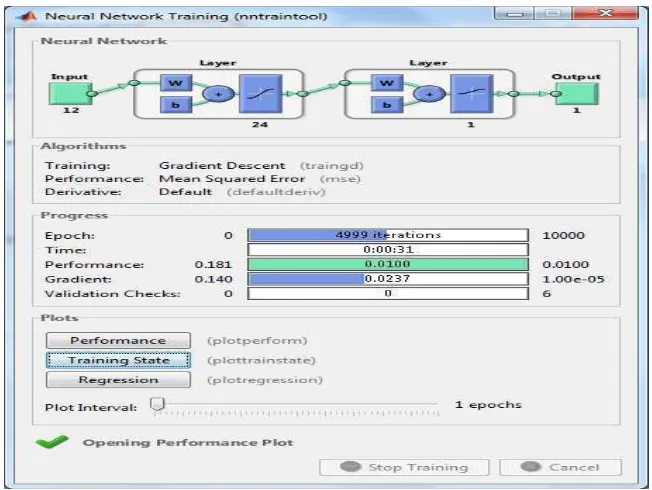

Pada arsitektur pelatihan 1 menggunakan layer masukan sebanyak 12 neuron, layer tersembunyi sebanyak 6 neuron dan layer keluaran 1 neuron. Pada pelatihan 1 ini menghasilkan pelatihan dengan epoch sebesar 5308 iterasi, waktu 00.32, MSE 0,009999 dan tingkat akurasi 58%. Pada arsitektur pelatihan 2 menggunakan layer masukan sebanyak 12 neuron, layer tersembunyi sebanyak 15 neuron dan layer keluaran 1 neuron. Pada pelatihan 2 ini menghasilkan pelatihan dengan epoch sebesar 821 iterasi, waktu 00.05, MSE 0,009982 dan tingkat akurasi 67%. Pada arsitektur pelatihan 3 menggunakan layer masukan sebanyak 12 neuron, layer tersembunyi sebanyak 24 neuron dan layer keluaran 1 neuron. Pada pelatihan 3 ini menghasilkan pelatihan dengan epoch sebesar 4999 iterasi, waktu 00.31, MSE 0,009996 dan tingkat akurasi 67%. Pada arsitektur pelatihan 4 menggunakan layer masukan sebanyak 12 neuron, layer tersembunyi sebanyak 33 neuron dan layer keluaran 1 neuron. Pada pelatihan 4 ini menghasilkan pelatihan dengan epoch sebesar 961 iterasi, waktu 00.06, MSE 0,009975 dan tingkat akurasi 67%. Pada arsitektur pelatihan 5 menggunakan layer masukan sebanyak 12 neuron, layer tersembunyi sebanyak 34 neuron dan layer keluaran 1 neuron. Pada pelatihan 5 ini menghasilkan pelatihan dengan epoch sebesar 1491 iterasi, waktu 00.09, MSE 0,009996 dan tingkat akurasi 67%.

3.7.5. Proses Testing (Pengujian)

pelatihan 2 sebesar 0,0142803. MSE pada pengujian pelatihan 3 sebesar 0,020554. MSE pada pengujian pelatihan 4 sebesar 0,036615 dan MSE pada pengujian pelatihan 5 sebesar 0,017577. Adapun rumus yang digunakan untuk menetapkan pengujian dengan parameter pada tiap pelatihan, dapat dijabarkan sebagai berikut :

a) Rumus menetapkan pengujian dengan parameter pada pelatihan 1 1. >> net=newff(minmax(P),[6,1],{'tansig','logsig'},'traingd');

b) Rumus menetapkan pengujian dengan parameter pada pelatihan 2 1. >> net=newff(minmax(P),[15,1],{'tansig','logsig'},'traingd');

c) Rumus menetapkan pengujian dengan parameter pada pelatihan 3 1. >> net=newff(minmax(P),[24,1],{'tansig','logsig'},'traingd');

2. >>net.trainParam.epochs=10000; 3. >>net.trainParam.goal = 0,01; 4. >>net.trainParam.Lr = 0,01; 5. >>net.trainParam.show = 1000; 6. >>net=train(net,P,T)

7. >>a=sim(net,P);

8. >>[a,Pf,Af,e,Perf]=sim(net,P,[],[],T)

e) Rumus menetapkan pengujian dengan parameter pada pelatihan 5 1. >> net=newff(minmax(P),[34,1],{'tansig','logsig'},'traingd'); 2. >>net.trainParam.epochs=10000;

3. >>net.trainParam.goal = 0,01; 4. >>net.trainParam.Lr = 0,1; 5. >>net.trainParam.show = 1000; 6. >>net=train(net,P,T)

7. >>a=sim(net,P);

BAB 4

ANALISIS DAN HASIL PENELITIAN

4.1. Pendahuluan

Langkah pertama yang harus dilakukan untuk memprogram backpropagation dengan software Matlab adalah membuat inisialisasi jaringan. Sebelum pelatihan dilakukan, terlebih dahulu ditentukan nilai parameter yang diinginkan guna memperoleh hasil yang optimal. Untuk memberikan nilai parameter dalam software Matlab adalah sebagai berikut :

a) >> net = newff(PR,[S1 S2 ... SN],{TF1 TF2 … TFN},BTF,BLF,PF) Perintah ini digunakan untuk membentuk jaringan pada backpropagation. Keterangan :

net = Jaringan backpropagation yang terdiri dari n layer

PR = Matriks ordo R x 2 yang berisi nilai minimum dan maksimum R buah elemen masukannya.

Si = Fungsi aktivasi yang dipakai pada layar ke-i (i=1,2,...,n). BTF = Fungsi pelatihan jaringan. Defaultnya = traingdx

BLF = Fungsi perubahan bobot/bias. Default=learngdm PF = Fungsi perhitungan error (Mean Square Error MSE) b) >> net.IW{1,1};

Perintah ini digunakan untuk melihat nilai bobot awal pada lapisan masukan dan lapisan tersembunyi (bilangan diambil secara acak dari kmputer).

c) >> net.b{1};

Perintah ini digunakan untuk melihat nilai bias awal pada lapisan tersembunyi (bilangan diambil secara acak dari kmputer)

d) >> net.LW{2,1};

Perintah ini digunakan untuk melihat nilai bobot awal pada lapisan tersembunyi dan lapisan keluaran (bilangan diambil secara acak dari komputer).

e) >> net.b{2};

f) >> net.LW{3,2};

Perintah ini digunakan untuk melihat nilai bobot awal pada lapisan tersembunyi pertama dan lapisan tersembunyi kedua.

g) >> net.b{3};

Perintah ini digunakan untuk melihat nilai bias bias pada lapisan tersembunyi kedua (bilangan diambil secara acak dari komputer).

h) >>a=sim(net,p);

Proses ini merupakan tahapan simulasi data, dimana pada proses ini akan memunculkan hasil pelatihan berupa nilai error dan grafik pelatihan.

i) >>[a,Pf,Af,e,Perf]=sim(net,p,[],[],t)

Proses ini digunakan untuk melihat hasil yang dikeluarkan oleh jaringan j) >> Net.trainParam.Show

Perintah yang digunakan untuk menampilkan frekuensi perubahan MSE. k) >> Net.trainParam.epochs

Perintah yang dipakai untuk menentukan jumlah epochs maksimum pelatihan. l) >> Net.trainParam.goal

Perintah untuk menentukan batas MSE agar iterasi dihentikan. Iterasi akan berhenti jika MSE < dari batas yang ditentukan atau jumlah epoch telah mencapai maksimum sesuai nilai yang diberikan pada perintah net.trainParam.epochs.

m) >> Net.trainParam.Lr

Perintah yang digunakan untuk menentukan laju pembelajaran (learning rate). Default-nya adalah 0,01. Semakin besar nilai laju pembelajaran, semakin cepat pula proses pelatihan. Akan tetapi jika nilainya terlalu besar, algoritma menjadi tidak stabil dan mencapai titik minimum lokal.

n) >> Net.trainParam.time

Perintah untuk membatasi lama pelatihan (dalam detik). Pelatihan dihentikan jika lamanya melebihi nilai yang ditentukan.

o) >> Net.trainParam.mc

Perintah ini digunakan untuk menentukan nilai momentum antara 0 – 1

Tabel 4.1. Arsitektur JST Backpropagation Standar

Sebelumnya data yang akan diujikan haruslah dibagi menjadi dua (2) bagian, di mana bagian pertama adalah untuk data pelatihan dan bagian kedua adalah untuk data pengujian. Parameter-parameter yang digunakan dalam pelatihan dan pengujian ini adalah :

a. Learning Rate : Lr = 0,01

b. Lapisan tersembunyi : n = 6; n = 15; n = 24; n = 33; n= 34 c. Target Error = 0,01

Jaringan Saraf Tiruan dengan algoritma backpropagation yang sudah dilatih dan diuji dengan baik akan memberikan keluaran yang baik pula jika diberi masukan yang serupa dengan pola yang dipakai untuk pelatihan dan pengujian. Sifat generalisasi ini membuat pelatihan dan pengujian lebih efisien karena tidak perlu dilakukan pada semua data. Jaringan Syaraf Tiruan dengan algoritma backpropagation dibentuk dengan membuat generalisasi aturan pelatihan dan pengujian dalam model Windrow-Hooff dengan cara menambahkan lapisan tersembunyi (hidden layer). Standar Metode backpropagation menggunakan algoritma penurunan gradien (gradien descent). Variasi terhadap model standar dilakukan dengan mengganti algoritmanya dengan algoritma lain.

4.3. Hasil Penelitian

4.3.1. Pelatihan Dan Pengujian Data Dengan Arsitektur 12-6-1

12 Neuron, layer tersembunyi 6 neuron serta 1 neuron layer keluaran. Rumus pelatihan backpropagation yang digunakan dengan aplikasi Matlab sebagai berikut : >> net=newff(minmax(P),[6,1],{'tansig','logsig'},'traingd');

>> net.IW{1,1}; >> net.b{1}; >> net.LW{2,1}; >> net.b{2};

>> net.trainParam.epochs=10000; net.trainParam.goal = 0.01;

net.trainParam.Lr = 0.01; net.trainParam.show = 1000; net=train(net,P,T)

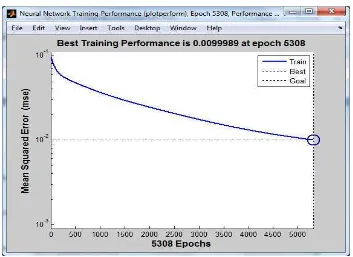

Pelatihan dan pengujian Jaringan Syaraf Tiruan dengan arsitektur 12–6–1 dapat dilihat pada gambar 4.1 dan 4.2.

Gambar 4.2. Performance Pelatihan Menggunakan Arsitektur 12-6-1

Tabel 4.2. Akurasi Data Pelatihan Arsitektur 12-6-1

Bulan Pola Target Output Error SSE Hasil 1 Pola 1 0,76492 0,56840 0,19652 0,0386204029 Salah

2 Pola 2 0,41482 0,55370 -0,13888 0,0192883857 Salah

3 Pola 3 0,34700 0,38260 -0,03560 0,0012672128 Benar

4 Pola 4 0,32164 0,45200 -0,13036 0,0169936649 Salah

5 Pola 5 0,55596 0,60800 -0,05204 0,0027080153 Benar

6 Pola 6 0,82502 0,80470 0,02032 0,0004127898 Benar

7 Pola 7 0,74176 0,84670 -0,10494 0,0110115010 Salah

8 Pola 8 0,66568 0,73310 -0,06742 0,0045456125 Benar

9 Pola 9 0,55651 0,49940 0,05711 0,0032618662 Benar

10 Pola 10 0,59400 0,54990 0,04410 0,0019451747 Benar

11 Pola 11 0,64197 0,64240 -0,00043 0,0000001840 Benar

12 Pola 12 0,90000 0,75880 0,14120 0,0199374400 Salah Jumlah SSE 0,1199922499

58%

MSE 0,0099993542

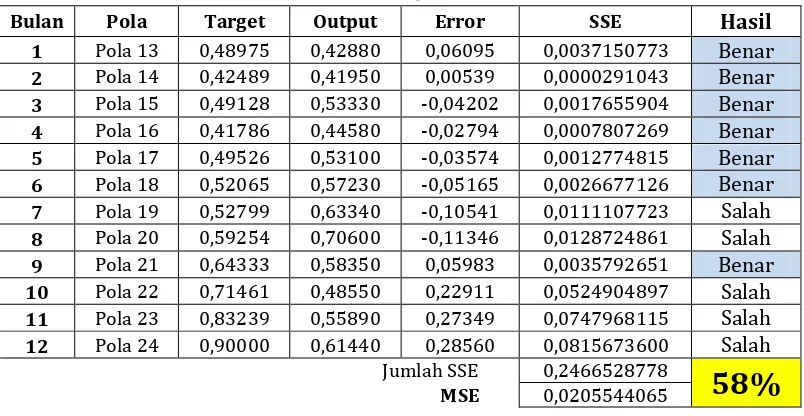

Tabel 4.3. Akurasi Data Pengujian Arsitektur 12-6-1

Pola 13 s/d 24 adalah pola yang dipakai dalam data pengujian. Nilai Target diperoleh dari tabel data pengujian. Nilai Output diperoleh dari rumus >> [a,Pf,Af,e,Perf]=sim(net,P,[],[],T) yang dimasukkan pada aplikasi Matlab dari input dan target data pengujian. Nilai Error diperoleh dari : Target-Output. SSE diperoleh dari : Error ^ 2. Jumlah SSE adalah total dari keseluruhan SSE. MSE diperoleh dari : Jumlah SSE / 12 (jumlah data). Hasil bernilai Benar apabila nilai SSE <= 0,01. 0,01 adalah target error dari pengujian backpropagation. Akurasi (%) diperoleh dari : Jumlah Benar / 12 * 100.

Keterangan :

Dari arsitektur 12-6-1 diatas dapat diketahui bahwa epoch yang terjadi sebanyak 5308 iterasi, dengan tingkat akurasi pelatihan sebesar 58% dan akurasi Pengujian sebesar 50%.

4.3.2. Pelatihan Dan Pengujian Data Dengan Arsitektur 12-15-1

Pelatihan dan pengujian data dengan backpropagation pada tahap kedua ini menggunakan arsitektur jaringan 12-15-1. Maksudnya, layer masukkan menggunakan 12 Neuron, layer tersembunyi 15 neuron serta 1 neuron layer keluaran. Rumus pelatihan backpropagation yang digunakan dengan aplikasi Matlab sebagai berikut : >> net=newff(minmax(P),[15,1],{'tansig','logsig'},'traingd');

>> net.trainParam.epochs=10000; net.trainParam.goal = 0.01;

net.trainParam.Lr = 0.01; net.trainParam.show = 1000; net=train(net,P,T)

Pelatihan dan pengujian Jaringan Syaraf Tiruan dengan arsitektur 12–15–1 dapat dilihat pada gambar 4.3 dan 4.4.

Gambar 4.3. Pelatihan Menggunakan Arsitektur 12-15-1

Tabel 4.4. Akurasi Data Pelatihan Arsitektur 12-15-1

Tabel 4.5. Akurasi Data Pengujian Arsitektur 12-15-1

Bulan Pola Target Output Error SSE Hasil

Dari arsitektur 12-15-1 diatas dapat diketahui bahwa epoch yang terjadi sebanyak 821 iterasi, dengan tingkat akurasi pelatihan sebesar 67% dan akurasi Pengujian sebesar 75%. Arsitektur inilah merupakan arsitektur yang terbaik dalam penelitian ini.

4.3.3. Pelatihan Dan Pengujian Data Dengan Arsitektur 12-24-1

Pelatihan dan pengujian data dengan backpropagation pada tahap pertama ini menggunakan arsitektur jaringan 12-24-1. Maksudnya, layer masukkan menggunakan 12 Neuron, layer tersembunyi 24 neuron serta 1 neuron layer keluaran. Rumus pelatihan backpropagation yang digunakan dengan aplikasi Matlab sebagai berikut : >> net=newff(minmax(P),[24,1],{'tansig','logsig'},'traingd');

>> net.b{1}; >> net.LW{2,1}; >> net.b{2};

>> net.trainParam.epochs=10000; net.trainParam.goal = 0.01;

net.trainParam.Lr = 0.01; net.trainParam.show = 1000; net=train(net,P,T)

Pelatihan dan pengujian Jaringan Syaraf Tiruan dengan arsitektur 12–24–1 dapat dilihat pada gambar 4.5 dan 4.6.

Gambar 4.5. Pelatihan Menggunakan Arsitektur 12-24-1

Tabel 4.6. Akurasi Data Pelatihan Arsitektur 12-24-1

Tabel 4.7. Akurasi Data Pengujian Arsitektur 12-24-1

Bulan Pola Target Output Error SSE Hasil

Dari arsitektur 12-24-1 diatas dapat diketahui bahwa epoch yang terjadi sebanyak 4999 iterasi, dengan tingkat akurasi pelatihan sebesar 67% dan akurasi Pengujian sebesar 58%.

4.3.4. Pelatihan Dan Pengujian Data Dengan Arsitektur 12-33-1

Pelatihan dan pengujian data dengan backpropagation pada tahap pertama ini menggunakan arsitektur jaringan 12-33-1. Maksudnya, layer masukkan menggunakan 12 Neuron, layer tersembunyi 33 neuron serta 1 neuron layer keluaran. Rumus pelatihan backpropagation yang digunakan dengan aplikasi Matlab sebagai berikut : >> net=newff(minmax(P),[33,1],{'tansig','logsig'},'traingd');

>> net.b{1}; >> net.LW{2,1}; >> net.b{2};

>> net.trainParam.epochs=10000; net.trainParam.goal = 0.01;

net.trainParam.Lr = 0.01; net.trainParam.show = 1000; net=train(net,P,T)

Pelatihan dan pengujian Jaringan Syaraf Tiruan dengan arsitektur 12–33–1 dapat dilihat pada gambar 4.7 dan 4.8.

Gambar 4.7. Pelatihan Menggunakan Arsitektur 12-33-1

Tabel 4.8. Akurasi Data Pelatihan Arsitektur 12-33-1

Tabel 4.9. Akurasi Data Pengujian Arsitektur 12-33-1

Bulan Pola Target Output Error SSE Hasil

Dari arsitektur 12-33-1 diatas dapat diketahui bahwa epoch yang terjadi sebanyak 961 iterasi, dengan tingkat akurasi pelatihan sebesar 67% dan akurasi Pengujian sebesar 25%.

4.3.5. Pelatihan Dan Pengujian Data Dengan Arsitektur 12-34-1

Pelatihan dan pengujian data dengan backpropagation pada tahap pertama ini menggunakan arsitektur jaringan 12-34-1. Maksudnya, layer masukkan menggunakan 12 Neuron, layer tersembunyi 34 neuron serta 1 neuron layer keluaran. Rumus pelatihan backpropagation yang digunakan dengan aplikasi Matlab sebagai berikut : >> net=newff(minmax(P),[34,1],{'tansig','logsig'},'traingd');

>> net.b{1}; >> net.LW{2,1}; >> net.b{2};

>> net.trainParam.epochs=10000; net.trainParam.goal = 0.01;

net.trainParam.Lr = 0.01; net.trainParam.show = 1000; net=train(net,P,T)

Pelatihan dan pengujian Jaringan Syaraf Tiruan dengan arsitektur 12–34–1 dapat dilihat pada gambar 4.9 dan 4.10.

Gambar 4.9. Pelatihan Menggunakan Arsitektur 12-34-1

Tabel 4.10. Akurasi Data Pelatihan Arsitektur 12-34-1

Tabel 4.11. Akurasi Data Pengujian Arsitektur 12-34-1

Bulan Pola Target Output Error SSE Hasil

Dari arsitektur 12-34-1 diatas dapat diketahui bahwa epoch yang terjadi sebanyak 1491 iterasi, dengan tingkat akurasi pelatihan sebesar 67% dan akurasi Pengujian sebesar 25%.

4.4. Optimasi Backpropagation Dengan Conjugate Gradient Fletcher Reeves

net.trainFcn = 'traincgf', mengatur jaringan trainFcn properti. [net,tr] = train(net,...), melatih jaringan dengan traincgf

4.4.1. Optimasi Arsitektur 12-6-1

Optimasi menggunakan arsitektur jaringan 12-6-1. Maksudnya, layer masukan menggunakan 12 Neuron, layer tersembunyi 6 neuron serta 1 neuron layer keluaran. Rumus pelatihan optimasi backpropagation + fletcher reeves yang digunakan dengan aplikasi Matlab sebagai berikut :

>> net=newff(minmax(P),[6,1],{'tansig','logsig'},'traincgf'); >> net.IW{1,1};

>> net.b{1}; >> net.LW{2,1}; >> net.b{2};

>> net.trainParam.epochs=10000; net.trainParam.goal = 0.01;

net.trainParam.show = 1000; net=train(net,P,T)

Hasil optimasi arsitektur 12–6–1 dengan conjugate gradient fletcher reeves dapat dilihat pada gambar 4.11.

Tabel 4.12. Akurasi Data Pelatihan Arsitektur 12-6-1 Dengan Fletcher Reeves [a,Pf,Af,e,Perf]=sim(net,P,[],[],T) yang dimasukkan pada aplikasi Matlab dari input dan target data pelatihan. Nilai Error diperoleh dari : Target-Output. SSE diperoleh dari : Error ^ 2. Jumlah SSE adalah total dari keseluruhan SSE. MSE diperoleh dari : Jumlah SSE / 12 (jumlah data). Hasil bernilai Benar apabila nilai SSE <= 0,01. 0,01 adalah target error dari pelatihan backpropagation. Akurasi (%) diperoleh dari : Jumlah Benar / 12 * 100.

Tabel 4.13. Akurasi Data Pengujian Arsitektur 12-6-1 Dengan Fletcher Reeves

Bulan Pola Target Output Error SSE Hasil

[a,Pf,Af,e,Perf]=sim(net,P,[],[],T) yang dimasukkan pada aplikasi Matlab dari input dan target data pengujian. Nilai Error diperoleh dari : Target-Output. SSE diperoleh dari : Error ^ 2. Jumlah SSE adalah total dari keseluruhan SSE. MSE diperoleh dari : Jumlah SSE / 12 (jumlah data). Hasil bernilai Benar apabila nilai SSE <= 0,01. 0,01 adalah target error dari pengujian backpropagation. Akurasi (%) diperoleh dari : Jumlah Benar / 12 * 100.

Dari arsitektur 12-6-1 diatas dengan menggunakan optimasi Fletcher Reeves dapat diketahui bahwa epoch yang terjadi sebanyak 6 iterasi, dengan tingkat akurasi pelatihan sebesar 58% dan akurasi Pengujian sebesar 58%.

4.4.2. Optimasi Arsitektur 12-15-1

Optimasi menggunakan arsitektur jaringan 12-15-1. Maksudnya, layer masukan menggunakan 12 Neuron, layer tersembunyi 15 neuron serta 1 neuron layer keluaran. Rumus pelatihan optimasi backpropagation + fletcher reeves yang digunakan dengan aplikasi Matlab sebagai berikut :

>> net=newff(minmax(P),[15,1],{'tansig','logsig'},'traincgf'); >> net.IW{1,1};

>> net.b{1}; >> net.LW{2,1}; >> net.b{2};

>> net.trainParam.epochs=10000; net.trainParam.goal = 0.01;

net.trainParam.show = 1000; net=train(net,P,T)

Gambar 4.12. Optimasi Pelatihan Menggunakan Arsitektur 12-15-1

Tabel 4.14. Akurasi Data Pelatihan Arsitektur 12-15-1 Dengan Fletcher Reeves

Bulan Pola Target Output Error SSE Hasil 1 Pola 1 0,76492 0,66640 0,09852 0,0097063371 Benar

2 Pola 2 0,41482 0,47320 -0,05838 0,0034085318 Benar

3 Pola 3 0,34700 0,28440 0,06260 0,0039190189 Benar

4 Pola 4 0,32164 0,32790 -0,00626 0,0000391845 Benar

5 Pola 5 0,55596 0,45030 0,10566 0,0111643327 Salah

6 Pola 6 0,82502 0,76630 0,05872 0,0034477130 Benar

7 Pola 7 0,74176 0,86340 -0,12164 0,0147952434 Salah

8 Pola 8 0,66568 0,80860 -0,14292 0,0204264574 Salah

9 Pola 9 0,55651 0,68220 -0,12569 0,0157972849 Salah

10 Pola 10 0,59400 0,68530 -0,09130 0,0083349350 Benar

11 Pola 11 0,64197 0,66970 -0,02773 0,0007688944 Benar

12 Pola 12 0,90000 0,74440 0,15560 0,0242113600 Salah Jumlah SSE 0,1160192929

58%

Tabel 4.15. Akurasi Data Pengujian Arsitektur 12-15-1 Dengan Fletcher Reeves

Dari arsitektur 12-15-1 diatas dengan menggunakan optimasi Fletcher Reeves dapat diketahui bahwa epoch yang terjadi sebanyak 2 iterasi, dengan tingkat akurasi pelatihan sebesar 58% dan akurasi Pengujian sebesar 67%.

4.4.3. Optimasi Arsitektur 12-24-1

Optimasi menggunakan arsitektur jaringan 12-24-1. Maksudnya, layer masukan menggunakan 12 Neuron, layer tersembunyi 24 neuron serta 1 neuron layer keluaran. Rumus pelatihan optimasi backpropagation + fletcher reeves yang digunakan dengan aplikasi Matlab sebagai berikut :

>> net=newff(minmax(P),[24,1],{'tansig','logsig'},'traincgf');

Gambar 4.13. Optimasi Pelatihan Menggunakan Arsitektur 12-24-1

Tabel 4.16. Akurasi Data Pelatihan Arsitektur 12-24-1 Dengan Fletcher Reeves

Bulan Pola Target Output Error SSE Hasil 1 Pola 1 0,76492 0,69900 0,06592 0,0043455445 Benar

2 Pola 2 0,41482 0,41780 -0,00298 0,0000088961 Benar

3 Pola 3 0,34700 0,44210 -0,09510 0,0090436168 Benar

4 Pola 4 0,32164 0,37120 -0,04956 0,0024561690 Benar

5 Pola 5 0,55596 0,65900 -0,10304 0,0106169519 Salah

6 Pola 6 0,82502 0,93970 -0,11468 0,0131521379 Salah

7 Pola 7 0,74176 0,84370 -0,10194 0,0103908868 Salah

8 Pola 8 0,66568 0,64730 0,01838 0,0003377818 Benar

9 Pola 9 0,55651 0,32420 0,23231 0,0539692137 Salah

10 Pola 10 0,59400 0,59530 -0,00130 0,0000016793 Benar

11 Pola 11 0,64197 0,62450 0,01747 0,0003052377 Benar

12 Pola 12 0,90000 0,77890 0,12110 0,0146652100 Salah Jumlah SSE 0,1192933255

58%

Tabel 4.17. Akurasi Data Pengujian Arsitektur 12-24-1 Dengan Fletcher Reeves

Dari arsitektur 12-24-1 diatas dengan menggunakan optimasi Fletcher Reeves dapat diketahui bahwa epoch yang terjadi sebanyak 15 iterasi, dengan tingkat akurasi pelatihan sebesar 58% dan akurasi Pengujian sebesar 50%.

4.4.4. Optimasi Arsitektur 12-33-1

Optimasi menggunakan arsitektur jaringan 12-33-1. Maksudnya, layer masukan menggunakan 12 Neuron, layer tersembunyi 33 neuron serta 1 neuron layer keluaran. Rumus pelatihan optimasi backpropagation + fletcher reeves yang digunakan dengan aplikasi Matlab sebagai berikut :

>> net=newff(minmax(P),[33,1],{'tansig','logsig'},'traincgf');

Gambar 4.14. Optimasi Pelatihan Menggunakan Arsitektur 12-33-1

Tabel 4.18. Akurasi Data Pelatihan Arsitektur 12-33-1 Dengan Fletcher Reeves

Bulan Pola Target Output Error SSE Hasil 1 Pola 1 0,76492 0,8118 -0,04688 0,0021976646 Benar

2 Pola 2 0,41482 0,5098 -0,09498 0,0090217005 Benar

3 Pola 3 0,34700 0,2962 0,05080 0,0025808501 Benar

4 Pola 4 0,32164 0,2514 0,07024 0,0049336925 Benar

5 Pola 5 0,55596 0,3415 0,21446 0,0459936946 Salah

6 Pola 6 0,82502 0,7844 0,04062 0,0016497593 Benar

7 Pola 7 0,74176 0,7449 -0,00314 0,0000098326 Benar

8 Pola 8 0,66568 0,6287 0,03698 0,0013674348 Benar

9 Pola 9 0,55651 0,6892 -0,13269 0,0176059064 Salah

10 Pola 10 0,59400 0,6462 -0,05220 0,0027244083 Benar

11 Pola 11 0,64197 0,6557 -0,01373 0,0001884839 Benar

12 Pola 12 0,90000 0,7819 0,11810 0,0139476100 Salah Jumlah SSE 0,1022210376

75%

Tabel 4.19. Akurasi Data Pengujian Arsitektur 12-33-1 Dengan Fletcher Reeves

Dari arsitektur 12-33-1 diatas dengan menggunakan optimasi Fletcher Reeves dapat diketahui bahwa epoch yang terjadi sebanyak 16 iterasi, dengan tingkat akurasi pelatihan sebesar 75% dan akurasi Pengujian sebesar 42%.

4.4.5. Optimasi Arsitektur 12-34-1

Optimasi menggunakan arsitektur jaringan 12-34-1. Maksudnya, layer masukan menggunakan 12 Neuron, layer tersembunyi 34 neuron serta 1 neuron layer keluaran. Rumus pelatihan optimasi backpropagation + fletcher reeves yang digunakan dengan aplikasi Matlab sebagai berikut :

>> net=newff(minmax(P),[34,1],{'tansig','logsig'},'traincgf');

Gambar 4.15. Optimasi Pelatihan Menggunakan Arsitektur 12-34-1

Tabel 4.20. Akurasi Data Pelatihan Arsitektur 12-34-1 Dengan Fletcher Reeves

Bulan Pola Target Output Error SSE Hasil 1 Pola 1 0,76492 0,64790 0,11702 0,0136938546 Salah

2 Pola 2 0,41482 0,32470 0,09012 0,0081211399 Benar

3 Pola 3 0,34700 0,43870 -0,09170 0,0084085108 Benar

4 Pola 4 0,32164 0,37950 -0,05786 0,0033477509 Benar

5 Pola 5 0,55596 0,55790 -0,00194 0,0000037581 Benar

6 Pola 6 0,82502 0,92130 -0,09628 0,0092703719 Benar

7 Pola 7 0,74176 0,79330 -0,05154 0,0026559283 Benar

8 Pola 8 0,66568 0,51300 0,15268 0,0233108288 Salah

9 Pola 9 0,55651 0,38290 0,17361 0,0301413869 Salah

10 Pola 10 0,59400 0,55420 0,03980 0,0015843692 Benar

11 Pola 11 0,64197 0,53900 0,10297 0,0106030381 Salah

12 Pola 12 0,90000 0,88380 0,01620 0,0002624400 Benar Jumlah SSE 0,1114033775

67%

Tabel 4.21. Akurasi Data Pengujian Arsitektur 12-34-1 Dengan Fletcher Reeves

Dari arsitektur 12-34-1 diatas dengan menggunakan optimasi Fletcher Reeves dapat diketahui bahwa epoch yang terjadi sebanyak 15 iterasi, dengan tingkat akurasi pelatihan sebesar 67% dan akurasi Pengujian sebesar 33%.

Dari optimasi ke 5 arsitektur diatas dengan menggunakan Fletcher Reeves dapat diambil kesimpulan, bahwa arsitektur yang terbaik adalah dengan pola 12-15-1 dengan epoch sebanyak 821 iterasi dan tingkat akurasi mencapai 67% serta MSE 0,0090116088. Dengan demikian maka optimasi dengan metode fletcher reeves pada penelitian ini tidak terlalu signifikan, bahkan cenderung menurun tergantung dari pola pelatihan yang diberikan.

4.4.6. Hasil Pengujian Iterasi

Grafik hasil pengujian iterasi yang terjadi pada algoritma Backpropagation standard dengan Backpropagation yang dioptimasi dengan Conjugate Gradient Fletcher Reeves dapat dilihat pada gambar 4.16.

4.4.7. Hasil Pengujian Tingkat Akurasi Pelatihan

Grafik hasil pengujian tingkat akurasi pelatihan yang terjadi pada algoritma Backpropagation standard dengan Backpropagation yang dioptimasi dengan Conjugate Gradient Fletcher Reeves dapat dilihat pada gambar 4.17.

Gambar 4.17. Grafik Akurasi Pelatihan BP Standard Dan BP + CGFR

4.4.8. Hasil Pengujian Tingkat Akurasi Testing

Grafik hasil pengujian tingkat akurasi testing yang terjadi pada algoritma Backpropagation standard dengan Backpropagation yang dioptimasi dengan Conjugate Gradient Fletcher Reeves dapat dilihat pada gambar 4.18.

Gambar 4.18. Grafik Iterasi Pengujian BP Standard Dan BP + CGFR

4.5. Hasil Pembahasan

dengan Conjugate Gradient Fletcher Reeves terjadi peningkatan iterasi dengan rata-rata 38. Untuk akurasi pelatihan yang dilakukan dengan 5 percobaan yang sama, terjadi peningkatan akurasi pelatihan pada percobaan ke 1 dengan arsitektur jaringan 12-6-1, percobaan ke 4 dengan arsitektur jaringan 12-33-1 dan percobaan ke 5 dengan arsitektur jaringan 12-34-1. Terjadinya penurunan tingkat akurasi pelatihan pada percobaan 2 dengan arsitektur jaringan 12-15-1 dan percobaan 3 dengan arsitektur jaringan 12-24-1. Untuk akurasi pengujian yang dilakukan dengan 5 percobaan yang sama, terjadi peningkatan akurasi pengujian pada percobaan ke 1 dengan arsitektur jaringan 12-6-1, percobaan ke 4 dengan arsitektur jaringan 12-33-1 dan percobaan ke 5 dengan arsitektur jaringan 12-34-1. Terjadinya penurunan tingkat akurasi pengujian pada percobaan 2 dengan arsitektur jaringan 12-15-1 dan percobaan 3 dengan arsitektur jaringan 12-24-1.

BAB 5

KESIMPULAN DAN SARAN

5.1. Kesimpulan

Algoritma jaringan saraf tiruan ini telah memberikan hal yang cukup memuaskan dalam proses prediksi data. Setelah melakukan perancangan, pembuatan, implementasi sampai tahap evaluasi, dapat diambil kesimpulan sebagai berikut :

1) Jaringan saraf tiruan mampu digunakan untuk prediksi data Indeks Harga Konsumen (IHK) yang cukup akurat, dilihat dari hasil testing atau estimasi yang tepat. Dalam kasus ini arsitektur jaringan mempengaruhi naik turunnya tingkat kecepatan pembelajaran serta tingkat akurasi pelatihan dan pengujian. 2) Faktor pemilihan learning rate sangat berpengaruh pada kecepatan hasil iterasi

maupun tingkat akurasi.

3) Dengan melihat hasil pengujian, dapat diambil kesimpulan bahwa terjadi peningkatan kecepatan dan hasil akurasi yang sama pada 5 percobaan di setiap pengujian yang dilakukan.

4) Arsitektur terbaik pada penelitian ini adalah 12-15-1 dengan tingkat akurasi 75% dengan backpropagation standard dan 67% setelah dioptimasi dengan conjugate gradient fletcher reeves.

5.1. Saran