Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

METODE REGRESI RIDGE UNTUK MENGATASI MODEL

REGRESI LINIER BERGANDA YANG MENGANDUNG

MULTIKOLINIERITAS

SKRIPSI

NANANG PRADIPTA

030803013

DEPARTEMEN MATEMATIKA

FAKULTAS MATEMATIKA DAN ILMU PENGETAHUAN ALAM

UNIVERSITAS SUMATERA UTARA

MEDAN

2009

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

METODE REGRESI RIDGE UNTUK MENGATASI MODEL

REGRESI LINIER BERGANDA YANG MENGANDUNG

MULTIKOLINIERITAS

SKRIPSI

Diajukan untuk melengkapi tugas dan memenuhi syarat mencapai gelar Sarjana Sains

NANANG PRADIPTA 030803013

DEPARTEMEN MATEMATIKA

FAKULTAS MATEMATIKA DAN ILMU PENGETAHUAN ALAM UNIVERSITAS SUMATERA UTARA

MEDAN 2009

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

PERSETUJUAN

Judul : METODE REGRESI RIDGE UNTUK MENGATASI

MODEL REGRESI LINIER BERGANDA YANG MENGANDUNG MULTIKOLINIERITAS

Kategori : SKRIPSI

Nama : NANANG PRADIPTA

Nomor Induk Mahasiswa : 030803013

Program Studi : SARJANA (S1) MATEMATIKA

Fakultas : MATEMATIKA DAN ILMU PENGETAHUAN

ALAM (FMIPA) UNIVERSITAS SUMATERA UTARA

Medan, Maret 2009 Komisi Pembimbing :

Pembimbing 2 Pembimbing 1

Drs. H. Haluddin Panjaitan Drs. Suwarno Ariswoyo, M.Si NIP. 130 701 888 NIP. 130 810 774

Diketahui/Disetujui oleh

Departemen Matematika FMIPA USU Ketua,

Dr. Saib Suwilo, M.Sc NIP. 131 796 149

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

PERNYATAAN

METODE REGRESI RIDGE UNTUK MENGATASI MODEL REGRESI LINIER BERGANDA YANG MENGANDUNG MULTIKOLINIERITAS

SKRIPSI

Saya mengakui bahwa skripsi ini adalah hasil kerja saya sendiri, kecuali beberapa kutipan dan ringkasan yang masing-masing disebutkan sumbernya.

Medan, Maret 2009

NANANG PRADIPTA 030803013

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

PENGHARGAAN

Puji syukur penulis tujukan hanya kepada Allah SWT yang senantiasa mencurahkan nikmat dan kasih sayang-Nya sehingga penulis mampu menyelesaikan skripsi yang berjudul ”Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas” ini dengan baik. Skripsi ini sebagai salah satu mata kuliah wajib yang harus diselesaikan oleh seluruh mahasiswa Fakultas MIPA Departemen Matematika.

Pada kesempatan ini penulis mengucapkan terima kasih kepada : Bapak Dr. Eddy Marlianto, M.Sc, selaku Dekan Fakultas Matematika dan Ilmu Pengetahuan Alam, Universitas Sumatera Utara. Bapak Dr. Saib Suwilo, M.Sc, dan Bapak Henry Rani S, M.Si selaku Ketua dan Sekretaris Departemen Matematika di FMIPA USU Medan. Bapak Drs. Suwarno Ariswoyo, M.Si selaku dosen pembimbing I dan Drs. H. Haluddin Panjaitan selaku dosen pembimbing II yang telah memberi dukungan moril, motivasi dan ilmu pengetahuan bagi penulis dalam menyelesaikan Tugas Akhir II ini. Seluruh Staf Pengajar dan Pegawai Departemen Matematika, Fakultas Matematika dan Ilmu Pengetahuan Alam, Universitas Sumatera Utara. Keluarga tercinta, permata tercintaku Ayahanda Syafi`i Syam dan Ibunda Rida Wardiah yang selalu memberikan perhatian, dukungan dan motivasi baik moril maupun materil, Istriku tercinta Adinda Rina Zahara yang senantiasa mencurahkan kasih sayangnya, buah hatiku Mush`ab Hafizh Al-Bukhori, juga tidak terlupakan kepada mas Ndoyo, mbak Isa, mbak Ita dan adik-adikku tersayang Sugeng dan Tiwi serta keponakanku Abi dan Dinda.

Serta teman-temanku Mahasiswa Departemen Matematika khususnya stambuk 2003, Budi, Jumiana, Amel, Mardiana yang telah banyak membantu dalam penyelesaian penulisan skripsi ini dan buat teman-teman di MaTa AIR INDONESIA terima kasih atas semuanya. Dan semua pihak yang tidak mungkin disebut satu-persatu yang ikut membantu secara langsung maupun tidak langsung. Semoga Allah SWT memberikan balasan atas jasa-jasa mereka yang telah diberikan kepada penulis.

Penulis menyadari masih banyak kekurangan dalam penulisan ini, untuk itu penulis meminta saran dan kritik yang membangun dari pembaca sekalian.

Akhir kata penulis mengucapkan terima kasih atas perhatiannya, semoga tulisan ini berguna bagi yang membutuhkan.

Medan, Maret 2009 Penulis,

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

ABSTRAK

Metode kuadrat terkecil merupakan suatu metode estimasi parameter regresi yang paling sederhana untuk regresi linier sederhana maupun regresi linier berganda, tetapi jika diantara variabel-variabel bebas ditemukan multikolinieritas yang sempurna antara variable bebasnya maka estimator yang diperoleh dari metode kuadrat terkecil tidak dapat digunakan. Jika multikolinieritas yang terjadi hampir sempurna, meskipun metode kuadrat terkecil dapat digunakan tetapi galat yang dihasilkan akan menjadi besar, variansi dan kovariansi parameternya menjadi besar pula, padahal nilai estimasi yang diinginkan haruslah memiliki galat dan variansi yang minimum.

Metode Regresi Ridge merupakan salah satu cara untuk mengatasi masalah multikolinieritas diantara variable-variabel bebasnya karena memberikan tetapan bias yang relatif kecil dan memberikan variansi yang minimum. Metode ini merupakan modifikasi dari metode kuadrat terkecil dengan cara mengalikan tetapan bias c yang kecil pada diagonal matriks identitas. Sehingga parameter penduganya menjadi :

( )

c(

XTX cI)

1XTY *ˆ = + −

β

Dengan c adalah sebuah bilangan yang positif atau c≥0, umumnya c terletak antara interval 0<c<1.

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

ABSTRACT

The Ordinary Least Square method is a method of the simplest regression parameter estimate for simple linear regression and also multiple linear regression, but if the perfect multicollinearity is found among independent variables between independent variables hence the obtained estimator from the ordinary least square method can not be used. If multicollinearity that happened almost perfect, though the ordinary least square method cam be used but the yielded error will become big, variance and covariance of its parameter also become big, though the wanted estimate assessment shall have error and minimum variance.

The Ridge regression method is one of the way to overcome problem of multicollinearity among independent variables because giving biased constanta which is relatively small and giving minimum variance. This method is modification of ordinary least square method by multiplying biased constanta of small deflect c on diagonal identity matrix. Therefore its parameter becomes :

( )

c(

XTX cI)

1XTY *ˆ = + −

β

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 DAFTAR ISI Halaman Persetujuan i Pernyataan ii Penghargaan iii Abstrak iv Abstract v Daftar Isi vi

Daftar Tabel viii

Daftar Gambar ix Bab 1 Pendahuluan 1 1.1 Latar Belakang 1 1.2 Perumusan Masalah 3 1.3 Pembatasan Masalah 4 1.4 Tinjauan Pustaka 4 1.5 Tujuan Penelitian 5 1.6 Kontribusi Penelitian 5 1.7 Metodologi Penelitian 5

Bab 2 Landasan Teori 7

2.1 Ukuran Pemusatan dan Penyebaran 7

2.2 Matriks 9

2.2.1Definisi 9

2.2.2Jenis Matriks 11

2.2.3Operasi Matriks 13

2.3 Nilai Eigen dan Vektor Eigen 17

2.4 Regresi Linier Berganda 18

2.5 Penduga Parameter 19

2.6 Matriks Korelasi 22

2.7 Multikolinieritas 23

2.8 Pendeteksian Multikolinieritas 25

2.9 Pengaruh Multikolinieritas 26

2.10 Metode Regresi Ridge 27

2.10.1 Gambaran Umum Regresi Ridge 27

2.10.2 Gambaran Umum Ridge Trace 28

2.11 Uji Regresi Linier 28

2.12 Uji Koefisien Korelasi Ganda 29

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

3.1 Regresi Ridge 30

3.2 Ridge Trace 31

3.3 Pemodelan Regresi Ridge 34

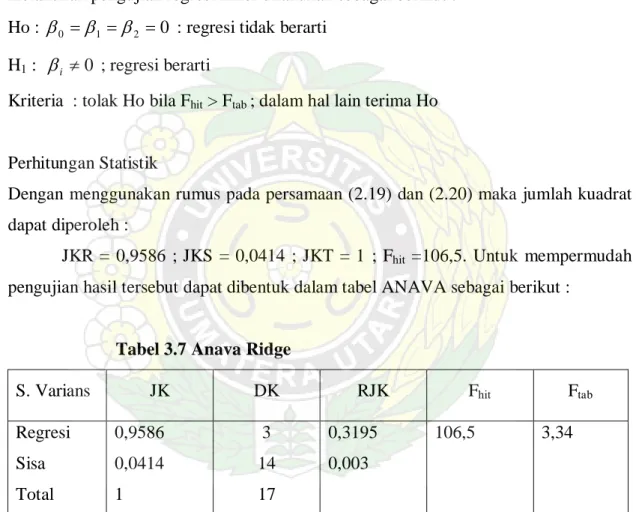

3.4 Uji Keberartian Regresi 38

Bab 4 Kesimpulan Dan Saran 41

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

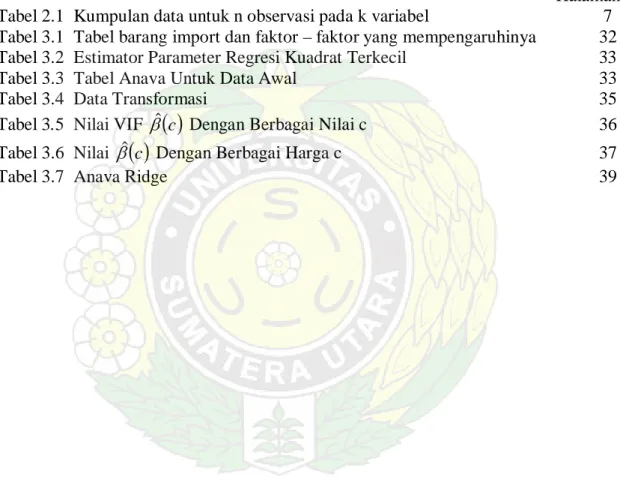

DAFTAR TABEL

Halaman Tabel 2.1 Kumpulan data untuk n observasi pada k variabel 7 Tabel 3.1 Tabel barang import dan faktor – faktor yang mempengaruhinya 32 Tabel 3.2 Estimator Parameter Regresi Kuadrat Terkecil 33

Tabel 3.3 Tabel Anava Untuk Data Awal 33

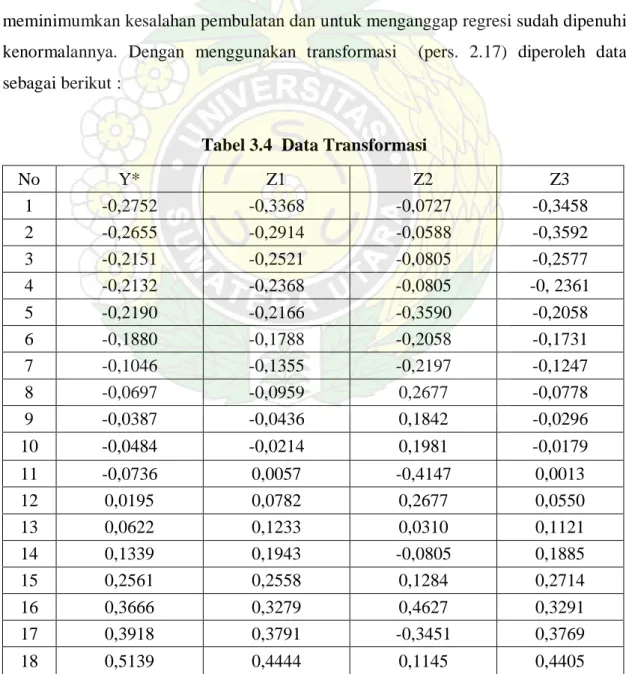

Tabel 3.4 Data Transformasi 35

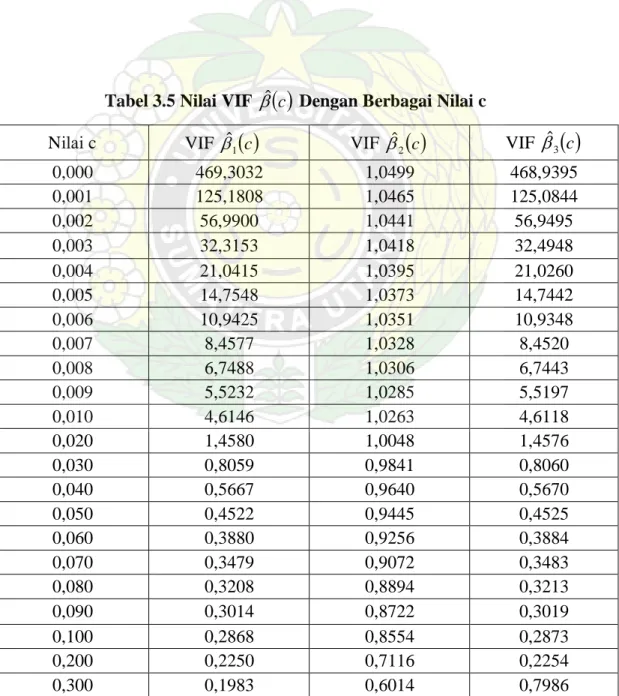

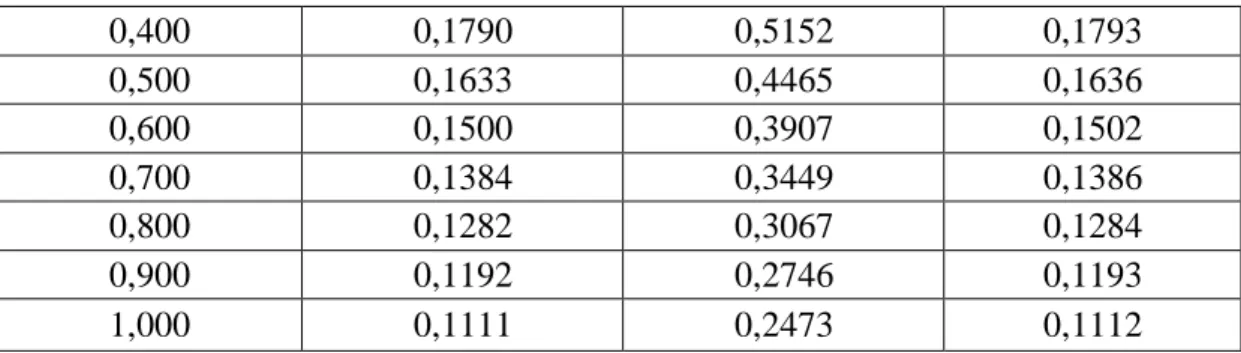

Tabel 3.5 Nilai VIF βˆ

( )

c Dengan Berbagai Nilai c 36 Tabel 3.6 Nilai βˆ( )

c Dengan Berbagai Harga c 37Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

DAFTAR GAMBAR

Halaman

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 BAB 1 PENDAHULUAN 1.1 Latar Belakang

Dalam suatu penelitian banyak hal menarik untuk diamati. Sehingga si peneliti harus melihat berbagai faktor yang mempengaruhi serta menganalisisnya untuk keperluan penelitiannya. Terkadang, terlalu banyaknya faktor yang mempengaruhi penelitian maka dibutuhkan suatu model matematis yang ringkas dan sesuai untuk menyelesaikan penelitian tersebut. Sebut saja model matematis tersebut adalah model statistika. Model statistika merupakan suatu model matematis yang meliputi variabel bebas dan variabel tak bebas dari parameter persamaan yang digunakan untuk mengetahui bentuk hubungan antara peubah-peubah yang dipakai sebagai keperluan pendugaan ataupun peramalan. Sehingga untuk keperluan tersebut maka parameter-parameter yang terkait harus didefinisikan terlebih dahulu.

Salah satu dari model statistika yang sering digunakan dalam pemecahan suatu permasalahan adalah model Regresi Linier (Linear Regression). Model regresi linier merupakan sebuah model yang digunakan untuk menganalisis hubungan antar variabel. Hubungan tersebut dapat diekspresikan dalam bentuk persamaan yang menghubungkan variabel terikat Y dengan satu atau lebih variabel bebas X1, X2, ..., Xk .

Jika variabel terikat (Y) hanya dihubungkan dengan satu variabel bebas (X), maka akan menghasilkan persamaan regresi linier yang sederhana (Simple Linear Regression). Sedangkan jika variabel bebas (X) yang digunakan lebih dari satu, maka persamaan regresinya adalah persamaan regresi linier berganda (Multiple Linear Regression).

Secara umum persamaan regresi linier dengan k variabel bebas dinyatakan dengan : i ki k i i i X X X Y =β0 +β1 1 +β2 2 ++β +ε dengan :

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009 i

Y = variabel tak bebas / pengamatan ke i pada variabel yang dijelaskan y

i

X = variabel bebas / pengamatan ke i pada variabel penjelas xk k

β

β1,, = parameter / koefisien regresi variabel penjelas xk i

ε = variabel gangguan / error

k

β

β1,, adalah parameter-parameter yang akan diduga, yang mana dalam tulisan ini digunakan metode kuadrat terkecil biasa (Ordinary Least Square, OLS) sebagai penduganya. Penduga dengan MKT akan menghasilkan taksiran yang diijinkan jika asumsi berikut terpenuhi:

a. Nilai rata-rata kesalahan pengganggu nol, yaitu : E

( )

εi =0 untuk i=1, 2,,n b. Var( )

εi =E( )

εi2 =σ2, adalah konstan untuk semua kesalahan pengganggu(asumsi homoskedastisitas).

c. Tidak ada korelasi serial (autocorrelation) antara penggangu εi, berarti kovarian

( )

εiεj =0,i≠ jd. Peubah bebas x1,x2,,xn konstan dalam sampling yang terulang dan bebas terhadap kesalahan pengganggu εi.

e. Tidak ada multikoloniaritas diantara peubah bebas.

f. εi ≈N

(

0,σ2)

, artinya kesalahan pengganggu menyebar mengikuti distribusi normal dengan rata-rata 0 dan variansi σ2.Salah satu asumsi dari model regresi linier klasik diatas adalah bahwa tidak ada multikolinieritas atau tidak ada hubungan linier (kolinieritas) antara variabel-variabel bebasnya. Jika terdapat multikolinieritas di dalam persamaan regresi tersebut maka akan mengakibatkan penggunaan OLS dalam mengestimasi parameter/koefisien regresi akan terganggu. Jika multikolinieritas yang hampir sempurna terjadi, meskipun metode kuadrat terkecil dapat digunakan tetapi galat yang dihasilkan akan menjadi besar, variansi dan kovariansi parameter tidak terhingga.

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

Ada beberapa cara untuk mengatasi masalah ini, diantaranya ialah :

1. Dengan memperbesar ukuran sampel sehingga kovarian diantara parameter-parameternya dapat dikurangi. Hal ini disebabkan karena kovariansi berhubungan terbalik dengan ukuran sampel, tetapi harus diingat bahwa hal ini akan benar jika interkorelasi yang terjadi hanya didalam sampel dan bukan didalam populasi dari variabel-variabel. Jika variabel-variabel ini berkolinier dalam populasi maka prosedur memperbesar ukuran sampel tidak akan mengurangi multikolinieritas 2. Mengeluarkan suatu variabel yang diketahui menyebabkan terjadinya

multikolinieritas, tetapi dalam mengeluarkan suatu variabel dari model, kita mungkin melakukan bias spesifikasi. Bias spesifikasi timbul dari spesifikasi yang tidak benar dari model yang digunakan dalam analisis.

3. Metode Regresi Ridge, metode ini pertama kali dikemukakan oleh A.E. Hoerl pada tahun 1962. Regresi ini merupakan modifikasi dari metode kuadrat terkecil dengan cara menambah tetapan bias c yang kecil pada diagonal matrik XTX.

Dari beberapa cara mengatasi masalah multikolinieritas diatas, metode Regresi Ridge merupakan penyelesaian yang paling baik, karena mengingat tujuan Regresi Ridge untuk memperkecil variansi estimator koefisien regresi.

Berdasarkan latar belakang inilah maka penulis memberi judul tulisan ini yaitu ”Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas".

1.2 Perumusan Masalah

Multikolinieritas merupakan salah satu faktor yang menyebabkan persamaan regresi linier berganda menjadi tidak efektif dan akurat. Multikolinieritas juga mengakibatkan penggunaan OLS dalam mengestimasi parameter/koefisien regresi akan terganggu. Jika multikolinieritas yang hampir sempurna terjadi, meskipun metode kuadrat terkecil dapat digunakan tetapi galat yang dihasilkan akan menjadi besar, variansi dan kovariansi parameter tidak terhingga. Oleh karena itu, dalam tulisan ini akan dibahas tentang penggunaan metode Regresi Ridge dalam mengatasi masalah multikolinieritas yang terdapat dalam suatu persamaan linier berganda, sehingga dapat ditentukan

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

persamaan regresi linier berganda yang terbaik dan tidak memiliki masalah multikolinieritas.

1.3 Pembatasan Masalah

Agar penyelesaian masalah tidak menyimpang dari pembahasan maka perlu dibuat suatu pembatasan masalah yaitu dengan menganggap bahwa asumsi klasik yang lain tetap terpenuhi.

1.4 Tinjauan Pustaka

Djalal Nachrowi et al, (2002) mengatakan prinsip Ordinary Least Square (OLS) mengatakan bahwa kita perlu menaksir β1 dan β2 sehingga

∑

ei2 minimum. Artinya, kita akan mencari β1 dan β2 sedemikian sehingga model regresi yang terestimasi dekat sekali dengan model regresi yang sesungguhnya. Secara matematis, β1 dan β2 kita pilih sedemikian sehingga bentuk berikut terpenuhi :(

)

2 2 1 2∑

∑

ei = Yi − − Xi Minimum β βSupranto, J. (1992) dalam bukunya mengatakan istilah kolinieritas ganda (Multicolliniearity) merupakan hubungan linier yang sempurna atau eksak diantara variabel-variabel bebas dalam model regresi. Istilah kolinieritas sendiri berarti hubungan linier tunggal, sedangkan kolinieritas ganda (multikolinieritas) menunjukkan adanya lebih dari satu hubungan linier yang sempurna.

Walpole et al, (1986) dalam bukunya mengatakan suatu cara dalam menghadapi multikolinieritas adalah meninggalkan metode kuadrat terkecil yang biasa dan menggunakan cara penaksiran yang bias. Dalam menggunakan cara penaksiran yang bias ini, pada dasarnya kita bersedia menerima sejumlah bias tertentu dalam taksiran agar variansi penaksir dapat diperkecil. Taksiran bias yang diperoleh disini untuk koefisien regresi β0, β1, ,βk dalam model

ε β β β β + + + + + = x x kxk y 0 1 1 2 2

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 dinyatakan dengan * * 1 * 0, b , ,bk

b dan disebut taksiran regresi Ridge. Taksiran ini diperoleh melalui pendekatan kuadrat terkecil terkendala yang berdasarkan intuisi menarik dengan meminimumkan jumlah kuadrat galat dengan kendala

k j

b*j =ρj, =0,1,, dengan ρj merupakan tetapan positif yang berhingga.

1.5 Tujuan Penelitian

Masalah multikolinieritas merupakan kondisi buruk yang menyebabkan matrik XTX hampir singular yang akan mengakibatkan nilai estimasi parameter tidak stabil. Tujuan dari penelitian ini adalah menggunakan Regresi Ridge untuk mengatasi masalah multikolinieritas antara variabel-variabel bebas sehingga diperoleh persamaan regresi linier berganda yang lebih baik.

1.6 Kontribusi Penelitian

Regresi adalah salah satu metode yang digunakan untuk menaksir suatu peubah tak bebas dengan memperhatikan faktor-faktor penyebabnya. Dari penulisan ini, penulis berharap dapat memberikan satu solusi alternatif bagi pengguna analisis regresi linier dengan masalah multikolinieritas yang terdapat pada data. Sehingga model regresi tersebut dapat diatasi dan menjadi model regresi yang benar.

1.7 Metodologi Penelitian

Penelitian ini dibuat berdasarkan studi literatur dan mengikuti langkah-langkah sebagai berikut :

1. Mengumpulkan dan mempelajari pustaka-pustaka yang berkenaan dengan materi penelitian seperti regresi linier berganda, multikolinieritas, serta metode Regresi Ridge.

2. Menyusun hasil langkah pertama dalam tulisan ini dengan :

a. Menerangkan konsep dasar matriks, multikolinieritas dan metode Regresi Ridge.

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

b. Mendeteksi keberadaan multikolinieritas.

c. Menguraikan penyelesaian masalah multikolinieritas dengan metode Regresi Ridge.

d. Menyelesaikan contoh kasus yang mengandung multikolinieritas dengan metode Regresi Ridge. Dalam hal ini digunakan software SPSS sebagai pengelolah data untuk menentukan persamaan regresi linier berganda dengan menggunakan metode kuadrat terkecil dan software MATLAB sebagai pendeteksi ada tidaknya multikolinieritas pada persamaan regresi linier berganda yang telah diperoleh.

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

BAB 2

LANDASAN TEORI

2.1 Ukuran Pemusatan dan Penyebaran

Hasil penelitian riset maupun pengamatan baik yang dilakukan khusus ataupun dalam bentuk laporan, sering diinginkan suatu uraian dan kesimpulan tentang persoalan yang diteliti. Sebelum kesimpulan dibuat, keterangan atau data yang telah terkumpul itu terlebih dahulu dipelajari, dianalisis atau diolah, serta berdasarkan pengolahan inilah baru kesimpulan dibuat.

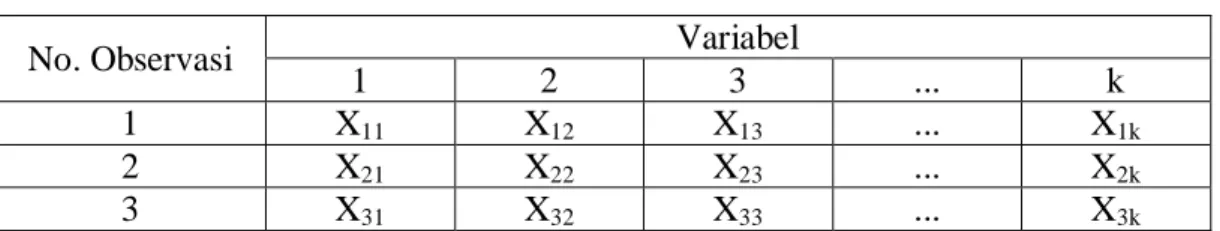

Statistika adalah pengetahuan yang berhubungan dengan cara-cara pengumpulan data, pengolahan atau penganalisisan dan penarikan kesimpulan berdasarkan kumpulan data dan penganalisisan yang dilakukan. Kumpulan data yang lengkap dan jelas yang ingin dipelajari sifat-sifatnya dinamakan populasi sedangkan sebagian data yang diambil dari populasi dinamakan sampel, dimana sampel diharapkan dapat mewakili populasi. Jika k≥1dari satu populasi maka akan ada k buah data sampel, akan digunakan notasi Xji untuk mengenali setiap observasi ke-j pada sampel atau variabel-variabel ke-i. Misalkan n observasi pada k variabel dapat dibentuk sebagai berikut :

Tabel 2.1 Kumpulan data untuk n observasi pada k variabel

No. Observasi Variabel

1 2 3 ... k

1 X11 X12 X13 ... X1k

2 X21 X22 X23 ... X2k

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 . . . . . . . . . . . . ... ... ... . . . n Xn1 Xn2 Xn3 ... Xnk

Kalau dalam bentuk matriks X didefinisikan sebagai berikut :

= nk n n k k X X X X X X X X X X 2 1 2 22 21 1 12 11

Jika observasi sebuah sampel sebesar n, maka rata-rata sampel ke-j yang merupakan ukuran pemusatan didefinisikan sebagai berikut :

∑

= ji j X n X 1 ; j = 1,2,3, ... , k dan i = 1,2,3, ... , n (2.1) dengan n > kVariansi sampel merupakan ukuran penyebaran didefinisikan sebagai berikut :

(

)

; 1 1 2 2∑

− − = ji j j X X n S j = 1,2,3, ... , k (2.2) = = jj j SS2 variansi sampel ke-j

Variansi sampel yang menunjukkan tingkat hubungan antara dua sampel yang didefinisikan sebagai berikut:

(

)

(

)

(

hi h)

n i j ji h j jh X X X X n X X Cov S − − − = =∑

=1 1 1 (2.3) dengan j = 1,2,3, ... , k dan h = 1,2,3, ... , kSjh = kovariansi antara Xjdan Xh

Koefisien korelasi merupakan ukuran variansi khusus antara dua variabel yang tidak bergantung pada suatu unit pengukuran antara dua variabel di definisikan sebagai berikut : hh jj jh xjxh S S S r =

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009

(

)

(

)

(

)

∑

(

)

∑

∑

= = = − − − − = n i h hi n i j ji h hi n i j ji X X X X X X X X 1 2 2 1 1 (2.4) dengan h jX Xr = koefisien korelasi antara Xj dan Xh

Kumpulan dasar pemusatan dan penyebaran dalam bentuk matriks adalah :

Rata-rata sampel = k x x x X 2 1

Variansi dan Kovariansi = Sk =

kk k k k k S S S S S S S S S 2 1 2 22 21 1 12 11 Korelasi sampel C = 1 1 1 2 1 2 21 1 12 k k k k r r r r r r 2.2 Matriks 2.2.1 Definisi

Matrik adalah suatu kumpulan angka – angka yang juga sering disebut elemen-elemen yang disusun secara teratur menurut baris dan kolom sehingga berbentuk persegi panjang, dimana panjang dan lebarnya ditunjukkan oleh banyaknya kolom dan baris serta dibatasi dengan tanda “

[ ]

“ atau “( )

“.Sebuah matriks dinotasikan dengan simbol huruf besar seperti A, X, atau Z. Contoh :

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 = × 23 22 21 13 12 11 3 2 a a a a a a A

disebut matriks A dengan 2 baris dan 3 kolom. Jika A sebuah matriks, kita gunakan untuk menyatakan elemen yang terdapat didalam baris i dan kolom j dari A. Dalam contoh ini i = 1, 2 dan j = 1, 2, 3 atau dapat ditulis :

[ ]

=1,2 =1,2,3= a i j

A ij

Sebuah matriks yang berukuran m baris dan n kolom dengan aij dapat ditulis sebagai berikut : = × mn m m n n n m a a a a a a a a a A 2 1 2 22 21 1 12 11

Atau juga dapat ditulis :

[ ]

a i m j nA= ij =1,2,, ; =1,2,,

Skalar

Suatu skalar adalah besaran yang hanya memiliki nilai tetapi tidak memiliki arah. Vektor Baris

[ ]

aij mxnA= disebut vektor baris ⇔m=1

Contoh : X1x4 =

[

4 7 2 5]

Vektor Kolom

[ ]

aij mxnNanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

Contoh dari vektor kolom :

= 1 3 2 5 1 4x X Kombinasi linier

Vektor w merupakan kombinasi linier dari vektor-vektor v1,v2,,vn jika terdapat skalar k1, k2, ... , kn sehingga berlaku :

, 2 2 1 1v k v knvn k w= + ++ (2.5)

Jika vektor w = 0 maka disebut persamaan homogen dan v1,v2,,vndisebut vektor yang bebas linier, yang mengakibatkan k1 = k2 = ... = kn = 0, tetapi jika ada

bilangan k1, k2, ..., kn yang tidak semuanya sama dengan nol, maka n

v v

v1, 2,, disebut vektor yang bergantung linier.

2.2.2 Jenis-jenis Matriks

Matriks Kuadrat

Matriks kuadrat adalah matriks yang memiliki baris dan kolom yang sama banyak. Dalam suatu matriks kuadrat, elemen – elemen a11,a22,,anndisebut elemen diagonal utama. Jumlah elemen – elemen diagonal utama suatu matriks kuadrat A disebut trace A ditulis tr (A). tr

( )

A a(

i j)

n i ij = =

∑

=1 , Contoh : = × nn n n n n n n a a a a a a a a a A 2 1 2 22 21 1 12 11( )

A a11 a22 ann. tr = + ++Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

Matriks Diagonal

Matriks kuadrat A=

[ ]

aij dinamakan matriks diagonal jika semua elemen diluar diagonal utama adalah nol, aij =0 untuki≠ j.Contoh : = 6 0 0 5 A , dan − = 3 0 0 0 5 0 0 0 2

A merupakan matriks diagonal.

Matriks Simetris

Suatu matriks kuadrat A=

[ ]

aij ;i,j=1,2,,n disebut matriks simetris jika elemendibawah diagonal utama merupakan cermin dari elemen diatas diagonal utama. Matriks simetri jika AT = A artinya aij =aji.

Contoh : = 3 6 4 6 2 0 4 0 1 A Matriks Identitas

Matriks A disebut matriks identitas dan biasa diberi simbol I.

[ ]

a I m n A= ij = ⇔ = dan untuk j i a j i a ij ij ≠ → = = → = 0 1 Contoh : = 1 0 0 0 1 0 0 0 1 3 3x INanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

Matriks Nol

Matriks Nol adalah suatu matrik dengan semua elemennya mempunyai nilai nol. Biasanya diberi simbol 0, dibaca matriks nol.

Matriks Elementer

Suatu matriks nxn dikatakan matriks elementer jika matriks tersebut dapat diperoleh dari matriks identitas n x n yakni In dengan melakukan operasi baris elementer tunggal.

Matriks Segitiga

MatriksL=

[ ]

aij suatu matriks bujur sangkar dikatakan segitiga bawah (lower triangular) jika aij =0 untuk i< j dan matriks U =[ ]

aij suatu matriks bujur sangkar dikatakan segitiga atas (upper triangular) jika aij =0 untuk i> j.Contoh : Segitiga bawah − = 1 4 5 3 0 3 5 2 0 0 2 1 0 0 0 5 L , Segitiga atas − = 3 0 0 0 6 2 0 0 3 2 1 0 5 3 2 1 U 2.2.3 Operasi Matriks

Perkalian Matriks dengan skalar

Jika A=

[ ]

aij adalah matriks mxn dan r adalah suatu skalar, maka hasil kali A dengan r adalah B=[ ]

bij matriks mxn dengan bij =raij(

1≤i≤m,1≤ j≤n)

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 Contoh : = 3 2 5 4

A dengan diberikan r=5 maka

= = 15 10 25 20 3 2 5 4 5 5A

Perkalian Matriks dengan Matriks

Jika A=

[ ]

aij adalah matriks mxp dan B=[ ]

bij adalah matriks pxn maka hasil kalidari matriks A dan matriks B yang ditulis dengan AB adalah C matriks mxn. Secara matematik dapat ditulis sebagai berikut :

pj ip j i j i ij a b a b a b c = 1 1 + 2 2 ++ a b

(

i m j n)

p k kj ik ≤ ≤ ≤ ≤ =∑

= 1 , 1 1 (2.6) Penjumlahan MatriksJika A=

[ ]

aij adalah matriks mxn dan B=[ ]

bij adalah matriks mxn maka penjumlahan matriks dari matriks A dan matriks B yang ditulis dengan C=[ ]

cij dengan) , , 2 , 1 ; , , 2 , 1 (i m j n b a cij = ij + ij = = . Pengurangan Matriks

Jika A=

[ ]

aij adalah matriks mxn dan B=[ ]

bij adalah matriks mxn maka pengurangan matriks dari matriks A dan matriks B yang ditulis dengan C=[ ]

cij dengan) , , 2 , 1 ; , , 2 , 1 (i m j n b a cij = ij − ij = = .

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

JikaA=

[ ]

aij matriks mxn maka matriks nxm denganAT =[ ]

aijt dan(

i m j n)

a

aijt = ji 1≤ ≤ ,1≤ ≤ disebut dengan transpose dari matriks A. Contoh: = = 2 5 3 6 1 2 2 6 5 1 3 2 3 2 2 3 T x x A A

Matriks mxn yang umum dapat ditulis :

[ ]

a i m j n a a a a A ij mn m n mxn 1,2, , 1,2, , 1 1 11 = = = ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ = Maka[ ]

a i m j n a a a a A A ji nm n m nxm T mxn 1,2, , 1,2, , 1 1 11 = = = ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ = = Invers MatriksMisalkan A matriks nxn disebut nonsingular (invertible) jika terdapat matriks B maka

n

I BA

AB= = (2.7)

matriks B disebut invers dari A. Jika tidak terdapat matriks B maka matriks A disebut singular (noninvertible).

Secara umum invers matriks A adalah :

( )

Adj( )

A A A det 1 1 = −Adjoint matriks A adalah suatu matriks yang elemen-elemennya terdiri dari semua elemen-elemen kofaktor matriks A, dengan Ki j adalah kofaktor elemen-elemen

n j

i

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 = nn n n n n K K K K K K K K K A adj 2 1 2 22 21 1 21 11

Sifat – sifat invers :

a. Jika A adalah matriks non singular, maka A−1 adalah nonsingular dan

( )

A−1 −1= Ab. Jika A dan B adalah matriks non singular, maka AB adalah nonsingular dan

( )

−1 = −1 −1A B AB

c. Jika A adalah matriks non singular maka

( ) ( )

−1 = −1A AT

Determinan Matriks

Misalkan A=

[ ]

aij adalah matriks nxn. Fungsi determinan dari A ditulis dengan det (A) atau A. Secara matematikanya ditulis dengan :( )

A A a ja j anjn 2 1 2 1 ) (det = =

∑

± dengan j1, j2,, jn merupakan himpunan{

n}

S= 1,2,, . Teorema

Jika A=

[ ]

aij adalah matriks nxn yang mengandung sebaris bilangan nol, maka 0 = A . Contoh : 0 0 0 0 4 1 2 3 2 1 = → = A A TeoremaNanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

Jika A adalah matriks segitiga n x n, maka A adalah hasil kali elemen-elemen pada diagonal utama, yaitu A =a11a22ann.

Contoh : − − = 3 0 0 0 5 5 0 0 2 6 4 0 8 5 8 2 4 4x A maka A =

( )( )( )( )

2 4 −5 3 =−120 TeoremaJika A adalah sebarang matriks kuadrat, maka A = AT .

Terorema

Jika A dan B adalah matriks kuadrat yang ordonya sama, maka AB = A B.

Contoh : = 1 2 1 3 2 2x A − = 8 5 3 1 2 2x B

( )

= 14 3 17 2 2 2x AB( )(

)

23 23 23 1 − = − = − = AB B ASehingga det (AB) = det (A) det (B)

2.3 Nilai Eigen dan Vektor Eigen

Jika A adalah matriks nxn, maka vektor tak nol X di dalam Rn dinamakan vektor eigen (eigenvektor) dari A jika AX adalah kelipatan skalar dari X; yakni,

X

AX =λ (2.8)

untuk suatu sakalar λ. Skalar λdinamakan nilai eigen (eigenvalue) dari A dan X dikatakan vektor eigen yang bersesuaian dengan λ.

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 = = ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ = n nxn nn n n nxn x x x X I a a a a A 2 1 1 1 11 , 1 0 0 0 0 0 0 0 1 0 0 0 0 1 0 0 0 0 1 , IX AX X X AX λ λ = ≠ = , 0 0 ) ( 0 = − = − X A I AX IX λ λ 0 0 → − = ≠ I A X λ

untuk memperoleh nilai λ.

λI−A =0 0 1 1 11 = − ⋅ ⋅ ⋅ − ⋅ ⋅ ⋅ ⋅ ⋅ ⋅ − ⋅ ⋅ ⋅ − nn n n a a a a λ λ

( )

n n n n n akar buah n a a a a f λ λ λ λ λ λ λ , , , 0 2 1 1 1 1 0 + + = + + = − − (2.9)Jika eigen value λn disubsitusi pada persamaan (λI−A)X =0, maka solusi dari eigen vektor Xn adalah (λnI −A)Xn =0.

Definisi :

Misalkan A=

[ ]

aij matriks nxn. Determinan( )

(

)

− − − − − − − − − = − = nn n n n n n a a a a a a a a a A I f λ λ λ λ λ 2 1 2 22 21 1 12 11 detNanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

( )

=det(

I −A)

=0f λ λ n

Dikatakan persamaan karakteristik dari A.

Matriks kuadrat A dinamakan dapat didiagonalisasikan (diagonalizable) jika terdapat matriks P yang dapat dibalik sehingga P-1AP diagonal, matriks P dikatakan mendiagonalisasi A.

Teorema : Jika A adalah matriks nxn, maka pernyataan – pernyataan berikut ekivalen satu sama lain.

1. A dapat didiagonalisasi

2. A mempunyai n buah vektor eigen bebas linier

2.4 Regresi Linier Berganda

Beberapa permasalahan regresi dapat mencakup lebih dari satu variabel bebas. Model-model regresi yang menggunakan lebih dari satu variabel bebas disebut Model-model regresi linier berganda. Regresi linier berganda merupakan salah satu teknik statistika yang digunakan secara luas. Bentuk umum dari regresi linier berganda adalah :

i ki k i i i X X X Y =β0 +β1 1 +β2 2 ++β +ε

Model ini menggambarkan sebuah bidang banyak dalam ruang k pada tingkat variabel-variabel bebas

{ }

XiDalam melakukan analisis regresi linier berganda, sering dijumpai masalah multikolinieritas pada peubah-peubah bebasnya (X). Akibat adanya pelanggaran terhadap salah satu asumsi yang disyaratkan pada penggunaan regresi linier tersebut, maka tentu mempengaruhi terhadap sifat-sifat penduga atau penaksir koefisien regresi linier gandanya. Adapun asumsi-asumsi yang mendasari analisis regresi berganda tersebut antara lain :

g. Nilai rata-rata kesalahan pengganggu nol, yaitu : E

( )

εi =0 untuk i=1, 2,,n h. Var( )

εi =E( )

εi2 =σ2, adalah konstan untuk semua kesalahan penggangguNanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

i. Tidak ada korelasi serial (autocorrelation) antara penggangu εi, berarti kovarian

( )

εiεj =0,i≠ jj. Peubah bebas x1,x2,,xn konstan dalam sampling yang terulang dan bebas terhadap kesalahan pengganggu εi.

k. Tidak ada multikoloniaritas diantara peubah bebas.

l. εi ≈N

(

0,σ2)

, artinya kesalahan pengganggu menyebar mengikuti distribusi normal dengan rata-rata 0 dan variansi σ2.Pengabaian multikolinieritas dalam analisis regresi akan mengakibatkan penduga koefisien regresi linier ganda relatif tidak stabil atau kurang tepat. Salah satu metode yang dapat digunakan mengatasi masalah multikolinieritas adalah dengan metode Regresi Ridge.

2.5 Penduga Parameter

Metode Kuadrat Terkecil

Metode kuadrat terkecil (Ordinary Least Square, OLS) merupakan salah satu metode untuk mengestimasi parameter pada regresi linier. Tujuan OLS adalah meminimumkan jumlah kuadrat dari kesalahan (error sum of square). Misalkan model yang akan diestimasi adalah parameter dari persamaan dengan :

i ki k i i i X X X Y =β0 +β1 1 +β2 2 ++β +ε (2.10)

Penjabaran dari persamaan adalah :

n nk k n n n k k k k X X X y X X X y X X X y ε β β β β ε β β β β ε β β β β + + + + + = + + + + + = + + + + + = 2 2 1 1 0 2 2 22 2 21 1 0 2 1 1 12 2 11 1 0 1

Persamaan-persamaan diatas dapat ditulis dengan menggunakan persamaan matriks yaitu :

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 ε β+ =X Y (2.11) Dengan = n y y y 2 1 Y = nk n n k k X X X X X X X X X 2 1 2 22 21 1 12 11 1 1 1 X = k β β β β 1 0 = n ε ε ε ε 2 1

Untuk mendapatkan penaksir-penaksir OLS bagi β, maka dengan asumsi klasik ditentukan dua vektor (βˆ dan e) sebagai :

= k β β β β ˆ ˆ ˆ ˆ 2 1 = n e e e e 2 1

Persamaan hasil estimasi dari persamaan (2.1.1) dapat ditulis sebagai :

e

+ =Xβˆ

Y

atau e=Y−Xβˆ (2.12)

Karena tujuan OLS adalah meminimumkan jumlah kuadrat dari kesalahan, yaitu =

∑

= k i i e 1 2 minimum maka : 2 2 2 2 1 1 2 k k i i e e e e = + + +∑

= [

]

e e e e e e e e T k k = = 2 1 2 1 (2.13) jadi : e e e T k i i =∑

=1 2 =(

Y−Xβˆ) (

T Y −Xβˆ)

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

=YTY −βˆTXTY −YTXβˆ+βˆTXTXβˆ

Oleh karena βˆT XTY adalah skalar, maka matriks transposenya adalah :

(

βˆTXTY)

T =YTXβˆjadi,

eTe=YTY−2βˆTXTY+βˆTXTXβˆ (2.14) Untuk menaksir parameterβˆ maka eTe harus diminimumkan terhadapβˆT, maka :

β β βˆ ˆ ˆ 2 1 2 X X Y X Y Y e T T T T T k i i = − +

∑

= 2ˆ ˆ ˆ 0 ˆ 1 2= − + = ∂ ∂∑

= β β β β e Y Y X Y X X T T T T T k i i T =−2XTY+2XTXβˆ =0 Atau XTXβˆ= XTYβˆ=

(

XTX)

−1XTY dengan ketentuan det(

XTX)

≠0 (2.15) Penduga βˆ merupakan penduga tak bias linier terbaik atau efisien bagi β yaitu :1. βˆ adalah penduga tak bias bagi β

Akan ditunjukkan bahwa βˆ adalah penaksir linier tak bias dari β. Dari persamaan (2.11) diketahui :

(

XTX)

1XTY ˆ = − β =(

XTX)

−1XT(

Xβ+ε)

=(

XTX)

−1XTXβ +(

XTX)

−1XTε =β +(

XTX)

−1XTε (2.16) Dengan(

XTX)

−1XTX =INanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009

( )

E[

(

X X) ( )

X Y]

E βˆ = T −1 T(

)

( )

(

)

( )

(

)

β β β β = = = = = − − − I X X X X X X X X Y E X X X T T T T T T 1 1 1 2. Kovarian( )

βˆ =(

XTX)

−1σ2 Cov( )

βˆ =E(

(

βˆ−E( )

βˆ)

(

βˆ−E( )

βˆ)

)

T(

)

(

)

(

(

) ( )

)

(

)

(

)

(

(

)

)

(

)

(

)

[

]

(

)

(

) ( )

(

)

1 2 1 1 1 1 1 1 1 1 σ ε ε εε ε ε β ε β β ε β − − − − − − − − − = = = = + − + − = X X E X X X X X X X X X X X X E X X X X X X E X X X X X X E T T T T T T T T T T T T T T T T T T T 2.6 Matriks KorelasiMisalkan kita ingin mengestimasi parameter dalam model :

i ik k i i i X X X Y =β0 +β1 1+β2 2 ++β +ε i = 1, 2, ... , n

Kita dapat menuliskan kembali model ini dengan sebuah perubahan intercept * 0 β sebagai :

(

i)

(

i)

k(

ik k)

i i X X X X X X Y =β *+β1 1− 1 +β2 2 − 2 ++β − +ε 0 Atau karena β0* =Y =Yi −Y =β1(

Xi1 −X1)

+β2(

Xi2 − X2)

++βk(

Xik −Xk)

+εiNanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 = kk k k k k T S S S S S S S S S X X 2 1 2 22 21 1 12 11 Dimana

∑

(

)

(

)

= − − = n i j ij k ik kj x x x x S 1Maka bentuk korelasi matriks XTX adalah :

= = 1 1 1 1 3 2 1 3 32 31 2 23 21 1 13 12 k k k k k k r r r r r r r r r r r r R C Dimana

(

)

12 jj kk kj kj S S S r = k, j = 1, 2, ... , n dan r11=r12==rkk =1 Transformasi ini dihasilkan dalam sebuah variabel regresi yaitu :* 2 2 1 1 * i ik k i i i bZ b Z b Z y = + ++ +ε

Dengan variabel-variabel barunya adalah :

(

)

(

)

jj i ij yy i i S n x x Z S n y y y 1 1 * * − − = − − = (2.17)Hubungan parameter βˆ1dan βˆ2dalam model baru dengan parameter β0,β1,β2 dalam model semula adalah :

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 k k kk y k k y y x x x y S S S S S S β β β β β β β β β β − − − − = = = = 2 2 1 1 0 22 2 2 11 1 1 ˆ ˆ ˆ (2.18)

(

)

1 1 2 − − =∑

= n y y S n i i y dan(

)

1 1 2 − − =∑

= n x x S n i i kk 2.7 MultikolinieritasIstilah multikolinieritas mula-mula ditemukan oleh Ragnar Frisch pada tahun 1934 yang berarti adanya hubungan linier antar sesama variabel bebas Xi. Maksud dari

adanya hubungan linier antara variabel bebas Xi adalah sebagai berikut : misalkan

terdapat dua variabel bebas X1 dan X2. Jika X1 dapat dinyatakan sebagai fungsi linier

dari X2 atau sebaliknya, maka dikatakan bahwa ada hubungan linier antara X1 dan X2.

Misalkan secara substansi diketahui bahwa total pendapatan (X1) adalah penjumlahan

pendapatan dari upah (X2) dan pendapatan bukan dari upah (X3), hubungannya adalah

X1=X2 + X3. Bila model ini diestimasi dengan OLS, maka β1 tidak dapat diperoleh karena

[

XTX]

−1 tidak dapat dicari, kejadian inilah yang dinamakan multikolinieritas sempurna.Dalam hal lain, misalkan :

Konsumsi = β1+β2pendapatan +β3kekayaan + ε

Ada hubungan positif antara kekayaan dan pendapatan, dalam arti seseorang yang kaya cenderung berpendapatan tinggi. Jika model ini di estimasi dengan OLS, β dapat ditentukan, tetapi variansi yang dihasilkan besar yang mengakibatkan galatnya besar dan interval kepercayaannya semakin besar, sehingga β kurang tepat.

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

Disimpulkanlah terjadi multikolinieritas yang hampir sempurna. Permasalahan ini membawa dampak yang tidak baik bagi model.

Pada analisis regresi, multikolinieritas dikatakan ada apabila bebarapa kondisi berikut dipenuhi:

a. Dua variabel berkorelasi sempurna (oleh karena itu vektor-vektor yang menggambarkan variabel tersebut adalah kolinier)..

b. Dua variabel bebas hampir berkorelasi sempurna yaitu koefisien korelasinya mendekati ±1.

c. Kombinasi linier dari beberapa variabel bebas berkorelasi sempurna atau mendekati sempurna dengan variabel bebas yang lain.

d. Kombinasi linier dari satu sub-himpunan variabel bebas berkorelasi sempurna dengan suatu kombinasi linier dari sub-himpunan variabel bebas yang lain. 2.8 Pendeteksian Multikolinieritas

Ada beberapa cara untuk mengetahui ada tidaknya multikolinieritas diantaranya adalah :

a. Faktor Variansi Inflasi

Adalah merupakan elemen diagonal utama dari invers matriks korelasi. Faktor variansi inflasi yang kecil, maka multikolinieritas lebih sederhana. Faktor inflasi yang melebihi 10 maka multikolinieritas di katakan ada.

b. Nilai Determinan

Nilai determinan terletak antara 0 dan 1. Bila nilai determinan satu, kolom matriks X adalah ortogonal (seregresi) dan bila nilainya 0 disana ada sebuah ketergantungan linier yang nyata antara kolom X. Nilai yang lebih kecil determinannya maka tingkat multikolinieritasnya lebih besar.

c. Kadang – kadang pemeriksaan masing – masing elemen matriks korelasi dapat menolong dalam mendapatkan multikolinieritas. Jika elemen

[ ]

rijmendekati satu, maka Xi dan Xj mungkin benar – benar ada masalah

multikolinieritas. Karena bila lebih dari dua variabel bebas yang dicakup dalam sebuah multikolinieritas tidak selalu memungkinkan kita untuk mendapatkan keberadaan multikolinieritas.

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

d. Jika pengujian F untuk regresi adalah nyata tetapi pengujian pada koefisien regresi secara individu tidak nyata, maka multikolinieritas mungkin menjadi ada.

2.9 Pengaruh Multikolinieritas

Multikolinieritas berpengaruh terhadap estimasi kuadrat terkecil dari koefisien regresi. Akan diperlihatkan bagaimanaβˆ, Variansi

( )

βˆ dan kovariansi j(

βˆj,βˆh)

, j,h=1,2,,k. jika ada multikolinieritas. Misalkan ada dua variabel bebas (X1,X2) dan Y variabel terikat sehingga model Y =β1X1+β2X2+ε Persamaan normal dengan kuadrat terkecil adalah(

XTX)

βˆ = XTY = 1 1 21 12 r r X XT = y y T r r Y X 2 1 Diperoleh

[

]

− − − − − − = − 2 12 2 12 12 2 12 12 2 12 1 1 1 1 1 1 1 r r r r r r X XTElemen diagonal utama dari matriks

[

XTX]

−1 adalah merupakan faktor variansi inflasi (VIF), yaitu : k j R C j jj 1,2, , 1 1 2 = − =Dengan R2j adalah koefisien determinansi dari regresi Xj

= = 1 2 12 rXX

r Korelasi antara X1 dan X2

Y Xj

r = Korelasi antara Xj dan Y

= y y r r r r 2 1 2 1 21 12 ˆ ˆ 1 1 β β

(

)

(

2)

12 1 12 2 2 2 12 2 12 1 1 1 ˆ 1 ˆ r r r r r r r ry y y y − − = − − = β βNanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

Jika ada multikolinieritas antara x1 dan x2 yang sangat erat dan r12 →1. Variansi dan kovariansi koefisien regresi menjadi sangat besar karena

( )

ˆ =C r2 →∞ V βj jj seperti r12 →1, galat(

)

= 2 →±∞ 12 2 1, ˆ ˆ β δ β CCov , variansi yang

besar untuk βˆ menyatakan bahwa koefisien regresi adalah perkiraan yang sangat j lemah. Pengaruh multikolinieritas adalah untuk memperkenalkan sebuah ketergantungan linier yang dekat dalam kolom matriks. Selanjutnya jika kita mengasumsikan X1TY →X2TY , seperti r12 →1, perkiraan koefisien regresi menjadi sama besarnya, tetapi berlawanan tanda, yaitu βˆ1=−βˆ2.

Masalah yang sama terjadi bila masalah multikolinieritas disajikan dan ada lebih dari dua variabel bebas. Umumnya elemen diagonal matriks C=

[

XTX]

−1dapat ditulis sebagai berikut :2 1 1 j jj R C − = 2 j

R dihasilkan dari meregresikan Xj pada variabel bebas lainnya. Kita katakan bahwa variansi dari βˆ “Di-inflated” dengan j

(

1−R2j)

−1. Konsekuensinya kita biasa menyebut :( )

2 1 1 ˆ j j R VIF − = βFaktor Variansi Inflasi untuk βˆ ini adalah ukuran penting perkiraan j Multikolinieritas.

2.10 Metode Regresi Ridge

2.10.1 Gambaran Umum Regresi Ridge

Regresi Ridge bertujuan untuk mengatasi multikolinieritas yang terdapat dalam regresi linier berganda yang mengakibatkan matriks XTX - nya hampir singular yang

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

pada gilirannya menghasilkan nilai estimasi parameter yang tidak stabil. Dalam bentuknya yang sederhana adalah sebagi berikut :

( )

c(

XTX cI)

1XTYˆ = + −

β

Dimana c adalah sebuah bilangan yang positif atau c≥0, umumnya c terletak antara interval 0<c<1.

Umumnya sifat dari penafsiran ridge ini memiliki variansi yang minimum sehingga diperoleh nilai VIF-nya yang merupakan diagonal utama dai matriks :

(

)

−1(

)

−1+ +cI X X X X cI X

XT T T

2.10.2 Gambaran Umum Ridge Trace

Ridge Trace adalah plot dari estimator regresi ridge secara bersama dengan berbagai kemungkinan tetapan bias c, konstanta c mencerminkan jumlah bias dalam estimator

( )

. ˆ cβ Bila c = 0 maka estimator βˆ

( )

c akan bernilai sama dengan kuadrat terkecil β, tetapi cenderung lebih stabil dari pada estimator kuadrat terkecil.Pemilihan tetapan bias c merupakan masalah yang perlu diperhatikan. Tetapan bias yang diinginkan adalah tetapan bias yang menghasilkan bias relatif kecil dan menghasilkan koefisien yang relatif stabil.

2.11 Uji Regresi Linier

Setelah model yang baik diperoleh kemudian model itu akan diperiksa. Pemeriksaan ini ditempuh melalui hipotesis. Untuk mengujinya diperlukan dua macam jumlah kuadrat sisa (JKS) yang dapat dihitung dengan rumus :

( )

2 ˆ x y ny JKR=βT T −( )

x y y y JKS = T −βˆT T (2.19) JKS JKR JKT = +Dengan JKT : jumlah kuadrat total.

Dengan JKR derajat kebebasannya sebanyak k dan (n-k-1) untuk derajat kebebasan JKS.

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 ) 1 /( / − − = k n JKS k JKR Fhitung (2.20)

F statistik inilah yang dipakai untuk menguji kelinieran suatu regresi. Jika

Tab hitung F

F > dengan (taraf signifikan yang dipilih) maka dapat disimpulkan bahwa regresi linier.

2.12 Uji Koefisien Korelasi Ganda

Koefisien korelasi ganda yang disimbolkan dengan refraksi dihitung dengan rumus : JKT

JKR

R2 = (2.21)

Jadi statistik yang digunakan untuk menguji hipotesa nol adalah :

(

)

(

)

1 / 1 / 2 2 − − − = k n R k R F (2.22)Tolak hipotesa nol bahwa koefisien korelasi berarti jika Fhitung >FTab dalam hal ini hipotesa bahwa koefisien korelasi ganda berarti harus diterima.

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 BAB 3 PEMBAHASAN 3.1 Regresi Ridge

Regresi Ridge merupakan salah satu metode yang digunakan untuk mengatasi masalah multikolinieritas melalui modifikasi terhadap metode kuadrat terkecil. Modifikasi tersebut ditempuh dengan cara menambah tetapan bias c yang relatif kecil pada diagonal utama matriks XTX, sehingga koefisien estimator Ridge dipenuhi dengan besarnya tetapan bias c.

Estimator regresi ridge diperoleh dengan meminimumkan jumlah kuadrat galat untuk model :

ε β + = X Y

Dengan syarat memenuhi kendala tunggal

∑

β = ρ = k j j 1 2 ˆ Dari persamaan (2.10)( )

+(

∑

−)

+ − = β β β ρ ε ε ˆ ˆ 2 ˆ2 2 T T j T T cI X X Y X Y Ydengan menggunakan syarat minimum persamaan diatas didiferensialkan terhadap βˆdan estimasi regresi Ridge diperoleh sebagai berikut :

0 ˆ 2 ˆ 2 2 ˆ =− − β + β = β δ ε δε cI X X Y XT T T

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009. USU Repository © 2009 XTXβˆ+cIβˆ = XTY

(

XTX +cI)

βˆ =XTY βˆ*( )

c =(

XTX +cI)

−1XTY Sifat dari estimator Ridge adalah :1. Bias

( )

( )

c(

X X cI)

X Y E βˆ = T + −1 T dengan Y = Xβˆ(

)

1 βˆ X X cI X XT + − T = 2. Variansi Minimum( )

[ ]

(

T)

T[

(

T)

T]

T X cI X X X cI X X c Varβˆ = + −1∑

+ =(

XTX +cI)

−1XTσ2IX(

XTX +cI)

−1 =σ2(

XTX +cI)

−1XTX(

XTX +cI)

−1Sehingga nilai VIF merupakan diagonal utama dari matriks

(

)

−1(

)

−1 + +cI X X X X cI X XT T T . 3.2 Ridge TraceRidge Trace merupakan plot dari estimator regresi Ridge secara bersama dengan berbagai kemungkinan nilai tetapan bias c. Konstanta c mencerminkan jumlah bias dalam estimator βˆ

( )

c . Bila c = 0 maka estimatorβˆ( )

c akan bernilai sama dengan estimator kuadrat terkecil β. Bila c > 0, koefisien estimator Ridge akan bias terhadap parameter β, tetapi cenderung lebih stabil dari pada estimator kuadrat terkecil. Umumnya nilai c terletak pada inverval 0<c<1.Pemilihan besarnya tetapan bias c merupakan masalah yang perlu diperhatikan. Tetapan bias yang diinginkan adalah tetapan bias yang menghasilkan relatif kecil dan menghasilkan koefisien estimator yang relatif stabil.

Nanang Pradipta : Metode Regresi Ridge Untuk Mengatasi Model Regresi Linier Berganda Yang Mengandung Multikolinieritas, 2009.

USU Repository © 2009

Suatu acuan yang digunakan untuk memilih besarnya c, dengan melihat besarnya VIF dan melihat pola kecenderungan Ridge Trace. VIF merupakan faktor yang mengukur seberapa besar kenaikan variansi dari koefisien estimator βˆ k dibandingkan terhadap variabel bebas lain yang saling ortogonal. Bila diantara variabel bebas tersebut terdapat korelasi yang tinggi, nilai VIF akan besar. VIF memiliki nilai mendekati 1 jika variabel bebas X tidak saling berkorelasi dengan variabel-variabel bebas lainnya.

Determinan dari XTX dapat digunakan sebagai indeks dari multikolinieritas. Nilai determinannya yaitu 0≤ XTX ≤1. Jika XTX = 1 maka terdapat hubungan yang orthogonal antara variabel bebasnya. Jika XTX =0 terdapat hubungan yang linier diantara variabel-variabel bebasnya. Dengan kata lain bahwa tingkat multikolinieritas dilihat dari XTX mendekati 0.

Oleh karena itu nilai VIF untuk koefisien regresi βˆ

( )

c didefinisikan sebagai diagonal utama dari matriks(

XTX +cI)

−1XTX(

XTX +cI)

−1, maka sama halnya dengan uraian diatas bahwa(

XTX +cI)

−1XTX(

XTX +cI)

−1 =1Contoh Kasus :

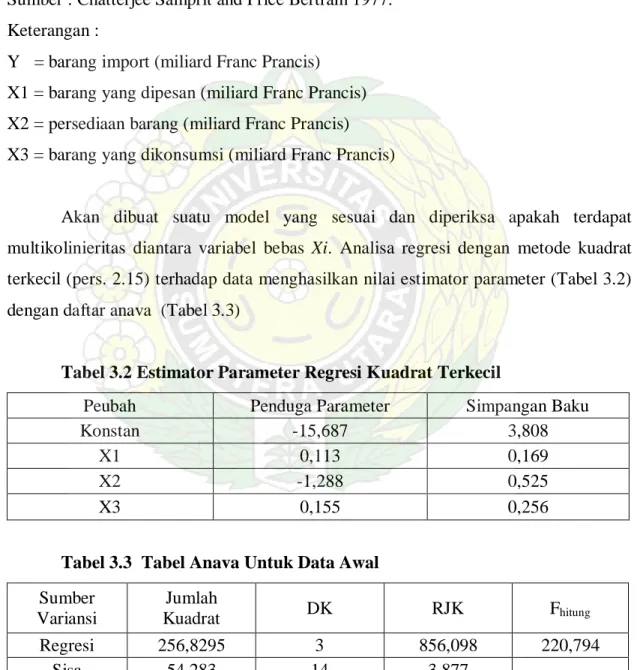

Untuk memperjelas penggunaan Regresi Ridge dalam mengatasi multikolinieritas pada variabel-variabel bebas, berikut ini akan dibahas suatu contoh kasus yang memiliki multikolinieritas diantara variabel-variabel bebasnya. Data yang akan dibahas adalah data yang tertera dalam tabel berikut :

Tabel 3.1 Tabel barang import dan faktor – faktor yang mempengaruhinya Tahun Y X1 X2 X3 1949 15,9 149,3 4,2 108,1 1950 16,4 161,2 4,1 114,8 1951 19,0 171,5 3,1 123,2 1952 19,1 175,5 3,1 126,9 1953 18,8 180,8 1,1 132,1 1954 20,4 190,7 2,2 137,7 1955 22,7 202,1 2,1 146,0 1956 26,5 212,4 5,6 154,1