Dalam kegiatan pengembangan teknologi,Dalam hal ini merupakan kegiatan lanjutan dari proses akusisi. Data seismik yang diperoleh dari kegiatan akusisi, adalah data yang belum terolah (raw data) sehingga diperlukan beberapa tahapan pengolahan (Processing) untuk mendapatkan gambaran kondisi atau penampang seismik bawah permukaan sampai mendekati kondisi sebenarnya. Adapun pengolahan data yang dilakukan di atas kapal (onboard

processing) hanyalah bersifat sementara yang tujuannya untuk mengetahui

seberapa baik kualitas data yang diperoleh dari akusisi.

Untuk mendapatkan penampang seismik yang baik dan presisi, maka diperlukan pengolahan data yang lebih sistematis. Proses ini pada umumnya memakan waktu yang relatif cukup lama dengan menggunakan perangkat lunak tertentu yang disertai perangkat keras yang memiliki kemampuan pemrosesan yang cepat dan kapasitas penyimpanan data yang besar. Pada dasarnya pengolahan data seismik bersifat relatif, proses yang dilakukan amat bergantung dari kebutuhan dan kualitas data.

Setelah tahap processing selesai tahap selanjutnya adalah tahap interpretasi yang merupakan tahap akhir dari pengolahan data seismik. Secara umum proses interpretasi bertujuan untuk menterjemahkan penampang seismik dalam analisa atau bahasa geologi.

Dari penjelasan di atas maka harus dibuat flowchart baru perlu diciptakan untuk mengatasi hal tersebut.

1. Input data

Input data merupakan proses pemasukkan data kedalam software dan reformatting data ke dalam format software (seg-y promax).

2. Geometry

Geometry dilakukan untuk menggabungkan data seismic dengan desain akuisisi yang dilakukan. Karena data seismic hanya menyimpan data berupa FFID, shot point, dan channel perlu ditambahkan data lain sepert shot point koordinat, CDP, offset dan lainnya untuk mempermudah proses pengolahan data.

3. Editing

Editing dilakukan untuk menghilangkan trace-trace yang dianggap error dan menghilangkan gelombang yang dapat mengganggu proses pengolahan data (gelombang langsung dan gelombang refraksi).

4. Filtering

Filtering adalah proses pemilihan frekuensi yang akan digunakan dalam pengolahandata selanjutnya. Frekuensi perlu untuk dipilih untuk menghasilkan data yang bebas noise.

5. FK filter

FK filter merupakan filter yang mengkoheren linier pada persamaan gelombang dengan domain ruang-waktu (t-z), ditransformasikan ke dalam domain frekuensi-bilangan gelombang akibat kehadiran lintasan miring (dip). noise koheren berupa ground-roll, gelombang langsung dan gelombang bias yang secara umum

Input data Geometry Editing

(muting, killing) Filtering FK Filter

Dekonvolusi Velocity analysis srme STACK radon

merupakan refleksi pertama dalam data seismik. Noise pada jenis ini dapat ditangani dari energi refleksi dalam domain f – k. Kelebihan metode ini adalah waktu komputasi yang cepat dan dapat meresolusi struktur dengan kemiringan yang curam, dan dapat dilakukan pada data dengan rasio signal to noise yang rendah (data buruk). Dan diharapkan dapat merubah rasio singnal to noise menjadi tinggi (data baik)

6. Deconvolusi

Deconvolusi dilakukan untuk mempertajam sinyal refleksi dan menghilangkan multiple jarak pendek.

7. Velocity Analysis

Velocity analisis merupakan proses penentuan kecepatan bawah permukaan berdasarkan data seismic yang dimiliki.

8. Stack

Merupakan proses penggabungan beberapa trace seismic dalam satu CDP yang sama guna menghasilkan suatu penampang bawah permukaan.

9. SRME

SRME adalah metoda untuk menghilangkan energi multiple yang dihasilkan oleh batas air-udara. Multiple yang dihasilkan oleh batas air-udara ini kadang-kadang sangat sulit dihilangkan dengan menggunakan metoda demultipel konvensional seperti Radon ataupun Tau-P (Geotrace).Metoda SRME memiliki tiga tahap utama: pertama, menghilangkan noise non fisis, regulasisasi data sehingga diperoleh grid sumber-penerima yang konstan, interpolasi near dan intermediate offset yang hilang, menghilangkan gelombang langsung dan gelombang permukaan. Kedua: prediksi multiple, prediksi ini didasarkan pada observasi bahwa multiple yang terkait dengan permukaan

dapat diprediksi melalui konvolusi temporal dan spasial dari data itu sendiri (Berkhout, 1982). Ketiga: data input dikurangi dengan multiple yang terprediksi pada tahap dua (Long et al., 2005).

INPUT DATA DAN REFORMATTING DATA 1. Input dan reformatting data berdomain SEG-Y

Data dengan format SEG-Y merupakan format data standard yang digunakan dalam pengolahan data seismic. Data dalam format ini setidaknya telah mengalami satu kali reformatting ke dalam domain software apapun.

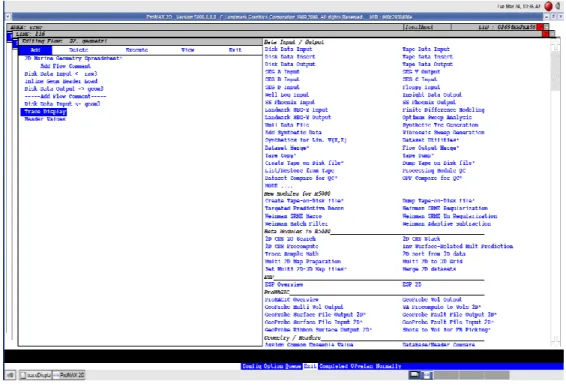

Gambar 1. Flow input data.

Gambar 2. Parameter input data

GEOMETRY

Geometry adalah proses penggabungan data parameter akuisisi dengan data seismic. Hal ini dilakukan karena data seismic hasil rekaman di lapangan hanya akan

mengandung data SOU_SLOC, FFID, dan channel. SOU_SLOC menunjukkan nilai station, FFID menunjukkan nomor tembakan, dan channel menunjukkan channel yang aktif dalam perekaman data seismic. Untuk mempermudah penyajian data dalam pengolahan data parameter akuisisi lain perlu di tambahkan dalam data seismic seperti koordinat shot point, koordinat receiver, koordinat CDP, penomoran CDP, offset, dan lainnya. Oleh karena itu geometry perlu dilakukan.

Geometry pun sangat penting dalam menentukan posisi sebenarnya lintasan yang

diakuisisi. Tanpa geometry yang benar lintasan pun akan meleset dari posisi yang seharusnya, tentu saja hal ini tidak boleh sampai terjadi.

Input dari

Langkah proses geometry :

1. Memasukkan parameter akusisi

Parameter akuisisi dimasukkan untuk membangun skema geometry. Parameter yang dimasukkan antara lain source depth, stremer depth, azimuth/ship direction, receiver interval, shot interval, near channel, far channel, offset, first station, station increment, dan channel increment.

Gambar 4. Setup parameter

Gambar 5. Auto2D parameter

Rec. int Shot. int Sail direction Gun depth Streamer depth Near channel Far channel Channel inc. Min. offset Receiver int. Jumlah shot 1st SOU_SLOC SOU_SLOC inc Direction Shot int.

2. Tabel source

Tabel source merupakan tabel untuk memeriksa parameter yang sudah kita masukkan. Table ini mengacu pada source, termasuk koordinat X dan Y. Data-data yang berada di dalam table ini adalah Data-data dari hasil setingan pada prosedur sebelumnya, yaitu Setup dan Auto-2d. Data tersebut belum sesuai dengan koordinat lintasan yang sebenarnya sehingga perlu disesuaikan dengan data UKOOA.

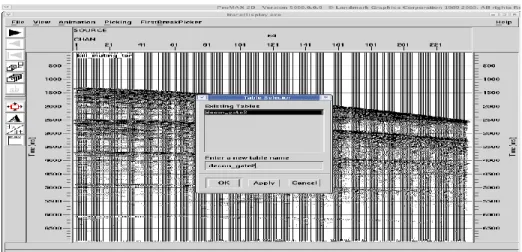

Gambar 6. Table source.

3. Binning

Binning merupakan proses perhitungan CDP number, koordinat, dan lainnya sampai dapat terbangun database dalam ProMAX. Tahap ini dilakukan dalam 3 tahap, antara lain terdapat pada gambar di bawah ini (gambar 6,7 dan 8).

Gambar 7. Penyocokan pattern dan source.

Gambar 9. Finalisasi.

4. Penggabungan data seismic dan desain geometry.

Setelah desain geometry terbangun terakhir adalah menggabungkannya dengan data seismic. Gambar 10 menunjukkan flow penggabungan kedua data tersebut.

TRACE EDITING

Editing trace merupakan proses menghapus data-data yang dianggap rusak ataupun dapat mengganggu dalam proses pengolahan data selanjutnya. Editing trace dibagi menjadi 2 yaitu:

1. Trace Muting

Trace muting merupakan proses menghilangkan nilai amplitude gelombang yang dianggap akan mengganggu proses pengolahan data selanjutnya seperti gelombang langsung dan gelombang refraksi. Proses trace muting ini adalah dengan mengalikan amplitude gelombang yang terpilih dengan nol.

2. Trace Killing

Trace killing merupakan proses menghapus 1 atau lebih trace yang dianggap error pada saat akuisisi dilakukan. Seperti receiver yang terlalu noisy. Proses trace killing ini sama dengan proses trace muting yaitu mengalikan amplitude gelombang dengan nol.

Dalam data Sumatra line 216 terdapat trace yang rusak sehingga perlu dilakukan killing pada terce 12,24,60,96,132,168,204,dan 240.

Gambar 11. Membuat file parameter muting.

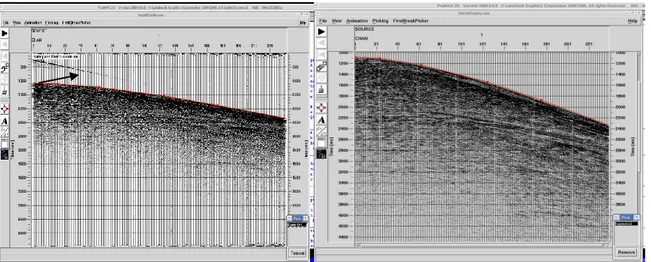

Gambar 12. Sebelum dan setelah trace muting.

Gambar 13. Flow trace muting.

BANDPASS FILTER DAN SPECTRAL ANALISIS

Dengan menggunakan perangkat lunak ProMAX 2D ver. 5000.0.0.0 File mute

(Landmark Graphic Co.), pembangunan rentang frekuensi bandpass filter dilakukan dengan menggunakan flow sebagai berikut.

1. Data

Data yang dijadikan input adalah shot gather yang sudah dilakukan geometry sebelumnya dan belum dilakukan editing agar dapat melihat seluruh kandungan frekuensinya.

2. Spectral Analysis

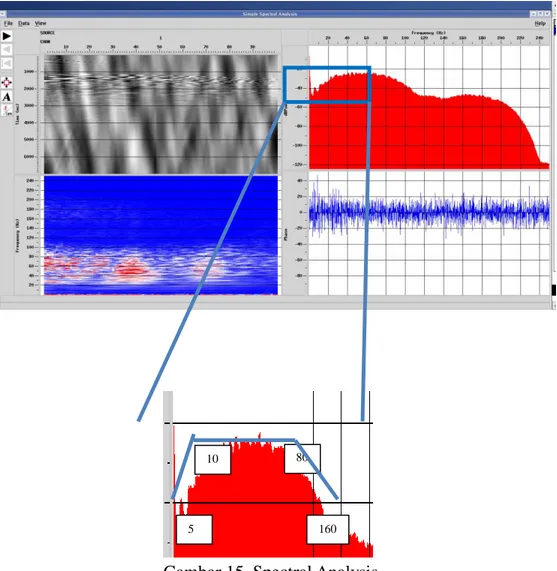

Spectral analysis dilakukan untuk melihat kandungan frekuensi dalam data. Dari spectral analysis ini kita dapat melihat frekuensi dominan yang terkandung, frekuensi yang bersifat noise, sehingga dapat menentukan desain frekuensi yang akan dipergunakan. Berikut flow untuk melakukan spectral analysis.

Gambar 14. Flow spectral analysis.

Hasil flow sebelumnya Spectral Analysis Bandpass Filter Hasil bandpass

Yang perlu diperhatikan adalah mengisi ‘number of traces per analysis location’ sebesar banyaknya channel yang aktif saat akuisisi.

Gambar 15. Spectral Analysis.

Frekuensi yang digunakan pada umumnya adalah yang berada diatas 3 dB. Karena frekuensi ini dianggap frekuensi sinyal dan frekuensi dominan pada data. Desain frekuensi yang digunakan untuk bandpass gambar di atas adalah 5-10-80-160 Hz.

5

10 80

3. Bandpass filter

Setelah desain bandpass dibangun, aplikasikan bandpass dengan flow sebagai berikut.

Gambar 16. Flow aplikasi bandpass filter.

FK FILTER

FK filter merupakan filter yang mengkoheren linier pada persamaan gelombang dengan domain ruang-waktu (t-z), ditransformasikan ke dalam domain frekuensi-bilangan gelombang akibat kehadiran lintasan miring (dip). noise koheren berupa ground-roll, gelombang langsung dan gelombang bias yang secara umum merupakan refleksi pertama dalam data seismik. Noise pada jenis ini dapat ditangani dari energi refleksi dalam domain f – k. Kelebihan metode ini adalah waktu komputasi yang cepat dan dapat meresolusi struktur dengan kemiringan yang curam, dan dapat dilakukan pada data dengan rasio signal to noise yang rendah (data buruk). Dan diharapkan dapat merubah rasio singnal to noise menjadi tinggi (data baik)

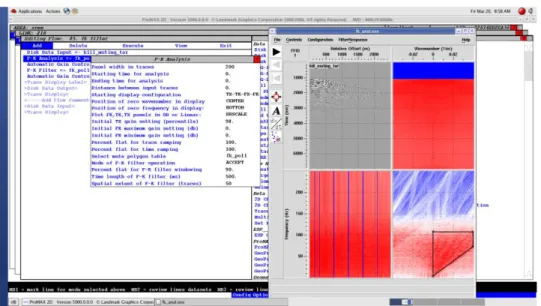

Gambar 17. Flow fk filter.

Gambar 18. parameter fk filter.

DECONVOLUTION

Perangkat lunak yang digunakan untuk melakukan proses dekonvolusi ini adalah ProMAX 2D ver. 5000.0.0.0 (Landmark Graphic Co.). Dekonvolusi yang digunakan adalah Predictive Deconvolution.

Pada umumnya proses dekonvolusi digunakan untuk meningkatkan broadband frekuensi data seismik, membuat wavelet menjadi lebih spike, dan mengatenuasi keberadaan

multiple. Namun, dekonvolusi yang dilakukan pada data Makassar bertujuan untuk mempertajam image bawah permukaan dengan membuat wavelet menjadi lebih spike sehingga memilki resolusi yang lebih tinggi. Setelah melakukan observasi terhadap data melalui penampang single channelnya, data Makassar tidak terlalu dipengaruhi oleh keberadaan multiple akibat seafloor sehingga dekonvolusi tidak dilakukan untuk mengatenuasi multiple.

Keefektifan proses predictive deconvolution akan sangat tergantung dari 2 parameter dekonvolusi yaitu parameter lag (α) dan parameter length (n). Kedua parameter ini didapatkan dari autokorelasi masing-masing trace data seismik. Untuk mendapatkan nilai yang optimum perlu dilakukan trial and error beberapa nilai parameter yang kemudian dibandingkan dan diambil sesuai dengan hasil yang paling baik. Parameter yang optimum adalah parameter yang mampu mempertajam spike sehingga image bawah permukaan menjadi lebih baik dan menambah broadband frekuensi.

Berikut flowchart dekonvolusi :

Setelah dilakukan autokorelasi dan penentuan parameter α, n (lihat TN autokorelasi dan TN penentuan parameter predictive deconvolution), barulah proses predictive deconvolution dilakukan. Untuk dapat melakukan dekonvolusi diperlukan time gate dekonvolusi. Time gate ini berfungsi sebagai selang waktu dimana wavelet akan diekstraksi dari data seismic untuk selanjutnya digunakan dalam proses dekonvolusi.

Pembuatan gate dekonvolusi

Pembuatan gate dekonvolusi hampir sama dengan gate autokorelasi. Bedanya adalah untuk gate dekonvolusi menggunakan dua layer. Rentang waktu ini adalah zona untuk mengekstrak wavelet. Shot gather (seg-y) Autokorelasi α, n Predictive Deconvolution Shot gather (seg-y)

Gambar 19. Flow picking time gate dekonvolusi.

Gambar 18. Picking time gate, masukkan nama file untuk menyimpan hasil picking.

Gambar 20. Picking time gate untuk layer 1 (biru), kemudian klik kanan untuk

new layer dan lakukan picking yang layer 2 (merah).

Proses Dekonvolusi

Dekonvolusi menggunakan data dengan format shot gather yang sudah dilakukan bandpass dan muting. Masukkan nilai α dan n. Lakukan berulang kali dan simpan data pada file yang berbeda untuk kemudian dibandingkan.

Gambar 21. Flow predictive deconvolution, masukkan nilai parameter α dan n serta file picking time gate.

VELOCITY ANALISIS

Velocity analisis merupakan tahapan processing yang paling penting karena merupakan faktor yang paling menentukan dari hasil (penampang) yang akan dihasilkan. Velocity analisis merupakan tahapan processing untuk mendapatkan penampang kecepatan bawah permukaan. Kecepatan ini kemudian dapat dipakai untuk berbagai macam process seperti true amplitude recovery, NMO correction, dan migrasi. Tahapan velocity ini dapat dilakukan berulang-ulang sehingga mendapatkan penampang kecepatan yang terbaik.

Banyak metoda untuk melakukan velocity analisis diantaranya constan velocity analysis, coherency, dan semblance. Metoda yang digunakan dalam pengolahan data ini adalah metoda semblance.

Dengan menggunakan perangkat lunak ProMAX 2D ver. 5000.0.0.0 (Landmark Graphic Co.), berikut flow velocity analisis.

1. Data

Data yang menjadi masukkan dalam process velocity analisis haruslah data hasil preprocessing terbaik sehingga tidak ada keambiguan saat menentukan nilai kecepatan. Data hasil preprocessing terbaik adalah data yang sudah dilakukan geometry, editing (muting, trace edit), true amplitude recovery, bandpass, dekonvolusi sehingga data akan bebas dari ambient noise serta multiple jarak pendek.

1. Supergather

Data hasil preprocessing terbaik tadi kemudian diubah dalam bentuk supergather untuk kemudian dipakai dalam perhitungan semblance yang menjadi dasar velocity analysis.

Data Supergather Velocity Analysis

Velocity Section

Gambar 22. Flow velocity analysis

Perlu diperhatikan, nilai maximum fold harus disesuaikan pada data yang dapat dilihat pada database dan nilai minimum dan maksimum CDP disesuaikan dengan data.

Gambar 23. Fold coverage database. 2. Velocity analysis

Sebelum melakukan picking velocity, diperlukan perhitungan semblance terlebih dahulu yang parameternya disesuaikan dengan keadaan data. Perhitungan itu disebut precomputed. Sebelum precomputed data seismik di AGC untuk meratakan nilai semblance, sehingga mempermudah saat picking velocity.

Terdapat beberapa parameter yang perlu untuk disesuaikan antara lain : - Absolute offset of first bin center = near offset (m)

- Maximum offset = (jarak antar rec x jumlah rec) + near offset (m)

- Minimum semblance analysis value = di bawah kecepatan air laut (data laut), bawah kecepatan lapisan pertama (data darat) (m/s)

- Maximum semblance analysis value = di atas kecepatan tertinggi lapisan (data laut/darat) (m/s)

Surface Related Multiple Elimination (SRME)

Di dalam software proMAX V.5000 untuk melakukan proses SRME terdapat 5 modul yang digunakan, yaitu:

1. Weinman SRME regularization 2. Weinman SRME Macro

3. WEinman SRME Un-Regularization 4. Weinman Match Filter

5. Weinman Adaftive

Kelima modul tersebut dijalankan secara berurutan mulai dari Weinman SRME regularization sampai dengan Weinman Adaftive, untuk menjalankan modul tersebut data yang akan digunakan adalah data prepocesing yang telah terbebas dari direct wave.

1. Weinman SRME regularization

Modul ini merupakan modul yang akan mengatur ensemble ensemble untuk tahapan metode SRME, hal yang paling penting adalah pada data yang akan digunaka untuk SRME adalah offsetnya harus naik secara teratur, hal ini sangat perpengaruh dalam tahapan regularization sehingga trace trace yang akan diregularization akan terektrapolasi dari awalnya offset minimum menjadi offset nol. Dalam hal ini dibutuhkan velocity RMS

Input

Data inputa yang dibutuhkan adalah ensemble trace yang di-sort dalam AOFFSET.

Perameter yang digunakan

- Primary key adalah SIN( source index number) - Offset increment

- maximum offset - velocity

Gambar 25. Weinman SRME regularization

2. Weinman SRME Macro

Modul ini merupakan modul yang akan mengkonvolusi atra trace yang dapat memprediksi multiple permukaan . pada modul ini proses perhitungan nya cukup lama sehingga diharapkan menggunakan PC atau workstation yang stabil sehingga tidak terjadi eror pada data.

Gambar 26. Weinman SRME macro

Input

Data input yang dibutuhkan adalah hasil dari proses SRME regularization yang offsetnya telah teratur mulai dari no sampai

maksimum.

Perameter yang digunakan

- Primary key adalah SIN( source index number) - nilai maksimum lama perekaman trace

- nomor max shot

- nilai maxsimim frek multiple yang akan diproses - nama file header dari trace

- panjang taper yang akan digunakan - frekuensi taper yang akan diterapkan

- perbandingan antara interval shot dan receiver

Outpot

Adalah model dari prediksi multiple dari offset nol hingga maxsimum

3. Weinman SRME Un-Regularization

Dalam modul ini merupakn modul yang akan menggabungkan data prepro dengan model prediksi multiple dari hasil macro. Dikarenakan kedua offset dari inputan berbeda, maka akan dikembalikan dari offset nol ke offset minimum.

Input

Data input yang dibutuhkan adalah data preprocessing dan hasil dari proses SRME macro

Perameter yang digunakan

- parameter kecepatan,yaitu hasil dari velan Outpot

Adalah gabungan dari data awal yaitu pre-processing dengan data model prediksi multipel

Gambar 27. Weinman SRME un-regularization

4. Weinman Match Filter

Modul ini akan menyelaraskan ensemble yang memiliki gabungan data input awal dan data prediksi multiple. Keberhasilan dari modul ini sangat berpengaruh pada parameter parameter yang akan digunakan.

Input

Data input yang dibutuhkan adalah hasil dari proses SRME Un-Regularization

Perameter yang digunakan

- urutan dari input yang terletak pada msing masing ensemble, terdapan 4 pilihan yaitu :

DDD…NNN = data input dan model prediksi multipel

DNDN…DN = data input dan model prediksi multiple terletak bergantian

NNN…DDD = model prediksi multiple dan data input

NDND…ND = prediksi multiple dan data input terletak bergantian - penentuan waktu awal yang didesain sebagai offset nol

- picking horizon

- panjang window yang akan digunakan

- penyesuaian nilai kecepatan pada awal window - offset minimum

- offset maxsimum

- panjang filter yang akan digunakan

Outpot

Adalah gabungan dari data awal yaitu ensemble dengan data awal yang tidak berubah dengan model prediksi multiple yang telah dikenakan adiptif filter

5. Weinman Adaftive Subtraction

Dalam rangkain proses SRME , modul Weinman Adaftive Subtraction merupakan modul yang paling terakhir dijalankan. Prinsip dari modul ini merupakan pengurangan adaptif dengan harapan pada ensemble yang akan dikeluarkan nanti telah terbebas dari multiple.

Gambar 28. Weinman SRME Adaftive Subtraction

Input

Data input yang dibutuhkan adalah hasil dari proses SRME Macth Filter

Perameter yang digunakan

- urutan dari input yang terletak pada msing masing ensemble, terdapan 4 pilihan yaitu :

DDD…NNN = data input dan model prediksi multipel

DNDN…DN = data input dan model prediksi multiple terletak bergantian

NNN…DDD = model prediksi multiple dan data input

NDND…ND = prediksi multiple dan data input terletak bergantian - pilihan keluaran yang akan digunakan

Signal = keluaran adalah estimasi signal yang terbebas dari noise

Noise = keluaran adalah model prediksi multiple yang telah di filter

Both = gabungan dari noise dan signal Outpot

STACK

Stack merupakan proses menjumlahkan trace-trace seismic dalam satu CDP setelah dikoreksi NMO. Oleh karena itu, diperlukan kecepatan untuk melakukan proses ini. Kecepatan yang digunakan merupakan kecepatan terbaik hasil velocity analisis untuk selanjutnya digunakan dalam koreksi NMO. Berikut flowchart stack :

1. Input data

Data masukkan untuk melakukan stacking adalah CDP gather yaitu gather seismic yang disort CDP pada primary header dan aoffset pada secondary offsetnya.

Gambar 29. input proses stacking. Input data CDP gather Koreksi NMO Stacking proses Output Stack section

2. Koreksi NMO

Koreksi NMO adalah koreksi waktu gelombang untuk menghilangkan fungsi jarak, sehingga setiap trace dalam satu CDP merupakan zero offset.

Gambar 29. Stack sebelum diSRME

RADON FILTER

Proses filter radon umumnya dilakukan untuk menghilangkan multiple periode yang panjang. Teknik yang digunakan adalah dengan memisahkan multiuple dan sinyal primer pada data seismic berdasarkan moveout-nya. Filter radon dengan domain time vs moveout akan menampilkan nilai- nilai residual moveout dimana nilai di bagian sebelah kanan (lebih besar dari nol) merupakan indikasi adanya energy multiple. Bagian yang dianggap multiple tersebut kemudian dipotong dan dipisahkan dari data primer. Masukan dari proses ini adalah data yang telah dilakukan proses NMO dengan header primer berupa cdp gather dan header sekunder nya berupa absolute value of offset, karena penentuan residual moveout tersebut tergantung pada hasil NMO.

Transformasi Radon yang dipakai adalah transformasi radon hiperbolik atau parabolic sehingga semua event yang berbentuk hiperbolik akan terkena proses ini. Untuk melihat kenampakan domain radon yang mengelompokan secara terpisah anatar sinyal dan multiple berdsarkan moveoutnya, Dilakuakan proses radon analysis.

Dengan menggunakan perangkat lunak ProMAX 2D ver. 5000.0.0.0 (Landmark Graphic Co.), berikut flow Radon Filter

3. Data

Data yang menjadi masukkan dalam process Radon Filter haruslah data hasil preprocessing terbaik sehingga tidak ada keambiguan saat menentukan nilai kecepatan. Data hasil preprocessing terbaik adalah data yang sudah dilakukan geometry, editing (muting, trace edit), true amplitude recovery, bandpass, dekonvolusi sehingga data akan bebas dari ambient noise serta multiple jarak pendek. Disk Data Input NMO Interactive Radon Radon Filter

4. NMO

Koreksi NMO adalah koreksi waktu gelombang untuk menghilangkan fungsi jarak, sehingga setiap trace dalam satu CDP merupakan zero offset

Gambar 30. Flow Radon Filter

5. Interactive Radon

Sebelum dilakukannya Radon filter step yang harus dilewati adalah interactive radon atau radon analisa. Dimana pada tahap ini adalah bertujuan untuk mengelompokan multiple dan sinyal data seismic berdasarkan moveout nya sebelum dilakukan Radon Velocity Filter.

Gambar 31. Interactive Radon

Gambar 32. Interactive Radon

6. Radon Filter

Pada parameter number of P-Value di isi oleh angka yang lebih besar dari fold maksimum. Parameter minimum of P-Value of interest biasanya diisi -100,hal ini untuk mengatasi refleksi promer yang mengalami overcorrected,

Sedangkan parameter maximum p-value interest kurang dari nilai maximum offset dibagi dengan kecepatan RMS minimum.